随着视频图像处理技术的快速发展,基于计算机视觉的自动报靶系统因快速、精确、安全、低成本等优点被广泛应用研究[1]。胸环靶图分割作为自动报靶系统的重要基础和技术难点,实现复杂靶场环境下靶图的精准分割工作。现有的自动报靶系统研究成果基本建立在无复杂靶场背景干扰的前提下进行后续报靶工作的研究[2-4],严重制约了基于计算机视觉的自动报靶系统由理论研究向实际应用的转化进程。因此,对于复杂靶场环境下的胸环靶图分割方法进行研究具有重要意义和实际应用价值。

现有的胸环靶图分割算法主要基于图像的三大底层特征,即颜色、纹理、形状,展开研究,利用胸环靶区别于靶场背景的色彩属性、纹理信息、轮廓形状等信息,采用阈值分割、边缘检测、几何法等传统图像处理方式或采用模式识别的方式进行胸环靶的检测、分割。裴伟晨[5]在胸环靶位置相对固定的前提下,通过手动选取有效区域坐标点,提取靶面有效区域。该类方法虽分割精确但需要人工参与,无法实现智能报靶。罗杰[6]提出基于颜色特征的胸环靶图分割算法,以绿色恒量特征为基础,通过色调和饱和度分量做进一步提取,以投影变换确定胸环靶位置。该方法忽略了实际靶场环境的复杂性,仅适用于靶场无绿色干扰物的情况,具有很强的局限性。尹乾[7]提出基于胸环靶图像灰度特点的有效靶面提取算法,该方法联合图像边缘和阈值分割结果,通过最大连通区域的提取获得有效靶面区域,该方法对靶场环境有着严格的约束,在雾天、光照变化明显等情况下,采集设备获取的靶场图像中极易存在和胸环靶灰度特点相同的干扰,且实际靶场环境下无法保证提取的最大连通区域即为有效靶面区域。胡乐[8]选取描述图像局部纹理特征的LBP算子进行分类器的训练,该算子的灰度不变性能够确保在不同光线条件下图像检测的一致性,通过离线训练好的分类器进行胸环靶的检测分割。该类方法只能获得胸环靶大致的位置,精确度低且在复杂的靶场背景环境下无法满足弹孔检测识别的需要,没有从根本改进系统对环境的适应性。

在特定的靶场环境下,传统图像处理方式能够实现胸环靶图的分割。由于靶场环境的复杂性,胸环靶的底层特征独立性低,无法支撑算法在各类环境条件下对靶图进行准确分割,普适性很低且基本局限于靶图有效区域的分割提取,一是在室外靶场环境下,靶图有效区域的特征极易与背景环境相似,二是在无法确保分割精度的前提下,极易引起系统的判靶误差。因此,本文从自动报靶系统的环境适应性、智能化和胸环靶图分割完整性的角度出发,结合前沿的视频图像处理技术,采用深度学习的方法对复杂环境下的靶场视频图像进行胸环靶图的分割研究,提出一种基于金字塔场景解析网络(PSPNet)的胸环靶图分割方法。实验证明,本文方法可从各种复杂靶场环境下将靶场视频图像中的胸环靶图进行像素级精确分割,有效解决自动报靶系统应用环境的局限性。

1 靶场环境

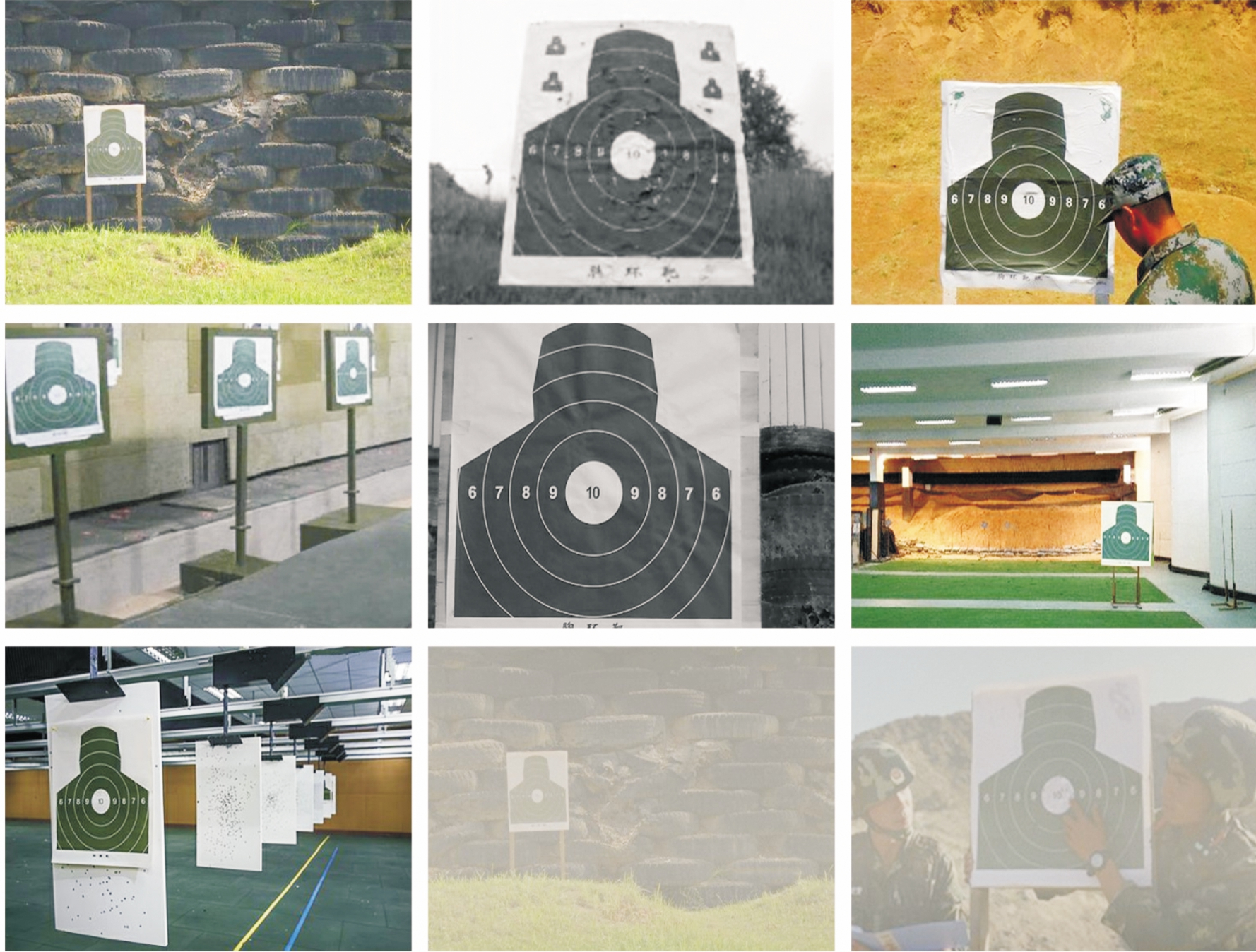

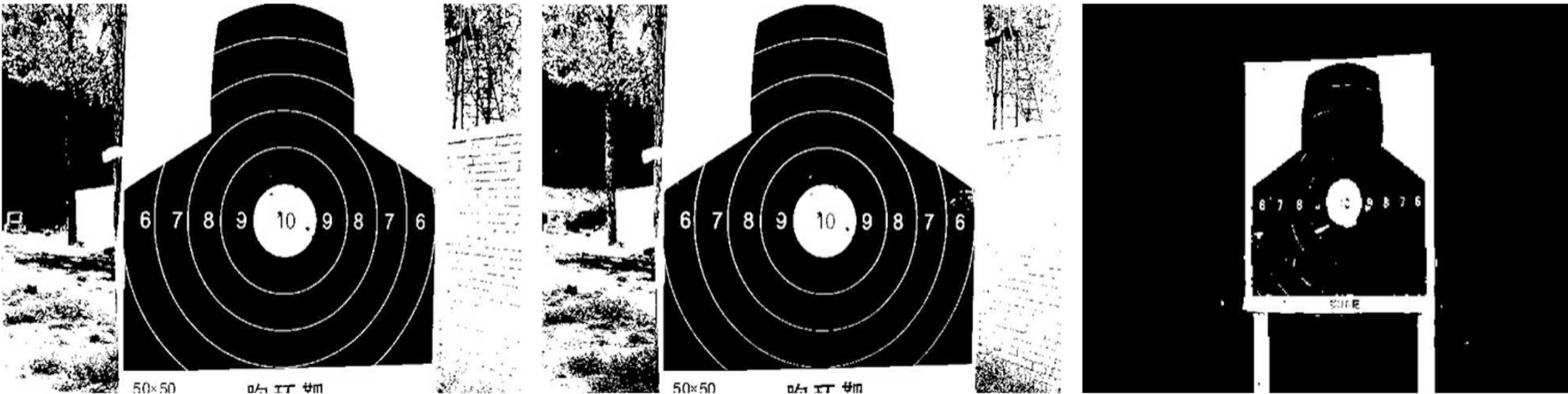

靶场可分为室内靶场、室外靶场和半封闭靶场且一般设置在人口相对少的郊区。室内靶场的环境,因靶场设计风格而呈现多样性。室外和半封闭靶场通常设置在有山体掩挡的自然环境区域并视情况设置靶挡等安全措施,其环境特点相对复杂,同时受靶场建设特点和自然环境的双重影响。因此,通过摄像机等硬件设备采集的不同靶场或同一靶场不同时刻、不同环境下的靶场视频图像,其背景呈现明显的差异性。由图1所示的靶场图像可以清晰的看出,不同的靶场建设特点存在差异性,不同环境条件下采集的视频图像也呈现截然不同的视觉效果。

图1 室内外靶场

2 基于PSPNet的胸环靶图分割方法

2.1 PSPNet网络

深度学习作为机器学习的分支,近年来得到了迅速的发展。基于深度卷积神经网络的图像语义分割方法主要利用神经网络完成对图像的像素级分类,从而获得图像场景的基本语义信息并完成目标的识别和分割任务。PSPNet[9]是一种基于像素级预测框架的fully convolutional network (FCN)[10]的场景解析网络,利用金字塔池化模块获取全局上下文像素级特征先验,通过局部和全局信息的结合在场景解析任务中生成高质量的结果,同时采用一种深度监督损失的优化策略,是像素级预测领域的优秀的框架。

金字塔池化模块是为了进一步减少不同子区域之间的上下文信息丢失而提出的包含不同尺度、不同子区域之间变化信息的分层的全局先验。金字塔池化模块融合了多种不同金字塔尺度下的特征,不同金字塔尺度下将生成不同子区域的特征图池化结果代表,同时增加降维操作以保持全局特征的权重。最后通过双线性插值将池化结果扩大至原始特征图相同的大小,并和原始特征图进行连接作为最终的金字塔池化全局特性。

深度监督损失的优化策略则是添加额外损失函数,通过辅助损失的监督产生初始结果,然后用最终损失来学习残差。这两个损耗函数通过前面所有层。辅助损失在不影响主要损失优化方向的前提下,有助于优化学习过程,通过增加权重对其进行平衡。

给定一张图片,首先通过convolutional neural network (CNN),采用具有扩张网络策略[11-12]的预训练ResNet[13]模型得到最后一个卷积层的特征图;然后通过金字塔池化模块获取不同子区域的特征表示并上采样至特征图像素尺寸之后和原始特征图连接形成具有局部和全局上下文信息的最终特征图;最后,将其输入卷积层即可获得最终的像素级分割结果。

2.2 数据集

数据集是深度神经网络训练的基础和前提,一定程度上决定了模型训练的成败。我国对枪械使用有着严格的审查和管理,普通民众极少进行打靶活动,且出于保密性要求,部队靶场的视频图像资源极少外传。因此,有关实际靶场的视频图像资源稀缺。本研究在真实靶场图像搜集、筛选的基础上,通过人工标注的手段对靶场视频图像进行像素级标注,构建胸环靶数据集。

本文的靶场视频图像主要有4处来源:① 实际靶场录制的打靶视频图像;② 网络中筛选的室内外靶场图像;③ 通过PS图像处理软件进行真实靶图、背景互换之后的靶场图像;④ 添加雾化、飞絮效果的靶场图像。创建胸环靶数据集共含图片285张,部分如图2所示。

图2 胸环靶图片

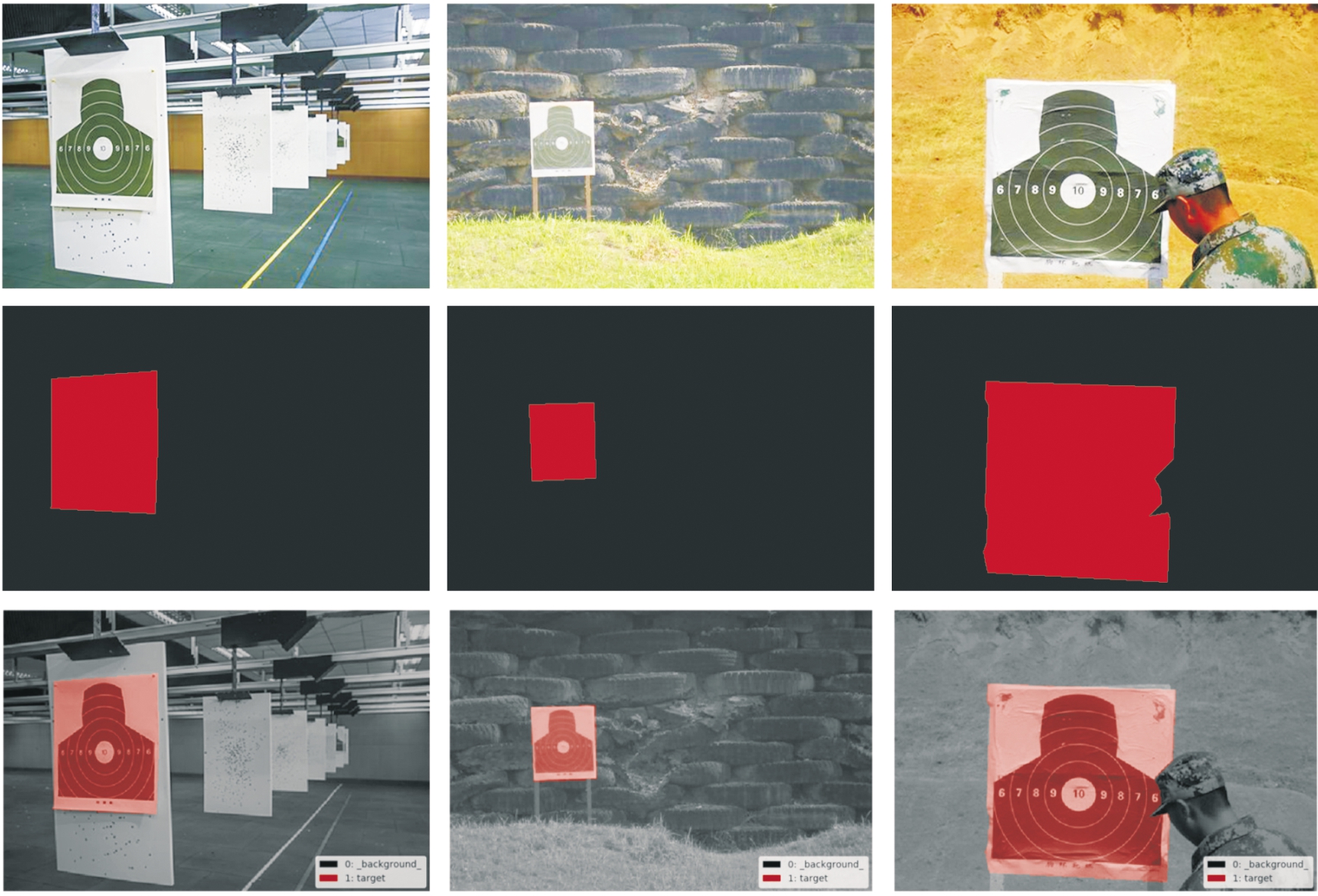

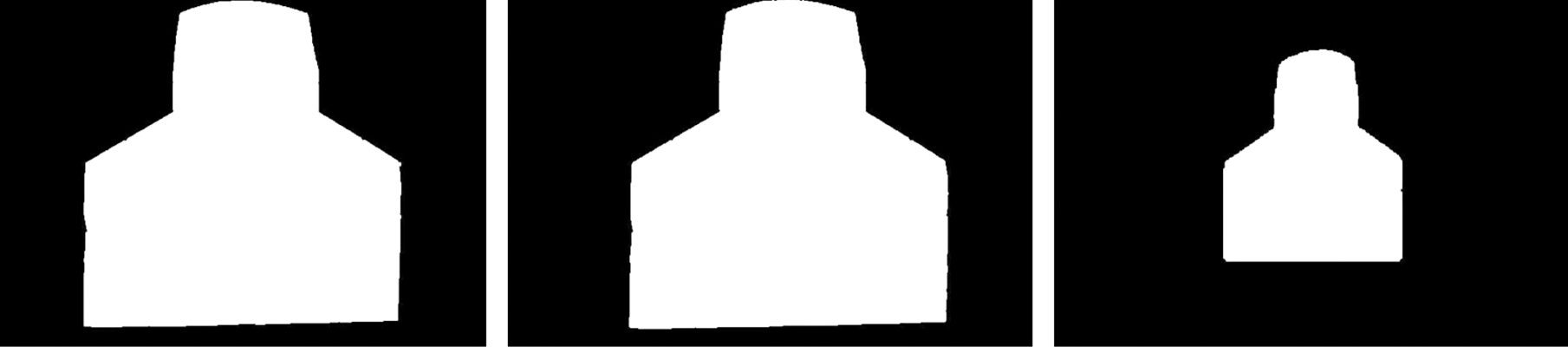

本研究主要解决复杂靶场环境下胸环靶的靶图分割,可视为二元分割问题,因此对靶场视频图像的靶图类目标进行标记。本文使用图像标注软件labelme进行靶图的标记,同时生成标记图和可视化图像。本文胸环靶数据集的实际标记图和可视化图像部分如图3所示。

图3 胸环靶图标记及可视化展示

2.3 评价标准

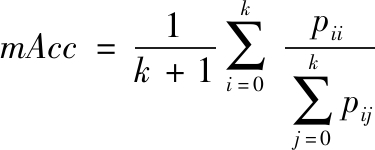

在图像分割任务中,算法精度的衡量标准很多,本文采用均像素精度和均交并比两种常用的逐像素标记的精度标准。设数据集中共标注由k+1个类(包含背景),pij表示属于类i的像素被预测为类j的像素数量。

均像素精度(Mean Pixel Accuracy):计算每个类别中的像素被正确分类的比例,然后求取所有类别比值的平均值。

(1)

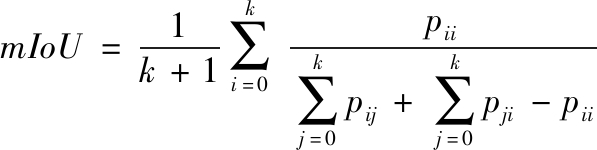

均交并比(Mean Intersection over Union)是图像语义分割任务中常用的度量标准,分别在每个类别中计算目标分割位置和实际位置交集与其并集的比值,然后取平均,其公式如下:

(2)

2.4 模型训练

为避免数据样本过少导致网络模型的泛化能力不足,陷入过拟合等问题,本文采用目标平移、旋转两种几何变换的预处理方式[14]对胸环靶数据集进行数据增强。网络模型采用图像增强操作处理后的胸环靶数据集进行训练,网络模型训练的过程实质是网络权重通过反向传播算法不断调整,使输出结果不断逼近真实值的过程。为进一步防止网络模型过拟合,本文采用随机的方式,按照4∶1的比例划分训练集和测试集,其中训练集的图像数量为188,测试集为47。

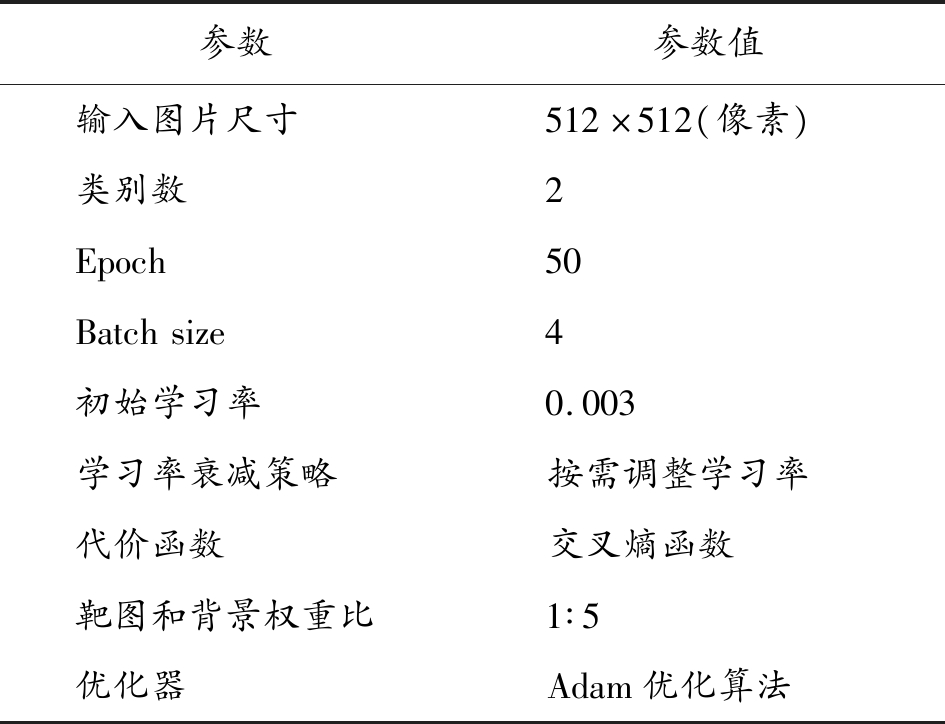

网络模型训练过程中的具体参数设置如表1所示。

表1 模型训练主要参数

参数参数值输入图片尺寸512×512(像素)类别数2Epoch50Batchsize4初始学习率0.003学习率衰减策略按需调整学习率代价函数交叉熵函数靶图和背景权重比1∶5优化器Adam优化算法

考虑到胸环靶数据集中的靶场图像来源复杂且不同设备采集的视频图像存在尺寸差异,本文在网络训练部分设置图像尺寸调整模块,将输入图像的像素尺寸调整为512× 512(像素)。本文旨在通过训练好的网络模型实现靶场图像中胸环靶图的像素级分割,因此本文的目标为胸环靶图,类别数为2,分别是靶图和靶场背景。1个epoch表示使用训练集中的全部样本完成一次训练,该参数值影响模型训练的时间,具体数值需要根据多次实验和经验来设置,以确保训练集的准确率和损失值达到收敛,本文的epoch值设为50,即训练集数据迭代50个世代。Batch size表示一次参数更新运算所需的样本数量,该值决定了每次输入图像的数量,数值大小受到网络结构和硬件GPU显存容量影响,本文的batch size值设为4。学习率在网络模型训练的过程中决定权值的更新幅度,其值过大则可能越过最优值,在误差最小值附近震荡,过小则权值训练时间长,无法快速收敛。本文采用的初始学习率为0.003,并使用PyTorch学习率调整策略中的有序调整策略,在迭代次数上升过程中设定指定的间隔,分别在第8轮、第31轮、第46轮进行学习率的衰减,新的学习率是上一次学习率的1/5。代价函数又称损失函数,本文采用交叉熵函数,其式如下:

loss(x,class)=weight[class](-x[class]+

log(∑jexp(x[j])))

(3)

其中,本文对每个类的loss进行人工权重重标,靶图和背景的权重比为1∶5。

优化方法采用对超参数选取相当鲁棒的Adam[15]优化算法,通过计算梯度的一阶矩估计和二阶矩估计为不同的参数设计独立的自适应性学习率。在 Adam 算法中,动量直接并入了梯度一阶矩(指数加权)的估计。其次,Adam 包括偏置修正,修正从原点初始化的一阶矩(动量项)和(非中心的)二阶矩的估计。

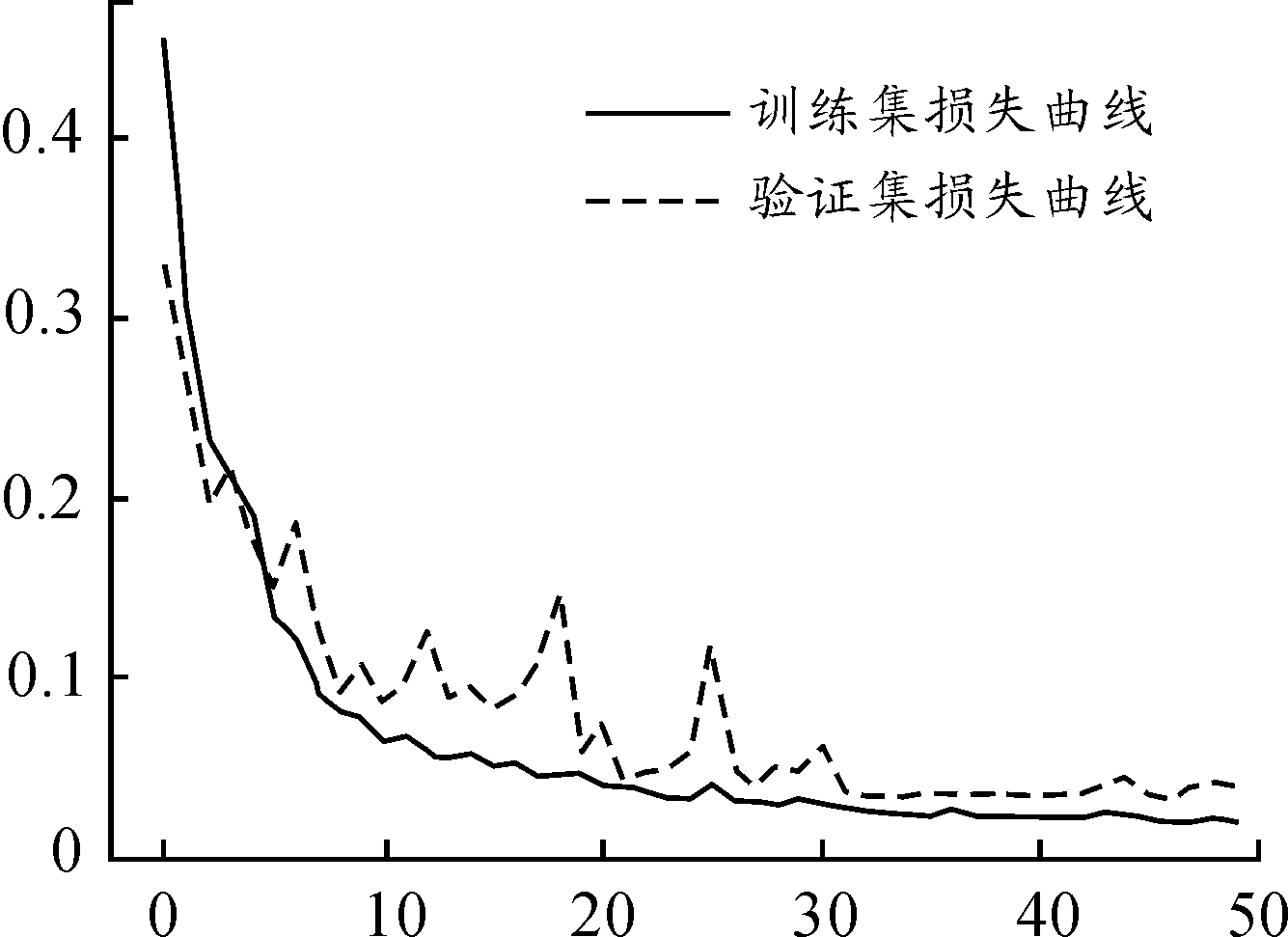

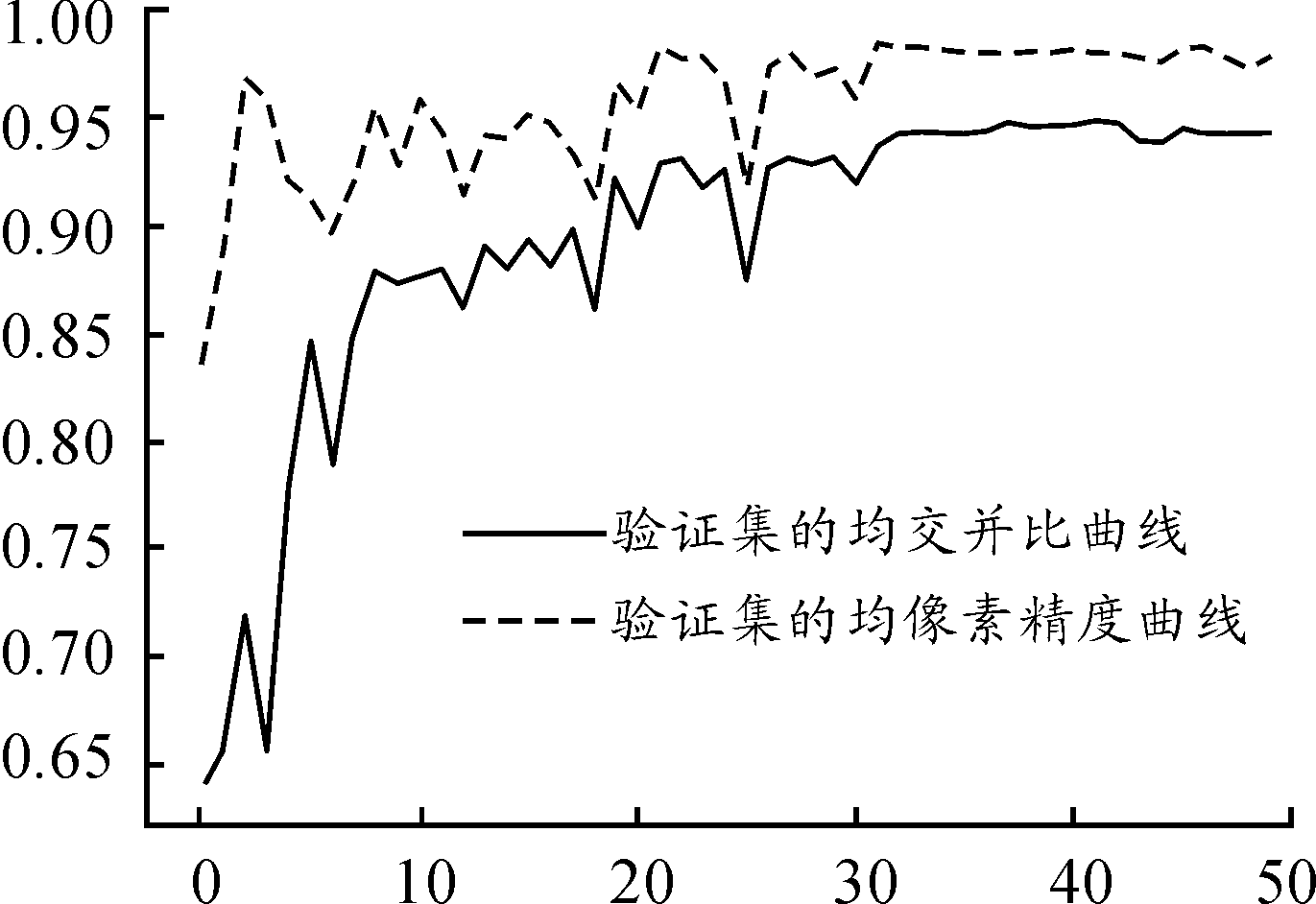

本文按照上述参数设置进行PSPNet网络参数的学习,所有实验基于深度学习框架PyTorch。每一轮训练后计算训练集和验证集的损失值并使用验证集对模型的性能进行测试并记录。网络模型在训练过程中的损失和正确率变化趋势曲线如图4、图5所示,详细记录了模型在训练过程中每轮在训练集和验证集上的损失值以及模型在验证集上分割的正确率,可以清晰的看出,随着迭代次数的不断递增,该网络模型在训练集和验证集上的损失不断减小,在验证集上的正确率不断增加,变化的趋势由快到慢。最后,将训练好的胸环靶图分割模型保存到本地。

图4 损失曲线

图5 分割精度曲线

3 验证与分析

图6所示分别为不同靶场背景环境下的胸环靶图,其中第二张图像为第一张图像的雾化结果,分别将胸环靶图标记为靶像1、靶像2、靶像3。本文在此基础上展开传统分割方法和基于深度学习分割方法的实验验证与分析,且实验结果与图6一一对应。

图6 胸环靶图

3.1 传统胸环靶图分割方法

传统图像分割方式多通过单色图像的转换,并依赖于图像亮度值的两个基本特性(不连续性和相似性)对目标图像进行感兴趣区域的有效分割。本文从边缘检测和像素灰度值的相似性两个方面对胸环靶图进行分割实验。

1) 基于边缘的胸环靶图分割

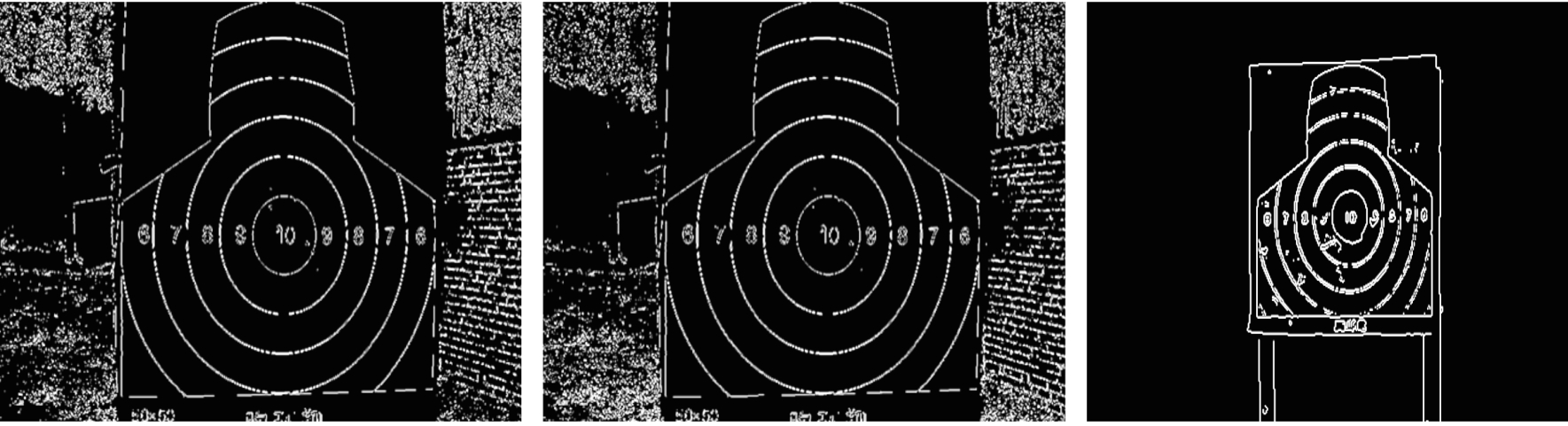

利用胸环靶区域白色靶面部分在靶场视频图像中引起的灰度值不连续的特征通过查找胸环靶的边界进行靶图的分割,本文利用sobel边缘提取算法对图6所示的靶场图像进行基于边缘的胸环靶图分割,边缘检测效果如图7所示。

图7 边缘检测结果

由靶像1和靶像2的检测结果可知边缘特征的鲁棒性较好,分割效果可以不受雾天等稳态不良天气的影响,相较于靶像3完整分割出胸环靶的效果,由于靶像1、靶像2的靶场背景没有虚化的成像特点,胸环靶的边缘特征没有明显区别于背景物体的边缘干扰,无法实现胸环靶的准确分割。因此可以得出,在成像设备采集的靶场视频图像中,仅当靶场背景边缘特征微弱的情况下,基于边缘特性可以很好的进行胸环靶图的分割。

2) 基于阈值的胸环靶图分割

胸环靶存在明显灰度值明显高于靶场背景的白色靶面,本文基于像素属性的分布,采用全局阈值分割的方式,通过Otsu方法[16]确定分割阈值,进行胸环靶图的分割,其结果如图8所示。

图8 阈值分割结果

由于阳光在背景物体的反射,导致靶场图像背景中存在高灰度值区域,由靶像1的阈值分割结果可知,胸环靶被识别出来的同时大量的背景区域也被同时分割出来,且无法将两者进行有效的分割。雾化处理的图像在一定程度上增加了靶场图像背景的灰度值,增加了胸环靶和背景的分割难度,阈值分割效果如图8所示。由靶像3的分割结果可知,当靶场背景环境中没有高亮度物体时,阈值分割法可以快速有效的进行胸环靶的检测分割。

3) 基于区域的胸环靶图分割

靶场图像中,各个目标内部之间必然存在一定的相似性,本文采用灰度值的相似性,通过直接寻找区域的方式即区域生长算法对靶场图像中的胸环靶图进行分割。选取白色靶面上的像素点为生长种子点,以邻域像素点灰度值和种子点灰度值的距离差值为区域生长的判别条件,其中,在区域生长过程中不断更新差值最小的像素点为种子点并将已分割区域的灰度均值作为种子点的灰度值。

由图9中靶像1和 靶像3的区域生长结果可知,区域生长算法在无不良天气干扰的情况下,取得了较好的分割效果。在雾天环境下,靶场图像部分背景区域的灰度值增高,导致胸环靶白色靶面区域区别于靶场背景的灰度值特性减弱,区域生长的相似性准则部分失效,无法实现胸环靶的准确分割,如图9中靶像2结果所示。

图9 区域生长结果

4) 基于胸环靶图像灰度特点的有效靶面提取算法

基于胸环靶图像灰度特点的有效靶面提取算法由尹乾[7]提出,该算法结合图像边缘提取、阈值分割、连通区域获取和形态学处理四种图像处理手法,并最终通过靶面区域映射获得有效靶面。以图6中的胸环靶图为例,通过该算法获得的实验结果如图10所示。

图10 有效靶面实验结果

由图10的实验结果可以看出,该算法经过参数调整之后基本可以实现大部分靶面有效区域的提取,但同时具有严重的缺陷。一是该算法旨在实现靶面有效区域的提取而不是胸环靶图的提取,环线去除等运用形态学处理手法的部分不可避免使靶面有效区域的轮廓或面积产生变化,造成误差,同时为保证环线去除的同时不破坏靶面有效区域整体连通的完整性,使得参数的设置苛刻,需要根据实际情况及环境特点进行人工调整,如图11所示,实际胸环靶图上端的白色靶纸区域很窄,受室外环境如雾等干扰因素的影响,该白色靶纸区域将会变得更窄,此时如保持参数不变将会导致靶面有效区域和背景区域相连通,无法准确提取靶面的有效区域;二是,该算法要求靶面有效区域和背景区域有明显的大小差异,以通过连通区域的大小关系,实现众多连通区域中,靶面有效区域的准确提取,不同靶场环境下,无法保证靶面有效区域和背景连通区域大小关系的一致性,例如,本实验中靶像1、靶像2选取最大连通区域为靶面有效区域,靶像3则选取第二大连通区域为靶面有效区域。综上,该算法不具有普适性,更无法实现复杂环境下胸环靶图的有效分割。

图11 结果对比

3.2 基于深度学习的胸环靶图分割方法

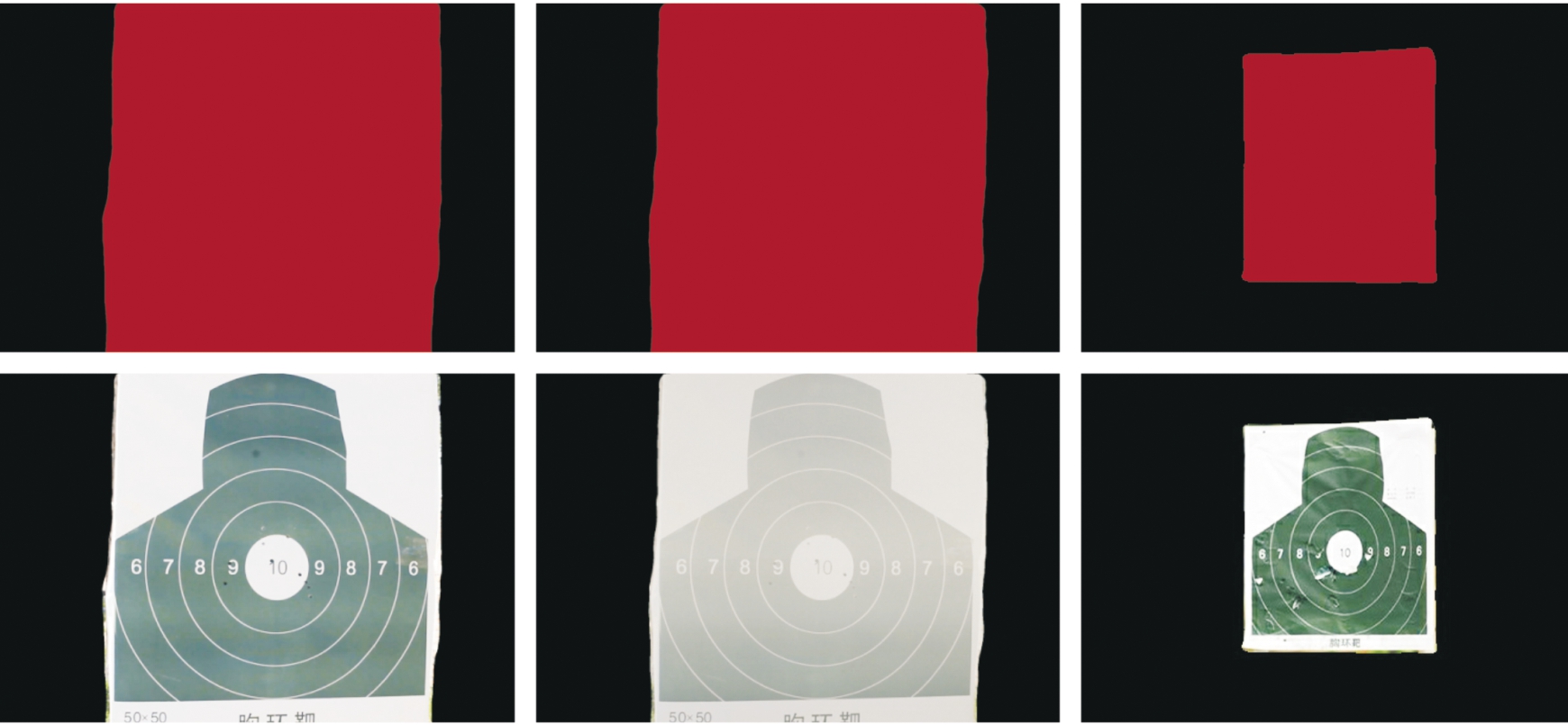

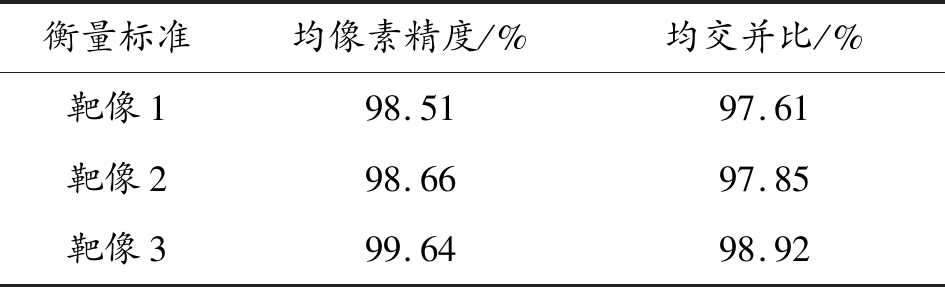

该部分实验基于本文提出的基于深度学习的胸环靶图分割方法,将靶场视频图像输入到训练好的基于PSPNet的胸环靶图分割模型进行靶图的分割,生成像素级分类标签图并据此生成分割图像,如图12所示,3种情况下的胸环靶图全部被有效的识别分割出来。均像素精度和均交并比如表2所示。经本文50张验证集,本文训练的胸环靶图分割模型在胸环靶分割任务中平均像素精度可以达到98.76%,平均交并比可以达到97.84%,实现了非常好的分割效果。

图12 深度学习分割结果

表2 胸环靶分割精度衡量

衡量标准均像素精度/%均交并比/%靶像198.5197.61靶像298.6697.85靶像399.6498.92

4 结论

本文利用近年来快速发展的深度学习的方法,提出基于PSPNet的胸环靶图分割方法,通过创建胸环靶图数据集、网络参数修改调试完成胸环靶图分割模型的训练,并基于该模型实现对靶场视频图像的像素级精确分割,在本文测试集中,平均像素精度达到98.76%,平均交并比达到97.84%,较传统图像分割方法提高了分割精度,并提高了自动报靶系统的环境适应性。

[1] 罗杰,张之明.基于图像处理技术自动报靶系统综述[J].激光杂志,2016,37(07):1-6.

[2] 余梓.基于图像处理技术的弹孔定位系统研究[D].哈尔滨:哈尔滨理工大学,2016.

[3] 刘瑞香,刘天时,王洪伟.面向纸质胸环靶的自动识别报靶系统研究[J].电脑知识与技术,2015,11(12):191-193,198.

[5] 白亚文.基于图像处理和CAN总线的智能报靶系统设计和实现[D].北京:北京邮电大学,2015.

[6] 裴伟晨.基于图像处理技术的自动报靶系统研究[D].济南:山东大学,2016.

[7] 罗杰,张之明.基于颜色特征的胸环靶图分割算法[J].科学技术与工程,2016,16(23):239-243.

[8] 尹乾,廖强.基于胸环靶图像灰度特点的有效靶面提取算法[J].科学技术与工程,2017,17(22):260-264.

[9] 胡乐.基于视频分析的多模式自动报靶系统设计[D].杭州:浙江大学,2016.

[10] ZHAO H,SHI J,QI X,et al.Pyramid scene parsing network[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.[S.l.]:[s.n.],2017:2881-2890.

[11] LONG J,SHELHAMER E,DARRELL T.Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.[S.l.]:[s.n.],2015:3431-3440.

[12] CHEN L C,PAPANDREOU G,KOKKINOS I,et al.Semantic image segmentation with deep convolutional nets and fully connected crfs[J].arXiv preprint arXiv:1412.7062,2014.

[13] XIA F,WANG P,CHEN L C,et al.Zoom better to see clearer:Human and object parsing with hierarchical auto-zoom net[C]//European Conference on Computer Vision.Springer,Cham,2016:648-663.

[14] HE K,ZHANG X,REN S,et al.Deep residual learning for image recognition[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.[S.l.]:[s.n.],2016:770-778.

[15] 张华博.基于深度学习的图像分割研究与应用[D].成都:电子科技大学,2018.

[16] KINGMA D P,BA J.Adam:A method for stochastic optimization[J].arXiv preprint arXiv,1412.6980,2014.

[17] XU X,XU S,JIN L,et al.Characteristic analysis of Otsu threshold and its applications[J].Pattern recognition letters,2011,32(7):956-961.