偏振成像技术是一种基于目标偏振特性的光学侦察手段,通过多个偏振方向的偏振分析器,探测目标的反射、辐射光的偏振态,进而利用偏振态之间的相互关系生成目标的图像。该技术可提高目标与背景的对比度,为检测与跟踪伪装目标提供了可能性,对战场监视与侦察具有深远的意义。偏振光成像探测技术在以下几个方面有着独特的优势:① 目标细节特性的增强;② 低对比度目标特性的增强;③散射介质投射能力的增强。

近年来,随着人工智能技术的发展,基于偏振图像数据的智能目标检测识别已成为可能。例如,安徽大学的王溪水利用深度卷积神经网络提升了偏振图像的分类效果,证明了深度学习对提取偏振图像特征的方向有较好的效果[1]。西北工业大学的赵永强团队将偏振光成像与深度学习结合,实现了运动目标的智能感知与偏振图像的高质量恢复[2]。目前深度学习领域的目标检测算法根据检测方法可分为两大类:第一类为基于区域候选框的算法,如Mask R-CNN[3]、Faster R-CNN[4]等,该类算法具有较高的检测精度,但检测速度较慢;另一类为基于回归的目标检测算法,如YOLO[5]系列算法、SSD[6]等,它们的特点是采用端到端的检测,具有较快的检测速度,可满足实时检测的速度要求。

1 YOLOv3目标检测框架

YOLO(You Only Look Once)算法[5]是Redmon和Divvala提出的一种目标检测算法。此算法最大的优势在于极高的检测速度,可实时完成目标检测任务。在GPU加速的条件下,检测速度可达40 fps,满足人眼的视觉需求。

YOLOv3是YOLO系列目标检测算法中较为优秀的一个。Faster R-CNN算法的提出早于YOLO,其精度很高,但检测速度过慢,难以满足实际需求。

如图1所示,偏振成像设备的采集的视频按照帧分为图像序列,作为YOLOv3模型的输入。首先按YOLOv3网络对分辨率的要求,将图像缩放为416×416像素大小;然后将缩放后的图像输入到由53个卷积层构成的基础深度神经网络Darknet-53[7],该网络主要用于提取图像的深层特征和抽象特征。

图1 YOLOv3结构框框图

在Darknet-53之后是特征交互层,共有3个不同尺度的特征图,大小分别为19×19、38×38和76×76,用以实现对3个不同尺度的目标的检测。在每一个尺度的特征层内,通过卷积核的特征交互实现局部的特征交互。因此,YOLO系列算法创新之处在于把检测问题转化成了回归问题[7]。

2 偏振图像数据集构建与预处理

2.1 偏振信息解析与特征选择

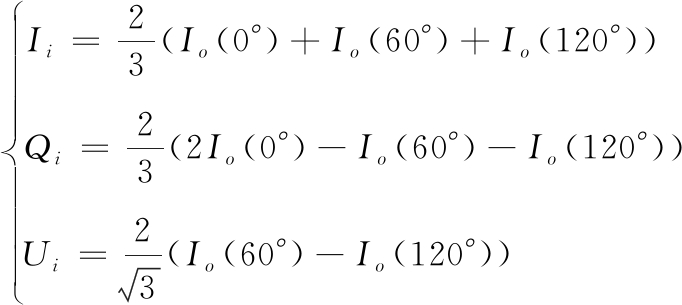

在计算机视觉领域中,一般最为关注的是图像的强度、形状以及颜色信息[8]。偏振特性是指光被物质透射或反射时光的偏振态发生的改变,早在1852年G.G.Stokes提出了利用Stokes参量(I、Q、U)表示物体的偏振特性。通过对光强的平均值计算得到Stokes参数,再通过进一步的分析计算,得到偏振度参数与偏振角参数。由0°、60°、120° 3个偏振方向的偏振成像图通过斯托克斯参数求解公式,即可得到各个像素点对应的偏振信息,各偏振参量又可以以数字图像的形式进行数据可视化。得到各个偏振参量对应的目标偏振信息数据集。Io(0°)、Io(60°)、Io(120°)为3个偏振探测器采集到图像的强度值。

(1)

(2)

(3)

其中,Stokes参量I、Q、U可由式(1)计算得到。进一步地,可以通过式(2)、式(3)解析偏振度DOLP与偏振角AOP。

本文将该反映偏振特征的偏振度成像图作为检测源。图2为偏振成像及偏振信息解析示意图。

图2 偏振参量解析示意图

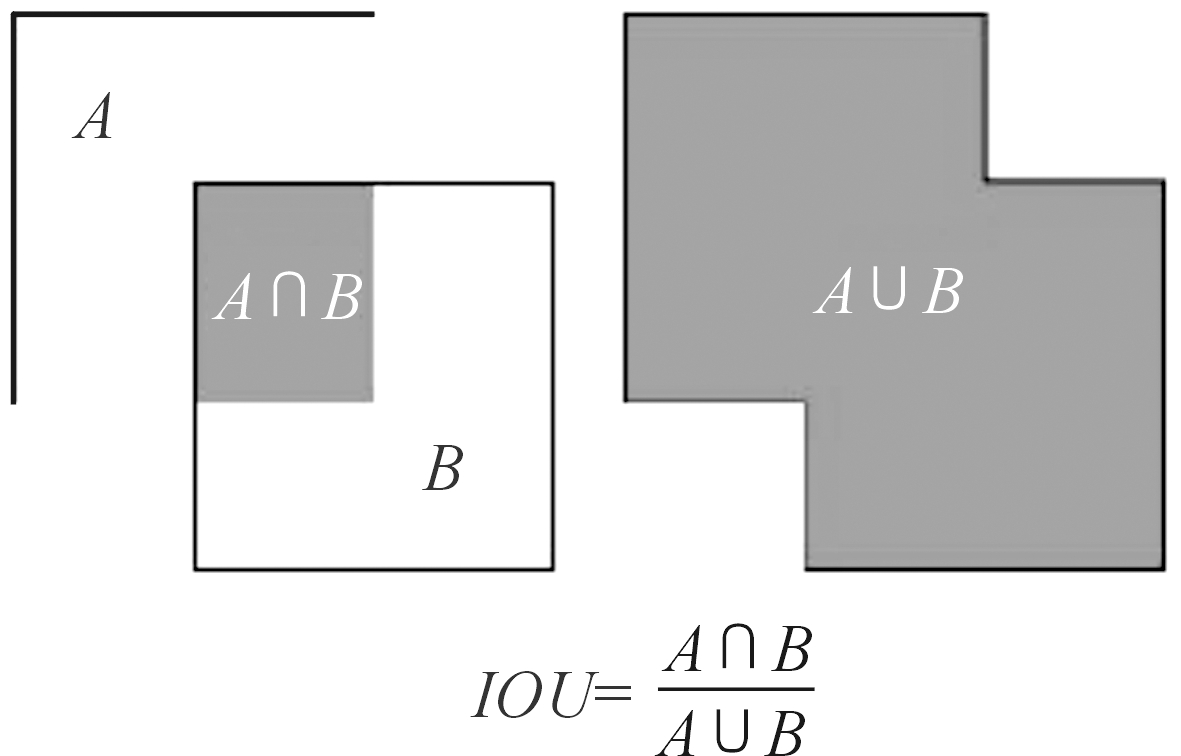

2.2 数据采集与扩容

本文所使用的偏振图像均在偏振光成像探测技术安徽省重点实验室采集。由于军事目标数据非常敏感,本文所涉及的实验均采用缩比模型作为实验合作目标,从数据采集到目标检测实验,目标均为缩小比例为1∶118的某型外军坦克车辆金属模型。

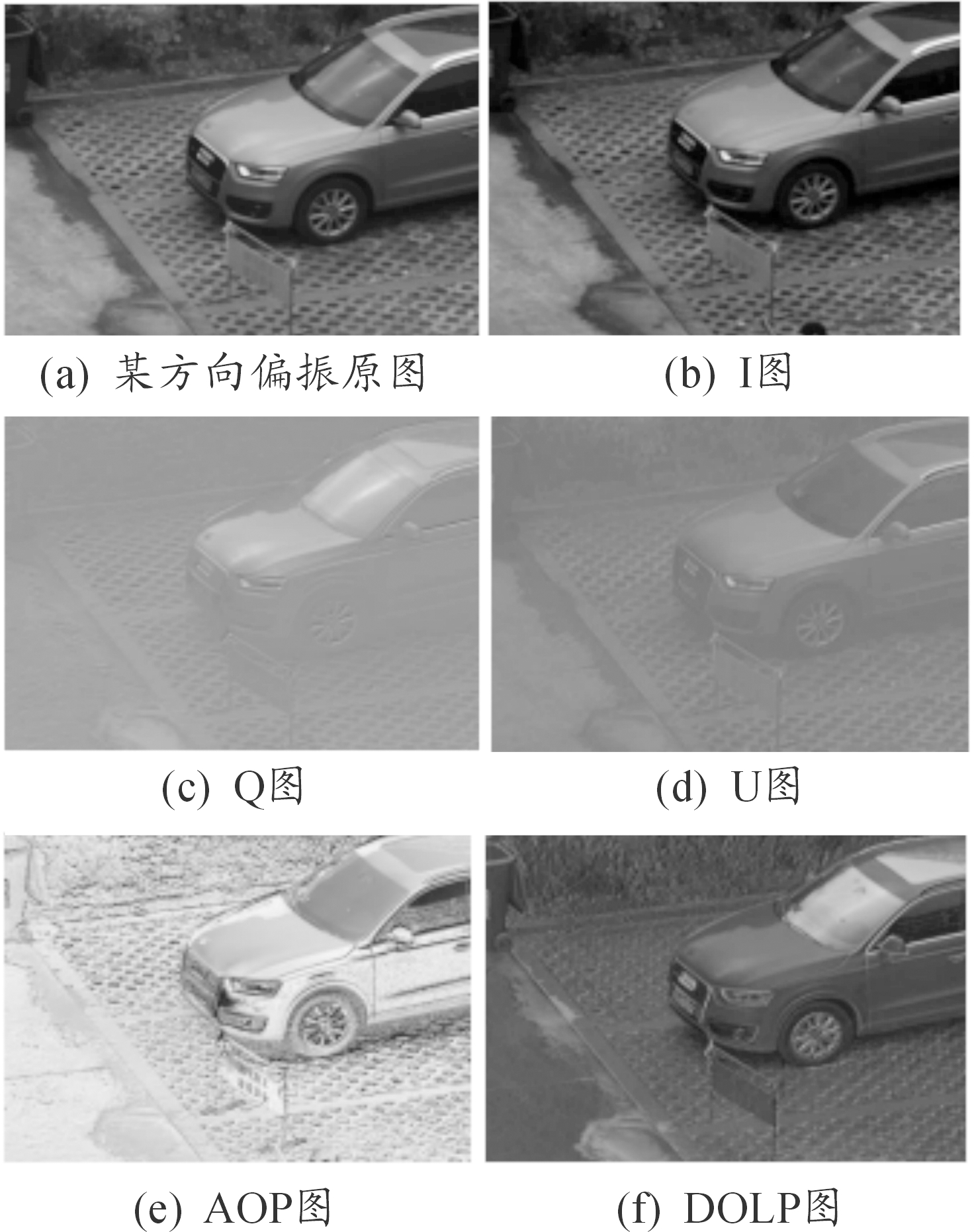

目前偏振光成像设备采集到的图像数据集仍偏少。为了解决这一问题,如图3所示,本文通过图像仿射变换、平移、翻转等图像处理方法,扩充偏振数据集。

图3 数据扩容示意图

2.3 YOLOv3模型改进

YOLOv3网络主要面向可见光图像。即RGB格式的真彩色图像,可视为大小为3×416×416的矩阵。由于偏振度成像图是灰度图,本文将输入端口设置为输入单通道图像的1×416×416,这样减少了资源冗余。

YOLOv3网络使用的初始anchor参数是在COCO和Pascal VOC两个可见光图像目标数据集聚类得到的。而本文针对的是军事目标的偏振图像,所面向的目标与日常生活中的各类目标差距较大。

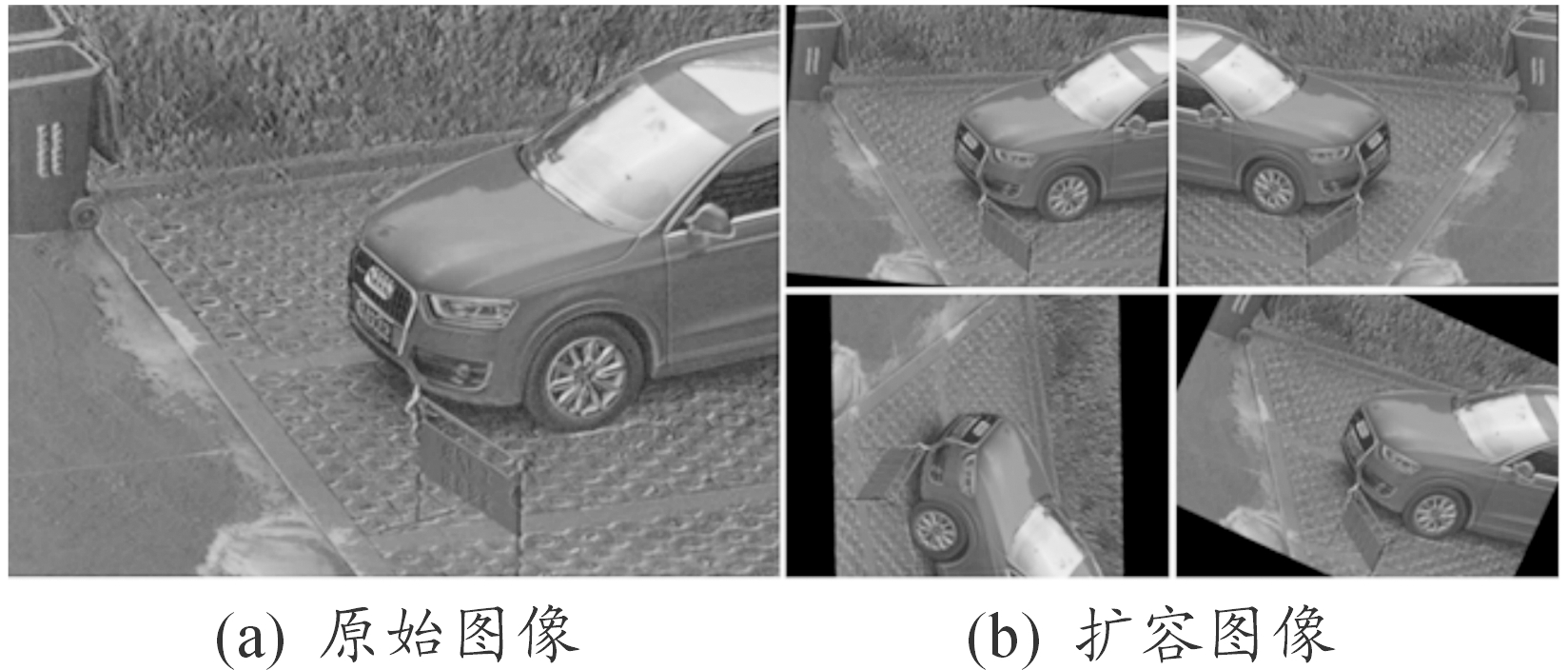

使用K-means算法对2.2中所构建的偏振图像数据集目标框位置信息进行了聚类分析。K-means算法中通过以图4所示的IOU概念代替传统聚类算法中的欧氏距离作为聚类标准。利用Python语言编写聚类脚本读取训练集中txt文件所保存的目标信息,进行K-means聚类。设置K=9即anchor参数的聚类中心的数量为9个。聚类结果如图5所示,新的锚参数分别为(63,363),(73,295),(100,157),(157,258),(179,64),(198,312),(210,154),(315,169),(320,318)。

图4 IOU概念示意图

图5 K-means聚类结果示意图

3 模型训练与测试

3.1 模型训练

本实验的软硬件平台配置如表1所示,训练集和测试集分别包含3 000和800张合作目标的偏振度成像图片。各个批次训练包含128张图片,每一个批次分成32次送入训练器。

表1 网络训练环境

名称配置CPU因特尔 至强十六核GPU英伟达GTX1080Ti操作系统微软Windows 10并行计算库Cuda10+Cudnn7.4图像处理Python3.5、OpenCV3.4.1深度学习框架Darknet-53

3.2 实验测试及结果分析

测试集中所包含的图片是使用缩比模型作为合作目标和仿真典型气候环境场景采集得到的。地形包括雨林、戈壁、荒漠、草地、丘陵等,不良成像条件设置主要是雾霾条件下的不良成像环境。检测结果如图6所示。图6(a)是偏振原始图,图6(b)是偏振信息DOLP成像图,图6(c)是目标检测结果,矩形框为检测结果。通过对各类典型场景下的检测结果可分析本文提出的检测方法的效果。对比模型改进前后的性能可以分析模型改进的有效性。

图6 检测结果示意图

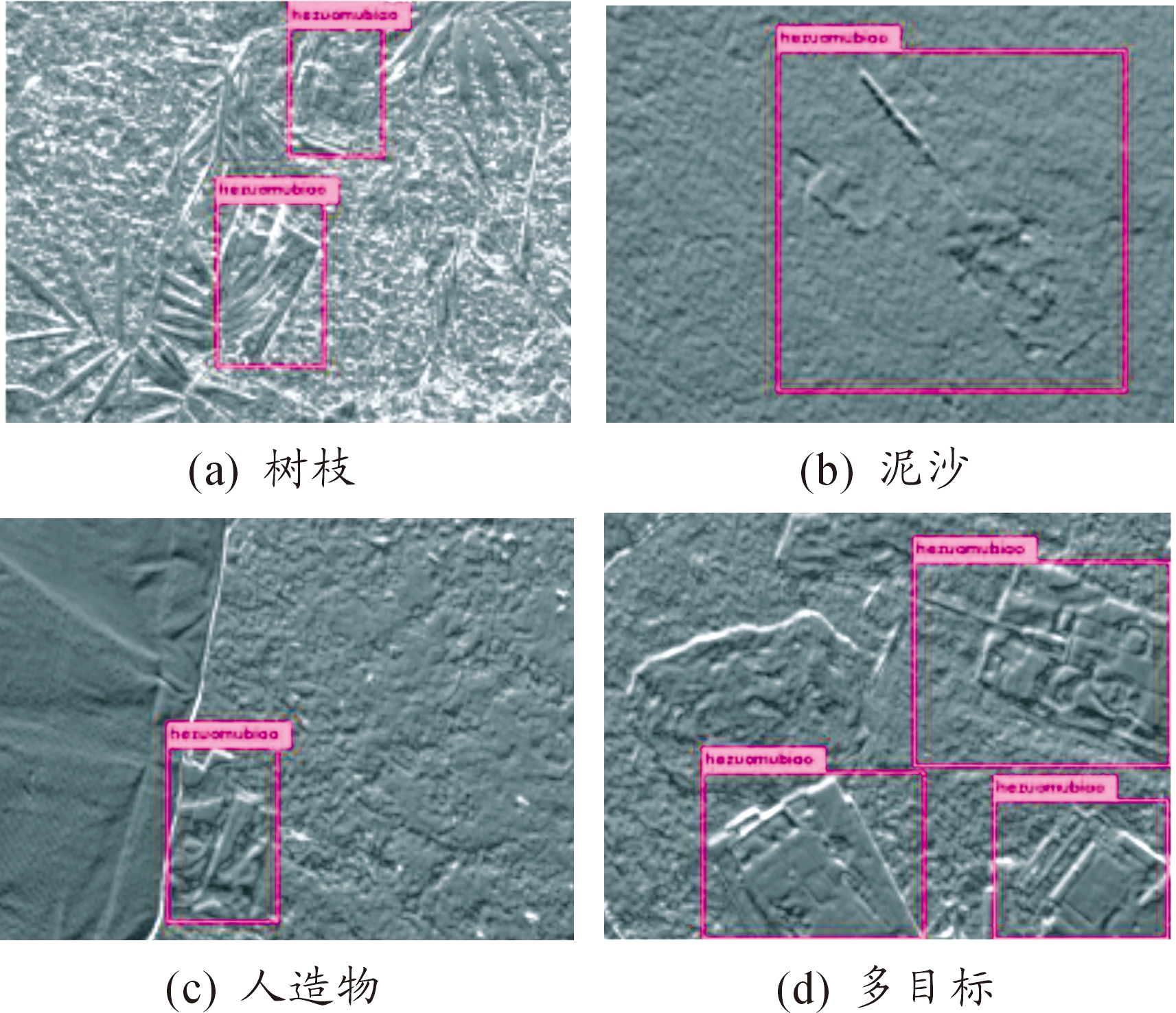

如图7(a)所示为典型林地场景车辆目标,目标被树枝部分遮挡;图7(b)为典型沙漠背景的车辆目标,目标陷入沙子,顶部部分覆盖沙土;图7(c)为典型的人造物遮盖场景;图7(d)为典型的多目标检测场景,除了三台合作目标车辆,还设置了一个大小相仿的假目标。

图7 部分遮挡的检测结果示意图

检测结果表明,本文所提出的基于改进YOLOv3的偏振成像检测模型可以对不同环境、不同成像条件下的目标以及遮挡不全的目标进行有效识别,并且可以在一个视场中同时检测出多个目标,同时对假目标也有一定的辨别能力。

图8中,图8(a)是在低浓度雾霾影响下采集的偏振原图,图8(b)是通过偏振信息解析成像获取的偏振度图。相比于图8(a),图8(b)已经清晰地看到坦克车辆的轮廓;图8(c)是对图像预判得出的结果,非常精确。

图8 不良成像条件检测结果示意图

根据检测结果可知,基于改进YOLOv3的偏振成像检测模型不仅可以实现智能化的目标检测,而且借助于偏振成像,对散射介质(雾、霾、沙尘等)的不良影响也有一定的抑制能力[9],使得模型在雾霾天气等一些不良成像条件下也可以做出正确、精确的判断,因此模型的检测能力具有鲁棒性。

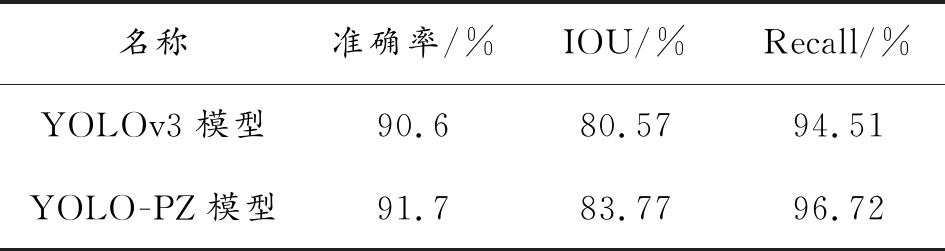

本文进一步通过计算交并比(IOU)、召回率(recall)和检测准确率对比模型在使用改进anchor参数前后的测试性能,参数结果如表2所示。IOU如2.3节图4所示是模型预测的目标框和人工标定目标框的交集和并集之间的比例。

表2 模型性能参数

名称准确率/%IOU/%Recall/%YOLOv3模型 90.6 80.5794.51YOLO-PZ模型 91.783.7796.72

经过改进的YOLO-PZ模型在测试集上测试,结果在表2中显示,检测准确率相比原YOLOv3模型提高了1.13%,IOU提高了3.20%,召回率提高了2.21%。在本实验中所有偏振度图像平均处理时间均小于40 ms,即在检测时帧率一直保持25 fps以上的检测速率,因此所提出的改进网络模型实现了实时检测。

4 结论

提出了一种用于分析、判读偏振成像图像的目标检测模型。通过将深度学习和偏振光成像结合,提出了一种基于改进YOLOv3的偏振光成像目标检测方法。两者结合得到的预测模型可以快速、精确检测目标,且对雾霾等不良成像条件有一定的抑制作用。本文验证了深度学习灵活方便的建模与偏振成像优势结合的可行性,为尽快将该方法集成为军事应用软件,结合偏振光成像探测设备进一步构建光学侦察体系提供参考借鉴。

[1] 王溪.偏振图像配准与分类算法研究[D].合肥:安徽大学,2010.

[2] 赵永强,李宁,张鹏,等.红外偏振感知与智能处理[J].红外与激光工程,2018,47(11):9-15.

[3] HE K,GKIOXARI G,DOLLAR P,et al.Mask R-CNN.[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2017(99):1-1.

[4] REN S,HE K,GIRSHICK R,et al.Faster R-CNN:Towards Real-Time Object Detection with Region Proposal Networks[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2017,39(6):1137-1149.

[5] REDMON J,DIVVALA S,GIRSHICK R,et al.You only look once:Unified,real-time object detection[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition.[S.l.]:[s.n.],2016:779-788.

[6] LIU W,ANGUELOV D,ERHAN D,et al.SSD:Single Shot MultiBox Detector[C]//European Conference on Computer Vision.[S.l.]:[s.n.],2016:21-37.

[7] REDMON J,FARHADI A.YOLOv3:An Incremental Improvement[J].arXiv preprint arXiv:1804.02767,2018.

[8] 赵永强,潘泉,程咏梅.成像偏振光谱遥感及应用[M].北京:国防工业出版社,2011.

[9] 梁健,巨海娟,张文飞,等.偏振光学成像去雾技术综述[J].光学学报,2017(04):9-21.

[10] 郑胤,陈权崎,章毓晋.深度学习及其在目标和行为识别中的新进展[J].中国图象图形学报,2014,19(2):175-184.

[11] BENJDIRA B,KHURSHEED T,KOUBAA A,et al.Car Detection using Unmanned Aerial Vehicles:Comparison between Faster R-CNN and YOLOv3[Z].2018.

[12] 刘喆,郭俊.基于偏振光成像的材质分类研究[J].光学学报,2016(10):65-70.

[13] 朱超平,杨艺.基于YOLO2和ResNet算法的监控视频中的人脸检测与识别[J].重庆理工大学学报(自然科学),2018,32(8):176-181.

[14] 陈冰曲,邓涛.基于改进型SSD算法的目标车辆检测研究[J].重庆理工大学学报(自然科学),2019,33(01):64-69,135.

[15] REDMON J,FARHADI A.[IEEE 2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR)-Honolulu,HI(2017.7.21—2017.7.26)] 2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR)-YOLO9000:Better,Faster,Stronger[J].2017:6517-6525.

[16] 蔡成涛,吴科君,严勇杰.基于优化YOLO方法机场跑道目标检测[J].指挥信息系统与技术,2018,51(03):41-45.

[17] 王志,陈平,潘晋孝.基于深度学习的复杂背景下目标检测[J].重庆理工大学学报:自然科学,2018,32(4):171-176.

[18] 熊咏平,丁胜,邓春华,等.基于深度学习的复杂气象条件下海上船只检测[J].计算机应用,2018,38(12):283-289.