1 引言

目标跟踪是计算机视觉中的一项重要课题和研究热点,在视频监控、精确制导等领域有着广泛应用。目标跟踪通过给定的初始信息,在后续的图像序列中对目标的位置或形状进行估计,进而实现对运动目标的速度、方向和轨迹等运动信息的分析和理解[1]。目标跟踪的困难和挑战主要有以下几个方面:①目标情况复杂多变,如形状和尺度发生变化;②光照、遮挡或背景噪声干扰,造成目标特征信息发生变化;③目标快速运动导致图像模糊,无法准确定位目标。

目前,基于相关滤波和基于深度学习的方法是目标跟踪领域研究的主要方向。其中,基于深度学习的方法[2-5]虽然跟踪精度很高,但由于深度神经网络的特征计算和模型更新相对复杂,导致计算代价大,影响了算法速度。相关滤波方法凭借其精度高、速度快的特点得到广泛关注,一系列基于相关滤波的改进方法也被相继提出,算法精度得到大幅度提升。Bolme等[6]在目标跟踪中首次引入相关滤波理论,提出的MOSSE(miniInum output sum of squared error)算法通过输出结果最小均方误差的方式训练得到最优滤波器模板,与新一帧图像的目标区域进行相关运算,得到最大响应的位置即为新一帧图像的目标位置。由于采用快速傅里叶变换方法,将空域的卷积转化为频域的点乘,因此算法运算量得到了极大减少,速度超过了600帧/s。随后,在MOSSE框架的基础上,Henriques等[7,8]提出CSK(circulant structure of tracking-by-detection with kernels)算法和KCF(kernelized correlation filters)算法,引入循环矩阵和岭回归策略,跟踪性能得到进一步提升。针对目标跟踪中复杂背景问题,Danelljan等[9]提出自适应颜色属性(color names,CN)策略,利用11个通道数的CN空间对CSK算法进行了颜色扩展,提高了跟踪效果。为应对遮挡问题,李健宁等[10]基于CN框架下,融合灰度特征和梯度直方图(histogram of oriented gradient,HOG)特征,同时引入尺度池,一定程度上提高了遮挡情况下的跟踪精度。SAMF(scale adaptive with multiple features)算法[11]和DSST(discriminative scale space tracking)算法[12]在KCF的基础上进行了改进,前者对目标进行7个尺度的采样,将平移滤波器在多尺度图像块上进行相关运算,选取响应值最大的位置和对应尺度;后者使用33个尺度,训练了平移检测和尺度检测2个滤波器,先利用平移滤波器进行位置检测,然后在响应值最大位置处使用尺度滤波器进行尺度检测。针对目标形变问题,Bertinetto等[13]提出Staple(sum of template and pixel-wise learners)方法,将HOG特征和颜色直方图特征进行有效结合,分别对2种特征进行训练得到2个滤波器模板,对目标区域得到的2个响应图进行线性融合,提高了跟踪的精度,同时速度超过80帧/s。戴伟聪等[14]在Staple算法基础上进行了改进,利用局部敏感直方图训练直方图分类器,同时基于相对置信度实现对特征融合系数的自适应调整,相比Staple算法性能有所提高,但处理遮挡等复杂场景时仍有不足。

上述相关滤波算法从不同方面提高了目标跟踪的性能,但是用于相关滤波训练的负样本只通过正样本循环移位得到,训练的分类器对背景的判别能力有限,在背景噪声干扰、运动模糊、快速运动、脱离视野等情况下容易产生漂移。为提高目标跟踪的效果并兼顾跟踪实时性,本文提出一种多特征融合的背景感知相关滤波跟踪算法,在分类器训练阶段引入背景感知框架,从目标和周围背景区域分别提取HOG特征、CN特征和颜色直方图特征,基于自适应加权融合策略将HOG特征和CN特征的响应图进行融合,融合结果与颜色直方图特征响应图以固定系数融合,利用最大响应值估计目标位置,再引入一维尺度相关滤波器估计目标尺度,并实时更新模型参数。

2 背景感知相关滤波框架

传统相关滤波算法大多采用加余弦窗的方式抑制边界效应,负样本只通过正样本循环移位得到,导致滤波器模板学习的背景信息有限,当目标发生快速运动或者复杂背景干扰时,容易跟丢。文献[15]提出一种背景感知相关滤波框架,如图1所示。该框架在滤波器训练阶段引入目标周围背景信息,包括分类器训练、目标位置预测和模型更新3个部分。

图1 背景感知相关滤波跟踪算法整体框架图

Fig.1 Overall framework of context-aware correlation filter tracking algorithm

2.1 分类器训练

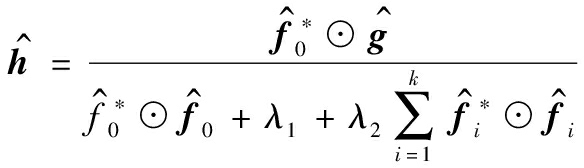

传统相关滤波目标跟踪算法采用岭回归法来预测目标位置[6-12],通过优化目标函数![]() 求解滤波器模板h,为了充分利用背景信息,背景感知相关滤波框架将目标周围的背景图像块当作正则化矩阵加入优化函数,得到的优化模型可以表示为:

求解滤波器模板h,为了充分利用背景信息,背景感知相关滤波框架将目标周围的背景图像块当作正则化矩阵加入优化函数,得到的优化模型可以表示为:

(1)

式(1)中:F0为目标图像块f0循环移位得到的样本矩阵;g为对应的期望响应,是高斯型的标签向量。对每一帧图像的f0周围进行固定采样,得到背景图像块f1, f2,…, fk和循环矩阵Fi,i=1,2,…,k;λ1和λ2为正则化参数,防止过拟合,且λ2使背景图像块回归至零。由于目标图像块中包含了很多背景图像块,共同生成了一个数据矩阵C∈R(k+1)n×n,则式(1)可以写成![]() 利用其凸函数性质求导可得封闭解

利用其凸函数性质求导可得封闭解![]() 其中

其中![]() 利用循环矩阵的性质[8]可求得:

利用循环矩阵的性质[8]可求得:

(2)

式(2)中:![]() 为对应的傅里叶变换;*表示共轭;⊙表示矩阵元素的点积。

为对应的傅里叶变换;*表示共轭;⊙表示矩阵元素的点积。

2.2 目标位置预测与模型更新

用训练得到的分类器对检测区域图像块的每个循环移位样本进行傅里叶域的相关操作,计算得到的所有响应值构成一幅响应图,最大响应点即目标的预测位置。在第t帧图像的第t-1帧预测的目标位置处,提取候选图像块样本z,得到滤波器的响应图为:

(3)

式(3)中,F-1为逆傅里叶变换,取yt最大值对应的位置作为当前帧的目标预测位置。

为适应目标外观的变化,一般采用线性内插法对模型进行更新:

(4)

式(2)中:![]() 为第t帧更新后的滤波器模板;

为第t帧更新后的滤波器模板;![]() 为更新前的模板;

为更新前的模板;![]() 为当前帧训练的目标;η∈[0,1]为学习速率。

为当前帧训练的目标;η∈[0,1]为学习速率。

3 基于多特征融合的背景感知相关滤波跟踪算法

本文算法在背景感知相关滤波框架下,结合HOG、CN和颜色直方图等3种特征进行目标跟踪。首先对HOG和CN特征的特征响应图进行自适应加权融合,然后将融合结果与颜色直方图特征响应图进行固定系数融合。利用最终融合后的响应图进行目标位置估计,并基于估计的目标位置采用尺度相关滤波器进行目标尺度估计。

3.1 特征性能分析

HOG特征是一种操作在局部区域单元的特征描述子,将目标图像区域划分成多个细胞单元,计算每个细胞单元中各像素点的梯度方向直方图组合构成目标图像的特征,能有效应对目标光照变化、运动模糊和局部遮挡等场景,但不适合处理目标形变问题。CN是一种颜色特征,相比灰度特征更能充分利用图像的颜色信息,可以很好地应对目标尺度和形变问题,因此HOG和CN特征可以互补。但是两者都属于模板特征,仍然在相关滤波框架中,具有相关滤波算法存在边界效应的固有缺陷。颜色直方图特征是一种像素级概率特征,能有效应对目标形变和快速运动情况,不属于相关滤波框架,在一定程度上能够缓解边界效应。因此,本文将模板特征和颜色直方图特征进行有效融合,充分利用两类特征的优点,提高算法的准确性和鲁棒性。

3.2 多特征融合

本文在背景感知相关滤波框架下,分别利用HOG和CN特征训练相关滤波器,根据各自输出的最大响应值作归一化处理,对2种特征进行权重分配。HOG特征和CN特征在第t帧的归一化权重分别为:

(5)

式(5)中,![]() 和

和![]() 分别为HOG特征和CN特征的响应图。

分别为HOG特征和CN特征的响应图。

特征权重更新公式为:

(6)

式(6)中,τ为权重更新因子,将第1帧HOG特征和CN特征的权重初始化为0.5。

在第t帧时,将2种特征的响应图进行线性加权融合为:

(7)

式(7)中,![]() 为融合后的模板特征响应图。

为融合后的模板特征响应图。

模板特征响应图与颜色直方图特征响应图进行融合中采用文献[13]中的固定系数线性加权方法,融合公式为:

(8)

式(8)中:α为固定融合系数;![]() 为颜色直方图特征的颜色概率响应;

为颜色直方图特征的颜色概率响应;![]() 为最终融合响应图,将其最大响应值用于目标位置预测。

为最终融合响应图,将其最大响应值用于目标位置预测。

3.3 尺度估计

尺度变化是目标跟踪中常见的问题,当相关滤波器无法准确估计目标尺度时,如果目标缩小,滤波器会学习到大量背景信息,如果目标变大,滤波器就只能学习到目标局部特征,2种情况都会导致跟踪漂移或失败。DSST算法[12]提出了一种精确的尺度估计方法,将目标跟踪看成目标中心平移和尺度变化2个独立问题,首先用二维相关滤波器检测目标中心平移,然后利用一维的尺度滤波器检测目标尺度变化。本文算法采用DSST算法的尺度估计策略。

在目标位置预测后,以目标位置为中心提取不同尺度的图像块anP×anR,其中,![]() 和R分别为目标上一帧的宽和高,a为尺度因子,S为尺度滤波个数。

和R分别为目标上一帧的宽和高,a为尺度因子,S为尺度滤波个数。

尺度相关滤波器的时域输出响应结果为:

(9)

式(9)中:yscale的最大值对应的尺度响应得分作为下一帧的目标尺度;d为特征通道数;l为特征的某一维度;Al和B为尺度相关滤波器参数;![]() 为Al的复数共轭形式;Z为检测的候选样本特征。

为Al的复数共轭形式;Z为检测的候选样本特征。

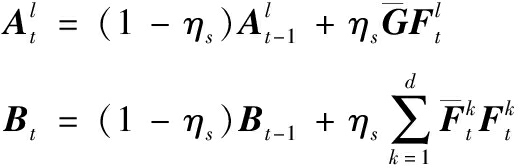

尺度相关滤波器在频域的更新公式为:

(10)

式(10)中:![]() 为第t帧第l维的目标样本特征;G为对应的尺度相关滤波器期望输出;ηs为学习速率。

为第t帧第l维的目标样本特征;G为对应的尺度相关滤波器期望输出;ηs为学习速率。

3.4 算法流程

本文提出的基于多特征融合的背景感知相关滤波跟踪算法具体流程如下:

输入:图像序列I1,I2,…,IN,初始化第一帧要跟踪的目标初始位置p0;

输出:每帧图像的目标位置pt和目标尺度St,t=1,2,…,N。

位置预测:

步骤1 在第t-1帧图像的目标预测位置pt-1处和尺度St-1上提取HOG特征和CN特征,利用文献[13]中方法提取颜色直方图特征。

步骤2 在第t帧图像的pt-1处和尺度st-1上提取HOG特征和CN特征表达的候选样本,利用式(3)分别得到![]() 和

和![]() 利用式(5)和式(6)计算得到特征权重

利用式(5)和式(6)计算得到特征权重![]() 和

和![]() 利用积分图技术在候选样本上计算得到

利用积分图技术在候选样本上计算得到![]()

步骤3 利用式(7)进行自适应融合得到![]() 利用式(8)以固定系数融合得到位置响应

利用式(8)以固定系数融合得到位置响应![]() 将其最大值对应的位置作为第t帧图像的目标预测位置pt。

将其最大值对应的位置作为第t帧图像的目标预测位置pt。

尺度估计:

步骤4 在第t帧图像的pt处,提取HOG特征的候选样本,利用式(9)得到尺度响应yscale,利用其最大值得到第t帧的目标估计尺度St。

模型更新:

步骤5 利用式(4)更新位置滤波器![]() 和

和![]() 式(10)更新尺度滤波器

式(10)更新尺度滤波器![]() 式(6)更新特征融合权重

式(6)更新特征融合权重![]() 和

和![]()

4 实验结果及分析

4.1 实验环境及参数

本文实验硬件配置环境为Intel Core i7-4790 CPU@3.6GHz,16GB内存的PC机,软件环境为Matlab R2018a。实验中滤波器采用的正则化系数λ1为10-3,λ2为0.5,位置滤波器学习速率η取0.01,权重更新因子τ为0.2,融合系数α为0.3。颜色直方图特征提取和尺度估计采用的参数与Staple和DSST算法设置相同。

4.2 算法整体性能

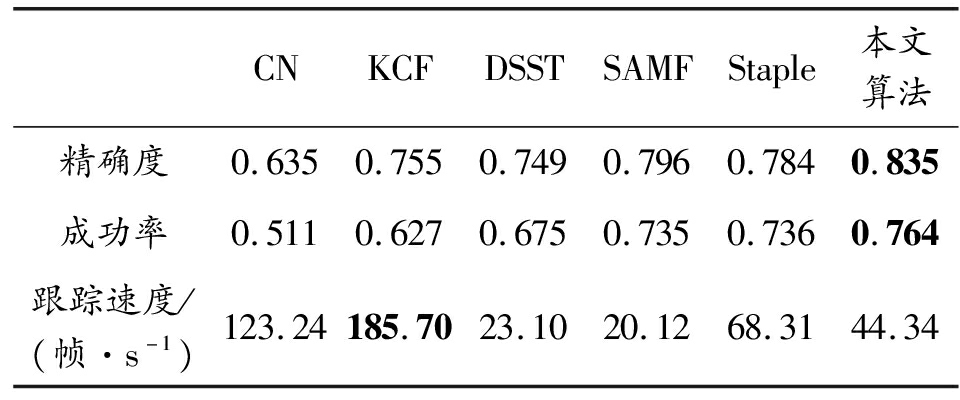

本文实验采用包含51个视频序列,具有光照变化、尺度变化、旋转、遮挡、形变、快速运动、脱离视野、背景杂乱等11种属性挑战的OTB-2013数据集[16],基于一次性评估(one-pass evaluation,OPE)方法的精确度、成功率和跟踪速度3个指标来评估算法整体性能。将本文所提算法与KCF[8],CN[9],SAMF[11],DSST[12],Staple[13]进行对比分析,如图2和表1所示,表1中最优结果用加粗表示。

表1 不同跟踪算法的跟踪性能对比

Table 1 Performance comparison of different trackers

CNKCFDSSTSAMFStaple本文算法精确度0.6350.7550.7490.7960.7840.835成功率0.5110.6270.6750.7350.7360.764跟踪速度/(帧·s-1)123.24185.7023.1020.1268.3144.34

图2 本文算法与5种跟踪算法在OTB-2013数据集上的精确度和成功率曲线

Fig.2 Precision plots and success rate plots of the proposed algorithm with 5 trackers on OTB-2013 benchmark

图2显示了本文算法和其他算法的跟踪精确度和成功率对比曲线图。可以看出,本文算法的跟踪精确度(0.835)和成功率(0.764)均优于其他算法,相比于Staple算法,在精确度和成功率上分别提高了6.51%和3.80%。第一个原因是本文算法在滤波器训练阶段引入背景感知框架,增加训练的负样本数量,使得滤波器模板对相似背景的干扰具有更强的判别能力。第二个原因是本文提出的多特征融合策略将模板特征和颜色直方图特征进行融合,较好地弥补了各自的缺点,提高了算法的准确性和鲁棒性。

表1显示了不同算法的跟踪性能和跟踪速度对比。可以看出,在跟踪速度上,本文算法在采用背景感知和3种特征融合策略后,相比Staple算法,每帧的计算量增加,跟踪速度有所下降,但仍然能够保持较好的实时性。

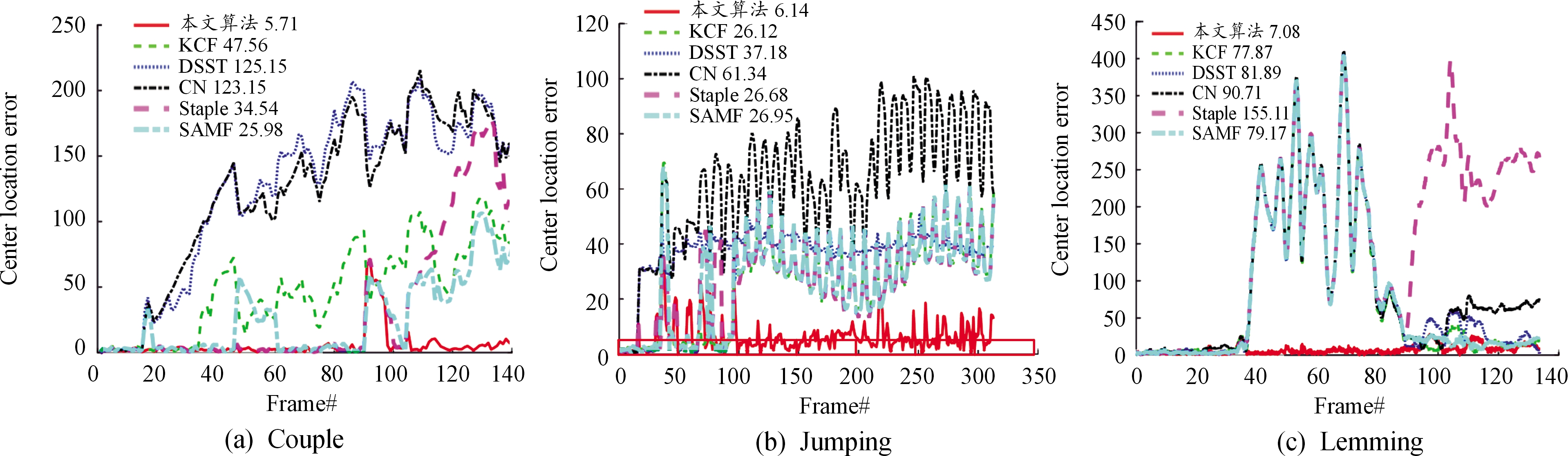

4.3 具体分析与评价

为进一步对比不同算法在具体场景中的表现,表2选取OTB-2013数据集中几个代表性视频序列,分别是Couple,Jumping,Lemming。这些序列包含光照变化、尺度变化、形变、遮挡、运动模糊、快速运动、脱离视野、背景杂乱等复杂场景。选取中心位置误差(center location error,CLE)和成功率来比较本文算法与5种跟踪算法的性能。CLE定义为目标真实中心和预测中心位置的平均欧氏距离,CLE的值越小,算法的性能越高。图3表示3个测试序列的逐帧中心位置误差。可以看出,在这3个测试序列上,本文算法的平均CLE均为最小,与次优算法相比,分别减少了20.27,19.98和70.79像素,显著提高了跟踪精度,改善了跟踪算法的性能。

表2 OTB-2013部分视频序列属性

Table 2 Attributes of some video sequence on OTB-2013

视频序列帧数场景特征Couple140尺度变化,形变,快速运动,背景杂乱Jumping313运动模糊,快速运动Lemming1327光照变化,尺度变化,旋转,遮挡,快速运动,脱离视野

图3 本文算法与5种跟踪算法在3个测试视频序列的CLE曲线

Fig.3 Center location error comparison of the proposed algorithm with 5 trackers on 3 test video sequences

图4表示了不同跟踪算法在3个测试视频序列的成功率,可以看出,本文算法的跟踪成功率在3个序列上均为最优,与次优算法相比,分别提高了30.2%,103.7%和102.6%。

图4 本文算法与5种跟踪算法在3个测试视频序列的成功率曲线

Fig.4 Success rate of the proposed algorithm with 5 trackers on 3 test video sequences

为了更加直观地进行对比分析,图5给出了不同算法在3个测试视频序列和1个光学跟踪测量图像序列的跟踪可视化结果。

图5(a)的视频序列Couple包含形变、尺度变化、快速运动和背景杂乱等,第16帧之后只有Staple和本文算法能够准确跟踪目标,在第98帧遇到相似背景的干扰时,Staple算法出现了跟踪漂移,只有本文算法能够一直准确稳定地跟踪目标,这得益于本文引入的背景感知框架能够对目标周围的区域进行学习,增强了滤波器的判别能力,能够较好地应对背景干扰问题。

图5(b)的视频Jumping可以看出,当目标出现快速运动和运动模糊时,Staple,SAMF,DSST,KCF和CN算法均跟丢目标,这是因为目标快速运动出现边界效应,导致边缘样本割裂,产生的错误样本造成滤波器判别力不够强,只有本文算法能够始终准确地跟踪目标,也验证了背景感知相关滤波框架能够在一定程度上解决边界效应问题。

图5(c)的Lemming包含光照变化、尺度变化、旋转、遮挡、快速运动、脱离视野等,在第302~373帧目标受到背景遮挡,第373帧时,Staple,SAMF,DSST,KCF和CN算法丢失目标,第552~558帧目标部分脱离视野,之后一直伴随光照、尺度变化和快速运动,本文算法在面对这些复杂场景时仍能鲁棒地跟踪目标直到结束,验证了本文提出的基于背景感知的多特征融合策略的有效性。

图5(d)的aircraft是某型航空飞行器试验光测图像序列,目标经历了尺度变化、形变、脱离视野和旋转等情况,第186帧之前,各算法基本能够稳定跟踪,在第186~196帧目标逐渐脱离视野,当目标再次出现时,只有本文算法能够准确定位目标并持续稳定跟踪,其他算法均丢失目标,进一步验证了本文算法在面对实际工程背景下的复杂场景时,相比其他算法能够取得更加准确和鲁棒的跟踪结果。

图5 本文算法与5种跟踪算法的跟踪可视化图形

Fig.5 Visualization of tracking results of the proposed algorithm with 5 trackers

5 结论

在目标跟踪中,通常会面临各种复杂场景,本文提出一种多特征融合的背景感知相关滤波跟踪算法。针对传统相关滤波跟踪算法背景信息学习不充分的问题,该算法在滤波器训练阶段引入背景感知框架,增加了训练的负样本数量,提高了分类器的判别能力;针对单一特征无法有效应对多种复杂场景的问题,提出了一种自适应的多特征融合策略,实现模板特征和颜色直方图特征响应图的最优融合,有效克服了两类特征各自的缺点;同时引入一维尺度相关滤波器用于检测目标尺度变化。本文算法能够有效应对光照变化、运动模糊、快速运动、脱离视野、背景杂乱等干扰因素的影响,在保证跟踪准确性的同时,具有较好的实时性和鲁棒性。

[1] 卢湖川,李佩霞,王栋.目标跟踪算法综述[J].模式识别与人工智能,2018,31(01):61-76.

Lu H C,Li P X,Wang D.Visual object tracking:A survey[J].Pattern Recognition and Artificial Intelligence,2018,31(1):61-76.

[2] Ma C,Huang J B,Yang X,et al.Hierarchical convolutional features for visual tracking[C]//Proceedings of the IEEE International Conference on Computer Vision.2015:3074-3082.

[3] Wang H,Zhang S,Ge H,et al.Robust visual tracking via semiadaptive weighted convolutional features[J].IEEE Signal Processing Letters,2018,25(05):670-674.

[4] Qi Y,Zhang S,Qin L,et al.Hedging deep features for visual tracking[J].IEEE transactions on pattern analysis and machine intelligence,2018,41(05):1116-1130.

[5] Li P,Chen B,Oouyang W,et al.Gradnet:Gradient-guided network for visual object tracking[C]//Proceedings of the IEEE International Conference on Computer Vision.2019:6162-6171.

[6] Bolme D S,Beveridge J R,Draper B A,et al.Visual object tracking using adaptive correlation filters[C]//Proceedings of the 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.IEEE,2010:2544-2550.

[7] Henriques J F,Caseiro R,Martins P,et al.Exploiting the circulant structure of tracking-by-detection with kernels[C]//Proceedings of the European conference on computer vision.Springer,Berlin,Heidelberg,2012:702-715.

[8] Henriques J F,Caseiro R,Martins P,et al.High-speed tracking with kernelized correlation filters[J].IEEE transactions on pattern analysis and machine intelligence,2015,37(03):583-596.

[9] Danelljan M,Khan F,Felsberg M,et al.Adaptive color attributes for real-time visual tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2014:1090-1097.

[10] 李建宁,曹文君,刘晓利.结合多尺度改进颜色特征应对遮挡的跟踪算法[J].兵器装备工程学报,2019,40(06):134-138,197.

Li J N,Cao W J,Liu X L.Tracking Algorithm for Target Occlusion by Improving Color Features Combined with Scale Pyramid[J].Journal of Ordnance Equipment Engineering,2019,40(06):134-138,197.

[11] Li Y,Zhu J.A scale adaptive kernel correlation filter tracker with feature integration[C]//Proceedings of the European conference on computer vision.Springer,Cham,2014:254-265.

[12] Danelljan M,Hager G,Khan F,et al.Accurate scale estimation for robust visual tracking[C]//Proceedings of the British Machine Vision Conference,Nottingham,September 1-5,2014.BMVA Press,2014.

[13] Bertinetto L,Valmadre J,Golodetz S,et al.Staple:Complementary learners for real-time tracking[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.2016:1401-1409.

[14] 戴伟聪,金龙旭,李国宁.基于Staple算法改进的目标跟踪算法[J].电光与控制,2019,26(06):12-17,39.

Dai W C,Jin L X,Li G N.Object Tracking Based on Improved Staple Tracker[J].Electronics Optics & Control,2019,26(06):12-17,39.

[15] Mueller M,Smith N,Ghanem B.Context-aware correlation filter tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Los Alamitos:IEEE Computer Society Press,2017:1387-1395.

[16] Wu Y,Lim J,Yang M H.Online object tracking:A benchmark[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.2013:2411-2418.