0 引言

目标检测是计算机视觉领域最重要也是最具有挑战性的分支之一。通过计算机视觉减少对人力资本的消耗,具有重要的现实意义。目前,目标检测算法按照特征提取等层面可以划分为两大类:一类是基于传统手工设计的目标检测方法,另一类是基于深度学习的目标检测方法,其中用来检测小目标[1]的方法一般是基于深度学习的目标检测[2-3],通常可以分为4类:第1类是以DSSD[4]为代表的基于多尺度预测的目标检测方法。第2类是以STDN[5]为代表的基于提高特征分辨率的目标检测。第3类是基于上下文信息的目标检测方法[6-7]。最后是基于数据增强技术的目标检测方法。

2015年Redmon等[8]提出了YOLO系列目标检测算法的首个方法YOLOv1[8]。2017年,针对YOLOv1检测精度较低的问题,Redmon等[9]加以改进提出了YOLOv2目标检测算法。YOLOv2目标检测算法的改进点主要在批归一化、高分辨率分类器、设置预选框并通过K-means算法聚类、引入新主干网络Darknet-19。2018年,Redmon等[10]对YOLOv2模型进一步优化,提出了YOLOv3目标检测模型。YOLOv3主要的改进点:基于残差连接设计新的网络结构Darknet-53、使用逻辑回归代替SoftMax作为分类器、引入特征金字塔进行多尺度检测。因为YOLO系列目标检测算法通过单元格划分的设计直接回归预测信息,避免了以往滑窗搜索法消耗大量算力和时间,因此其检测速度相较于两阶段目标检测方法更快且随着YOLO系列不断改进其检测精度持平甚至超越两阶段目标检测方法,这使得YOLO目标检测算法在学术界和工业生产中大受欢迎,广泛应用于各种视觉感知场景中。因此本文在设计装备零件装配的精准视觉感知系统时,在目前优秀的YOLO检测框架基础上,选取YOLOv7目标检测模型作为基础,针对装配环境中异形小零件提出YOLOv7-GTBM进行优化完善,设计装配机器人的粗感知视觉识别定位方法。

在实际工业生产中,除了需要通过目标检测方法得到目标类别和大致位置信息,还需要得到目标准确的整体轮廓信息,以便机器人细感知视觉定位操作。图像分割技术是从像素级进行目标分割,可以为机器人提供细粒度的目标整体轮廓信息。2015年全卷积网络(fully convolutional network,FCN)[11]实现了像素级图像语义分割,是深度学习在图像分割任务中的开创性工作。借鉴这种方法,Ronneberger等提出了基于编码器-解码器的U-Net[12]图像分割算法。2020年,一篇发表于CVPR的论文提出了一种创新的显著目标分割模型U2-Net[13],该模型基于经典的U-Net架构,采用了双层嵌套U形结构进行优化,该设计解决了U-Net网络卷积运算中由于卷积核的感受野大小而导致的特征提取缺陷,但同时也导致计算量过大。所以本文中基于U2-Net模型提出一种新的U2Net-MGP模型来进一步适配异形小零件的图像分割任务。

1 异形零件精准视觉操作平台

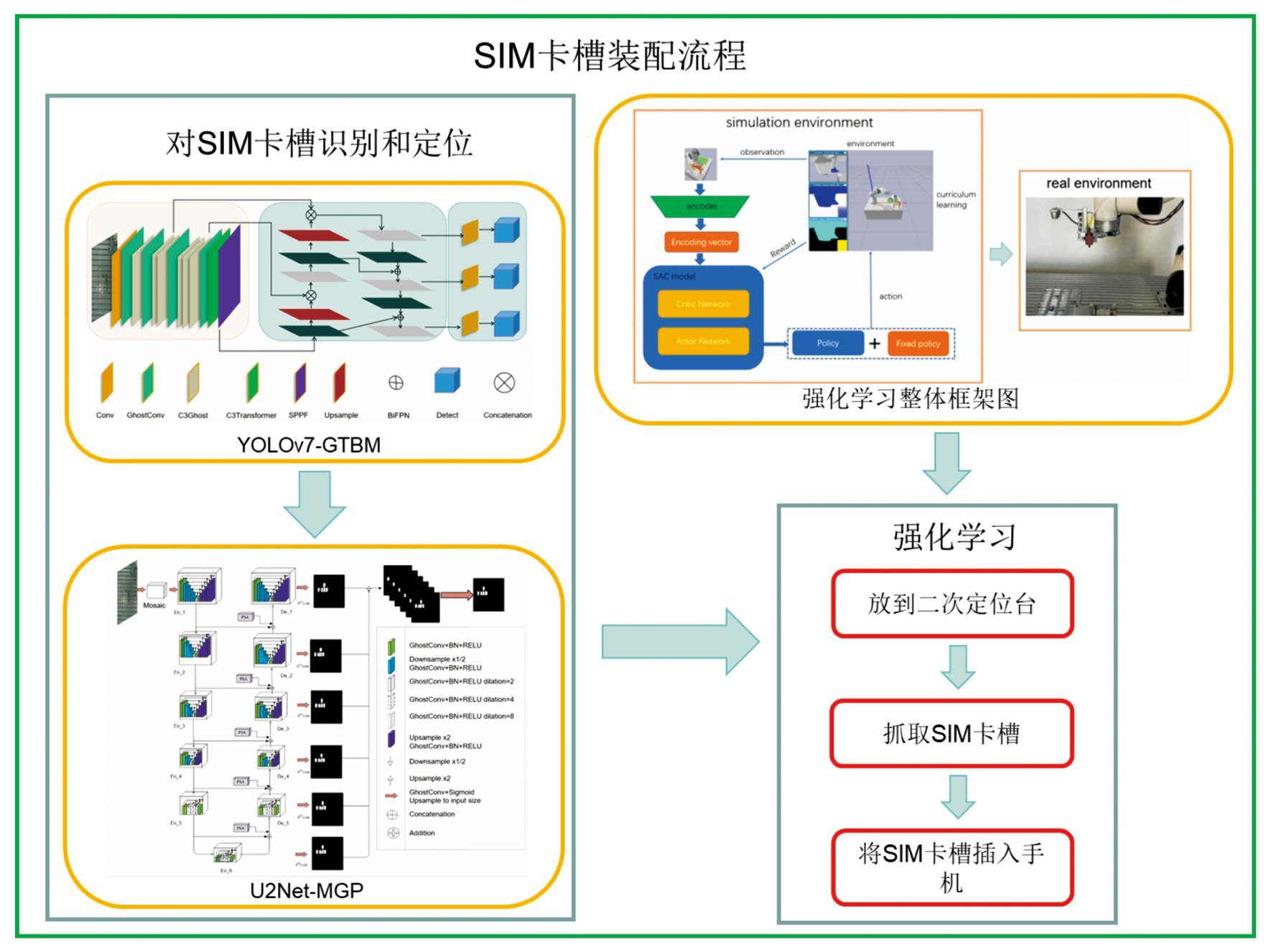

SIM卡槽为特定的异形小零件,我们用其代替其他装备生产中的异形小零件。为了应对传统目标检测和图像分割方法在精确识别异形小零件位置上的不足,本研究提出了一种创新的智能装配解决方案。在机械臂到达指定拍照位置后,利用文中所提出的YOLOv7-GTBM和U2Net-MGP算法能够精确地识别和分割SIM卡槽的图像,并计算其中心点坐标以便于精准吸取。然后按照图1所展示的强化学习方法,在虚拟环境中训练模型并迁移到现实机械臂中,从而实现了夹取、扣合等一系列智能装配步骤。流程图及整体框架如图1所示。

图1 SIM卡槽装配流程示意图

Fig.1 Schematic diagram of SIM card slot assembly process

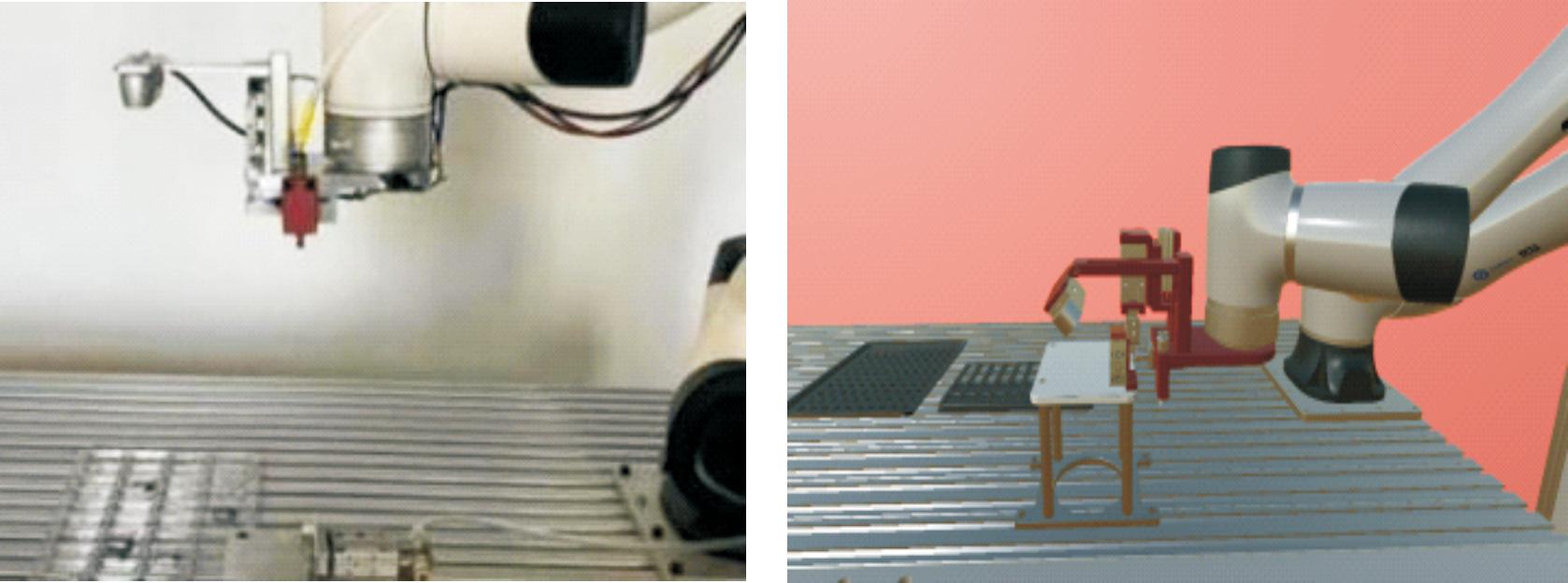

在现实场景和虚拟场景同时构建了一个SIM卡槽组装环境,该场景包括1台CR5机械臂和1个包含多个SIM卡槽的物料盘,1个工装台,1台装有红米Note 11的移动模型,以及1台Intel RealSense D435相机。由于传统的夹持器不能将SIM卡槽从物料盘中取出,所以开发了一款配备吸盘的末端执行器来执行吸取和放置任务。实际场景和虚拟场景分别在图2中展示。为了确保装配过程的高精度,实验将分为3个阶段依次执行SIM卡槽的装配任务。

图2 SIM卡槽实际场景和虚拟场景示意图

Fig.2 Actual scenario and virtual scenario of the SIM card slot

首先,机械移动至预设位置,并利用Intel RealSense D435相机捕获物料盘内SIM卡槽的图像和深度信息。随后,结合YOLOv7-GTBM和U2Net-MGP模块进行快速目标检测和分割,以图3展示的方式处理图像。

图3 SIM卡槽检测图和分割图

Fig.3 SIM card slot detection and segmentation diagram

接着,结合所获得的深度信息和检测结果,粗略定位物料盘中的SIM卡槽位置。利用分割结果,计算出SIM卡槽的最小外矩形,并估算其中心点的像素坐标。

利用手眼标定技术获得的转换矩阵以及机械臂在摄像头位置的末端姿态转换矩阵,将SIM卡槽中心的像素坐标映射到机械臂基座坐标系下,并结合深度数据确定吸附点的具体高度,然后控制CR5机械臂将SIM卡槽吸起。

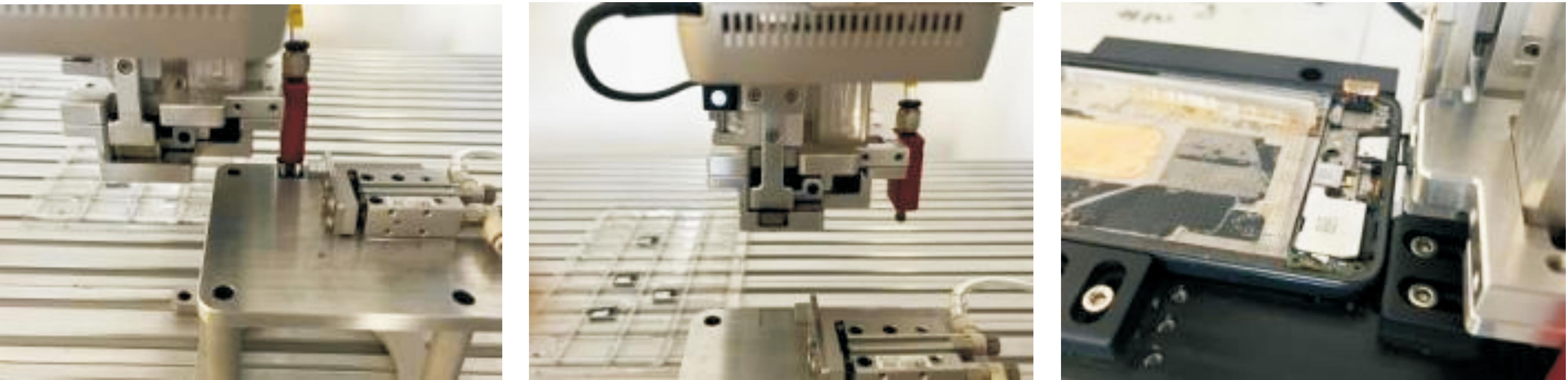

之后,机械臂运用在虚拟仿真环境中训练的技能将SIM卡槽放置于工装台上,启动气动推杆进行位置微调。通过电机控制夹爪夹住SIM卡槽后,并使机械臂末端移至手机侧面,缓慢将SIM卡槽推入预定孔位中。具体装配过程如图4所示。

图4 SIM卡槽装配流程示意图

Fig.4 Schematic diagram of SIM card slot assembly process

2 精准视觉检测和分割方法

本节基于传统视觉检测算法以及图像分割算法针对装备装配场景中异形小零件提出了YOLOv7-GTBM检测模型和U2Net-MGP分割模型,并详细描述了其组成架构及基本原理。

2.1 YOLOv7-GTBM

本研究基于YOLOv7目标检测架构,针对装备装配中异形小零件的特定需求,提出了YOLOv7-GTBM的目标检测算法,旨在实现对异形小零件的快速且粗略的视觉识别。YOLOv7-GTBM的模型架构包括数据处理的输入端、用于提取特征的主干网络、特征融合的颈部结构以及输出分类和位置信息的输出端。各个模块之间相互连接组成了整个网络架构,其中输入端负责数据增强和自适应锚框计算等操作;主干网络聚焦于高效的特征信息提取;颈部通过特征金字塔网络、路径聚合网络和双向加权特征融合网络进行特征层次的整合,并传递给预测层;最终,输出端通过卷积层对颈部融合之后的特征数据进行处理,输出目标的分类信息、位置信息等。

YOLOv7-GTBM和YOLOv7的整体框架类似,都是由多个模块组成,其结构详见图5。但是YOLOv7-GTBM在相同的计算量下,拥有更高的检测精度,更加灵活的模型结构,并且在GPU下检测速度相对较快,更容易满足实际场景应用。YOLOv7-GTBM的不同之处在于主干网络和颈部网络通过Ghost卷积优化,并且在主干网络末端增加可视化Transfor-mer模块以加强特征提取。考虑到在应用场景中对计算速度的高要求和Transformer较大的计算消耗,同时充分发挥视觉 Transformer 的全局感知能力和CNN的局部感知能力,视觉 Transformer 模块融入了CSPNet网络架构,即由3个标准卷积模块和一个Transformer Block组成,其中Transformer Block为视觉Transformer编码器架构。此外,YOLOv7-GTBM的颈部结构融入了双BiFPN模块,第1个BiFPN模块融合了自底向上的特征金字塔路径中含有丰富语义信息的特征层以及主干网络底层的位置信息丰富的特征层,以加强目标检测的位置精度。第2个BiFPN模块设计在第1个BiFPN模块下层通道中,该模块将主干网络末端提取到的特征层和第一个模块融合后的特征层进一步进行融合提高检测端的检测准确性。最后,该目标检测算法还采用 MetaACON(ActivateOr Not)激活函数[14]作为整个模型的激活函数,该激活函数在网络训练中通过学习优化自适应的激活参数来控制激活函数的线性与非线性程度,自适应的选择是否激活神经元。

图5 YOLOv7-GTBM目标检测整体架构图

Fig.5 Overall architecture of YOLOv7-GTBM target detection

Conv模块对输入的图像进行传统的卷积运算, 提取第1层特征图。第2部分用GhostConv来替换传统卷积操作,以降低计算成本并提高效率。C3Ghost模块融入了3个Ghost卷积层[15]的跨阶段部分网络(CSPNet)[16],其目的是为了增强卷积神经网络的特征提取能力,同时还可以大幅度降低计算负担。C3Transformer模块引入了视觉Transformer (ViT)[17]机制进行处理,增强模型的全局感知能力。SPPF模块,即快速空间金字塔池化(Spatial Pyramid Pooling Fast[18]),位于整个骨干网的末端,其作用是对整个骨干网提取的特征进行池化信息聚合,以促进信息整合。上采样模块通过线性插值技术放大特征分辨率。而Detect模块负责最终网络输出结果,用于输出分类信息、位置信息和置信度信息。通过引入双向加权特征金字塔网络BiFPN(bidirectional feature pyramid network,BiFPN)[19]模块进一步提升模型的检测精度和处理速度,确保能够生成更精准的全局特征。最后,拼接模块Concatenation负责将不同的特征层结合起来,形成更为复杂的特征表示。

2.2 U2Net-MGP

U2Net模型基于 U-Net 架构,进一步发展成为一种双层嵌套U型的显著性目标分割模型。该模型网络结构具有丰富的多尺度特征,并且具备较低的计算和储存成本。另外,U2Net的体系结构完全基于RSU模块构建,不依赖任何预训练的骨干网络进行图像分类处理,这使得它能够灵活地适应不同的工作环境,同时最小化性能损失。

在U2Net模型的基础上,本节提出了一种U2Net-MGP显著图像分割模型的改进算法。U2Net-MGP模型由11个RSU型残差块组成,其结构在图6中展示,可以划分为3个部分:第1部分包括左侧6个编码器,这些编码器通过逐层深入的方式逐步提取图像的深层特征;第2部分由右侧的5个解码器组成,它们主要负责将编码过程中压缩的特征信息逐步恢复,以便进行更精确的图像分割;第3部分是连接到这5个解码器的输出预测特征层。

图6 U2Net-MGP网络模型

Fig.6 U2Net-MGP network model

在编码器模块中,编码器En_1、En_2、En_3和En_4分别代表着RSU-7、RSU-6、RSU-5和RSU-4的U型残差块,RSU后面的数字表示该残差块的层数,层数越多,分辨率越高,能够捕获更多细节信息。在解码器模块中,解码器De_1、De_2、De_3和De_4的结构与编码器En_1、En_2、En_3和En_4保持一致,解码器De_5与编码器En_5采用带膨胀率的RSU-4F残差块,从整体设计来看,解码器与编码器呈对称结构。在预测特征图输出模块中,U2Net-MGP 模型的解码器 De_1、De_2、De_3、De_4、De_5 和编码器 En_6 输出侧共生成6个目标分割概率图,分别标记为![]() 和

和![]() 解码器输出特征层通过3×3的卷积操作和 Sigmoid 函数生成预测概率图。由于不同的解码器输出的预测概率图分辨率不一,因此通过上采样操作将这些概率图调整至与模型输入特征图相同的分辨率,并进行拼接。最后将拼接后的预测概率图层通过1×1卷积和 Sigmoid 函数输出级联融合目标分割预测图Sfuse。

解码器输出特征层通过3×3的卷积操作和 Sigmoid 函数生成预测概率图。由于不同的解码器输出的预测概率图分辨率不一,因此通过上采样操作将这些概率图调整至与模型输入特征图相同的分辨率,并进行拼接。最后将拼接后的预测概率图层通过1×1卷积和 Sigmoid 函数输出级联融合目标分割预测图Sfuse。

此外,本方法采用Mosaic数据增强策略[20],该策略优点在于输入网络的数据不仅包含原始的图像信息,还包含增加小目标后的图像信息,这种方法在训练过程中避免了非信息像素的出现,从而提高了训练效率,增强了模型的泛化能力,同时降低了内存需求。进一步地,该方法通过使用Ghost卷积替换编码器和解码器中传统卷积部分,极大地减轻了网络模型的负担,加快模型推理速度。在此基础上,还引入了极化自注意机制(polarization self-attention mechanism,PSA)[21],该机制结合了滤波运算来突出或抑制输入数据的某些方面。在通道和空间的注意力计算中维持较高的内部分辨率,,并在相应维度进行抑制,以提高图像分割的准确性,尤其在处理异形小零件时效果尤为显著。该自注意力机制还可以增强特征信息,利用了典型的细粒度回归输出特征分布的非线性,使得模型输出的特征信息更精细,更接近真实情况,具体结构如图6所示。

本文中提出的U2Net-MGP显著图像分割模型采用编码器-解码器架构,从多尺度特征提取、多层次特征融合、注意力机制等方面加强对目标细节信息的捕捉,提高整个模型的分割精度。

3 实验结果和分析

本节中,我们分别对粗视觉感知快速检测算法和精细视觉感知检测算法进行了消融实验和对比实验。通过一系列实验结果表明,本文中提出的方法在识别和分割SIM卡槽这类异形小零件方面,表现优于其他方案。

3.1 视觉检测算法实验

在本节实验中,验证YOLOv7和YOLOv7-GTBM在异形小零件装配场景的目标检测数据集上的收敛性表现,包括分类损失、位置损失、置信度损失和平均精度方面。YOLOv7(由蓝色曲线表示)和YOLOv7-GTBM(由红色曲线表示)的训练曲线如图7所示。

图7 YOLOv7和YOLOv7-GTBM的训练曲线

Fig.7 Training curves of YOLOv7 and YOLOV7-GTBM

由图7可知,两模型均呈现收敛状态,但YOLOv7-GTBM在分类损失、位置损失、置信度损失均低于YOLOv7,平均精度略高于YOLOv7。综上,本节提出的YOLOv7-GTBM目标检测方法实验结果要优于YOLOv7。

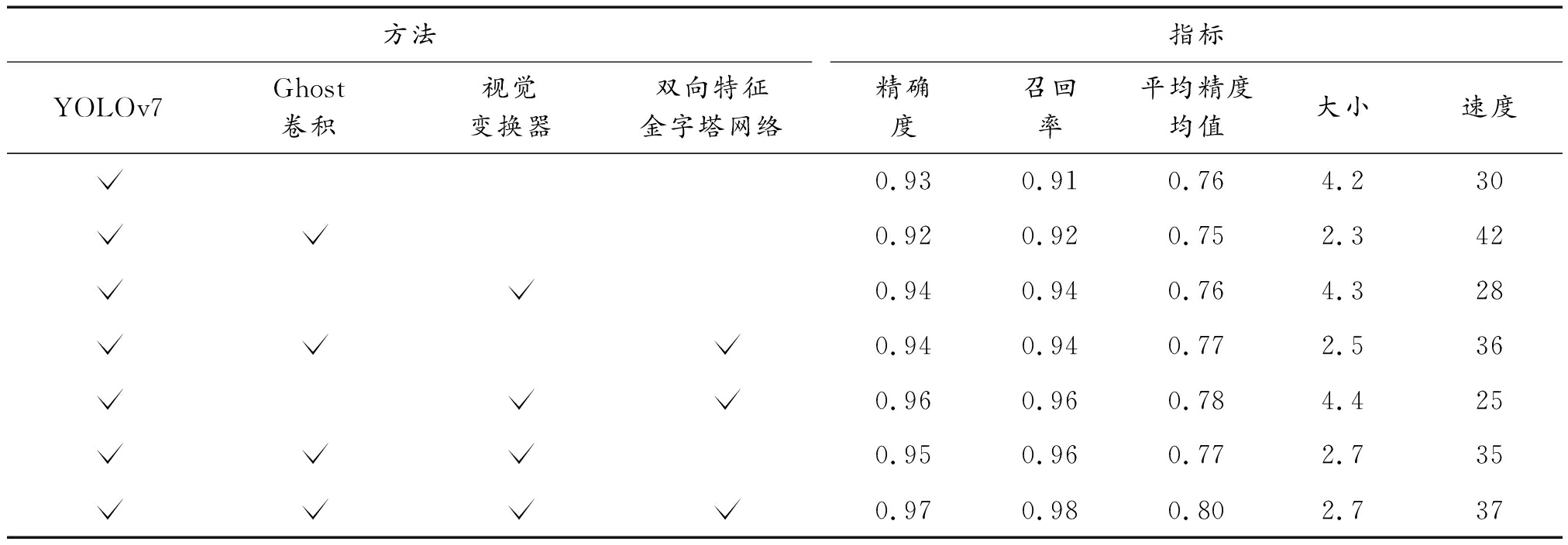

在消融实验中,本文中以YOLOv7作为基线模型,并分别添加Ghost卷积模型、视觉Transformer模块、双向加权金字塔特征融合模块以及自适应激活函数,设计了7组消融实验,如表1所示。自适应激活函数运用在整个实验中,故未单独列出。结果显示,传统的YOLOv7模型在模型大小和推理速度上表现不如采用Ghost卷积模型的版本。在Ghost模块基础上进一步加入ViT模块后,模型的查准率和查全率均有所提升。进一步分析发现,YOLOv7模型同时加入ViT和BiFPN模块后,查准率、查全率和平均精度均值(mAP) 均得到了提升,尽管在参数量和推理速度上这组实验表现最差。这表明ViT模块和BiFPN模块分别在特征提取和特征融合层面有效促进了模型性能的提升。总体来看,YOLOv7-GTBM相比YOLOv7模型在查准率、查全率、平均精度均值(mAP)、模型大小和推理速度方面均表现更佳。尤其是在模型大小方面,YOLOv7-GTBM将模型压缩至原模型的65%,显著提高了模型的效率和适用性。

表1 目标检测数据集消融实验

Table 1 Ablation experiment of target detection data set

方法YOLOv7Ghost卷积视觉变换器双向特征金字塔网络指标精确度召回率平均精度均值大小速度0.930.910.764.2300.920.920.752.3420.940.940.764.3280.940.940.772.5360.960.960.784.4250.950.960.772.7350.970.980.802.737

为了验证本文中提出的YOLOv7-GTBM目标检测方法的综合性能,选择了4种优秀的目标检测方法进行横向对比实验,即YOLOv3-tiny[22],YOLOv6[23],YOLOX[24]和Faster R-CNN。YOLOv3-tiny是一个轻量级的目标检测模型,YOLOv6和YOLOX是前几年YOLO系列的目标检测方法,鉴于YOLO系列目标检测方法是单阶段的检测方法,因此选取了具代表性的两阶段目标检测方法Faster R-CNN进行对比。具体比较结果展示在表2中。通过对比可知,针对SIM卡槽的数据集,YOLOv7-GTBM表现出了优异的性能,包括模型大小,推理速度和平均精度均值(mAP)指标等。

表2 不同模型用SIM卡槽数据集测试性能结果

Table 2 Test performance results of different models using SIM card slot data set

方法平均精度均值速度/FPS模型大小/MB YOLOv3-tiny0.765018.1YOLOv60.823458.8YOLOX0.763262.8Faster R-CNN0.7917158.2YOLOv7-GTBM0.83362.7

实验结果显示,YOLOv7-GTBM模型的收敛性优于 YOLOv7。分析原因是由于YOLOv7采用的ReLU激活函数在训练过程中容易导致神经元坏死,影响了激活作用和信息传递的效率。而YOLOv7-GTBM中采用自适应激活函数在激活和传递方面表现更为优越。在横向对比实验中,5种模型均显示出收敛性,其中YOLOv3-tiny收敛性能最弱,YOLOv7-GTBM收敛性能最强。从实验测试性能来看,YOLOv3-tiny作为轻量级网络具备推理速度快、模型小等优势但其精度相较于其他4种模型较低。YOLOv6和YOLOX的算法在精度方面表现较好,但由于模型体积较大,这在部署计算上是不利的。Faster R-CNN是两阶段目标检测方法,其精度基本与 YOLO系列接近,但是在推理速度和模型大小方面表现最差。

综合上述实验可以得出结论,YOLOv7-GTBM模型在异形小零件检测的精度上表现最佳,且在推理速度、模型大小方面也展现了出色的性能。YOLOv7-GTBM模型在装配场景中满足检测方法轻量化且具备较高检测精度的需要。

3.2 图像分割算法实验

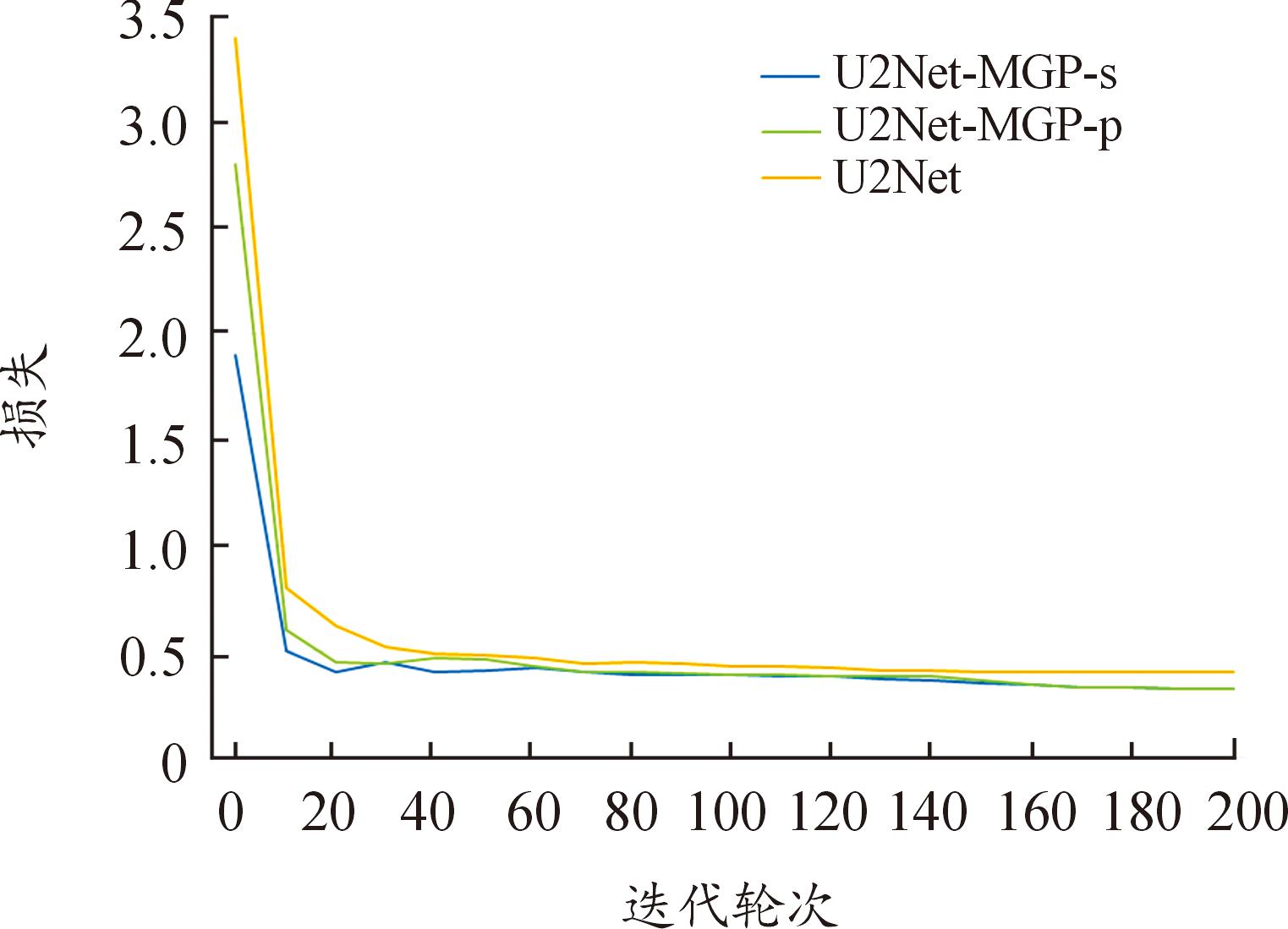

在本节中,首先对比U2Net、U2Net-MGP的极化自注意力机制串行和并行在训练中的收敛性。图8中所示 U2Net(黄色曲线)、U2Net-MGP-s串行(蓝色曲线)和 U2Net-MGP-p并行(绿色曲线)3种模型的损失曲线。

图8 U2-Net和U2Net-MGP的损失曲线(s/p)

Fig.8 Loss curves of U2-Net and U2Net-MGP (s/p)

从图8可知,在SIM卡槽的显著目标分割数据集上,U2Net-MGP串行(U2Net-MGP-s)和并行(U2Net-MGP-p) 配置的损失曲线的收敛值大致相似,U2Net模型的收敛稍微滞后于其他2个模型。这表明U2Net-MGP显著分割模型在性能上超越了原始U2Net模型,证明了其在处理SIM卡槽的显著图像分割的有效性。

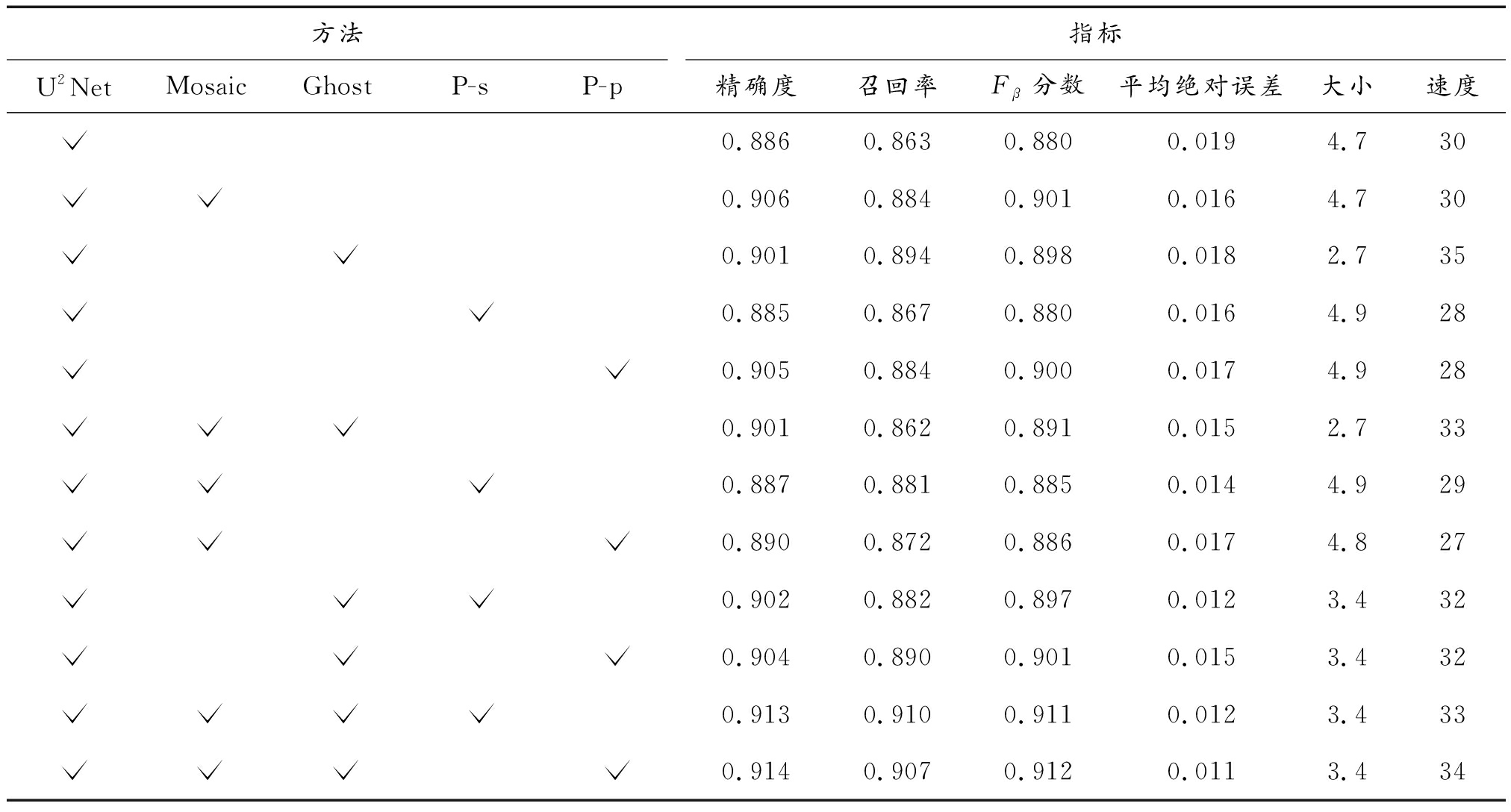

在消融实验中,以U2Net作为基线模型,并在此基础上增加Mosaic数据增强模块、Ghost卷积模块和极化自注意力机制的串行和并行模块,设计了9组消融实验,结果如表3所示。可以看出U2Net引入Mosaic数据增强模块后,模型查准率、查全率和平均绝对误差(MAE)方面均有提升。在引入Ghost卷积后,模型的推理速度和体积也显著改善。极化自注意力机制的并行配置在性能上优于串行配置。综合表中数据可以看出,U2Net-MGP在多个性能指标上均优于U2Net。

表3 图像分割数据集消融实验

Table 3 Ablation experiment of image segmentation dataset

方法U2NetMosaicGhostP-sP-p指标精确度召回率Fβ分数平均绝对误差大小速度0.8860.8630.8800.0194.7300.9060.8840.9010.0164.7300.9010.8940.8980.0182.7350.8850.8670.8800.0164.9280.9050.8840.9000.0174.9280.9010.8620.8910.0152.7330.8870.8810.8850.0144.9290.8900.8720.8860.0174.8270.9020.8820.8970.0123.4320.9040.8900.9010.0153.4320.9130.9100.9110.0123.4330.9140.9070.9120.0113.434

为了展示U2Net-MGP显著性分割方法的综合性能,本节进行了横向对比实验,其中选择了传统视觉分割方法Otsu[25]和基于深度学习的代表性分割方法FCN[26]、U-Net、DeepLab-v3[27]和BAS-Net[28]进行对比。其中,FCN是具有开创性的图像分割方法,U-Net、BASNet和DeepLab-v3是前几年应用最广泛的优秀图像分割算法。首先,从测试集中选取80幅图像进行指标测试,各评价指标的平均值如表4所示。由表4可知,U2Net-MGP模型在模型大小和推理速度方面展现了显著优势。综合分析表明,本文中提出的U2Net-MGP显著性分割方法在处理异形小零件分割任务时表现出优异的性能,其性能指标包括模型大小、推理速度、精确度、召回率、Fβ得分和平均绝对误差(MAE)。U2Net-MGP能为异形小零件装配提供更精确的细节感知视觉,从而显著提高装备装配的效率。

表4 SIM卡槽图像分割性能指标比较

Table 4 Comparison of performance indicators of SIM card slot image segmentation

方法精确度召回率Fβ分数平均绝对误差大小速度FCN0.7820.7750.7800.0761359U-Net0.8050.6130.7490.0843116BAS-Net0.8130.7980.8020.0563324DeepLab-v30.7210.7900.7330.0671607U2Net-MGP0.9230.9080.9130.0153.434

在实验部分,通过对训练的损失曲线对U2Net模型和 U2Net-MGP模型中极化自注意力机制进行串行与并行模型进行收敛性分析,证明3个模型均收敛,其中U2Net-MGP模型收敛性明显优于U2Net模型。对比实验部分,通过损失曲线分析发现FCN、U-Net、BASNet、DeepLab-v3 和 U2Net-MGP模型均显示出良好的收敛性,本节U2Net-MGP模型收敛性最好,这可能是因为U2Net-MGP属于较小的模型,而其他模型体积较大,收敛性相对较差。基于深度学习的FCN、U-Net、BASNet、DeepLab-v3方法在处理异形小目标上表现不佳,常见问题包括误分割和漏分割,无法准确划分出目标的完整轮廓。本节提出的分割方法在异形小目标上分割效果表现更为出色,不仅能完整地分割出目标轮廓,还能保留部分目标的细节信息。

综合上述实验结果,本节U2Net-MGP模型从数据增强、训练策略、轻量化网络和特征提取融合等方面来降低计算成本。此外,引入极化自注意力机制模块有效加强了目标特征的检测和融合,从而有效解决了装备装配中异形小零件场景中的目标分割问题,如误分割、漏分割、模糊以及小目标分割效果不佳等问题。

4 结论

针对装备零件装配场景中异形小零件存在识别和分割困难,导致装配效率低下等问题,开展了基于深度学习的目标检测和显著性分割方法的研究。提出了面向异形小零件装配的YOLOv7-GTBM目标检测方法和U2Net-MGP显著分割精细感知模型,这2种方法作为装配系统中的视觉感知图像处理模块。选取SIM卡槽作为典型装配场景代替其他异形小零件进行实际应用验证。视觉感知图像处理模块经过多次装配实验的测试,已证实了该平台对SIM卡槽这类异形小零件的准确识别、分割和定位能力,为SIM卡槽装配过程提供了精确的视觉感知支持,极大地提升了装配的精确度和效率。

在现代工业自动化生产中,零件识别任务是一个普遍且关键的环节。本文中所研究的粗感知检测和细感知分割仅是整个装配系统的一部分。未来将会把视觉感知图像处理平台推广到更广泛的工业应用中,覆盖更多不同类型的装备零件,替代更多的人工操作,从而大幅度降低成本提升整体生产效率这不仅会推动工业自动化的发展,同时也将为社会带来更大的经济效益。

[1] 邱凯.基于深度神经网络的小目标检测算法研究[D].成都:电子科技大学,2022.QIU Kai.Research on small target detection algorithm based on deep neural network[D].Chengdu:University of Electronic Science and Technology of China,2022.

[2] 刘颖,刘红燕,范九伦,等.基于深度学习的小目标检测研究与应用综述[J].电子学报,2020,48(3):590-601.LIU Ying,LIU Hongyan,FAN Jiulun,et al.Overview of research and applications of small target detection based on deep learning[J].Journal of Electronics,2020,48(3):590-601.

[3] 李耀琦,宗富强,杨利斌.基于深度学习的目标检测算法概述[J].兵器装备工程学报,2023,44(S1):414-421.LI Yaoqi,ZONG Fuqiang,YANG Libin.An overview of objectdetection algorithms based on deep learning[J].Journal of Ordnance Equipment Engineering,2023,44(S1):414-421.

[4] LEE P,UH Y,BYUN H.Background suppression network for weakly-supervised temporal action localization[C]//Proceedings of the AAAI Conference on Artificial Intelligence.2020,34(7):11320-11327.

[5] FU C Y,LIU W,RANGA A,et al.Dssd:Deconvolutional single shot detector[J].arXiv preprint arXiv:170106659,2017.

[6] GOODFELLOW I,POUGET-ABADIE J,Mirza M,et al.Generative adversarial networks[J].Communications of the ACM,2020,63(11):139-44.

[7] HU H,GU J,ZHANG Z,et al.Relation networks for object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2018:3588-3597.

[8] REDMON J,DIVVALA S,GIRSHICK R,et al.You only look once:Unified,real-time object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2016.779-788.

[9] REDMON J,FARHADI A.YOLO9000:better,faster,stronger[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2017:7263-7271.

[10] REDMON J,FARHADI A.Yolov3:An incremental improvement[J].arXiv preprint arXiv:180402767,2018.

[11] LONG J,SHELHAMER E,DARRELL T.Fullyconvolutional networks for semantic segmentation[C]//Proceedingsof the IEEE Conference on Computer Vision and Pattern Recognition.2015:3431-3440.

[12] RONNEBERGER O,FISCHER P,BROX T.U-net:Convolutional networks for biomedical image segmentation[C]//Medical Image Computing and Computer-Assisted Intervention-MICCAI 2015:18th International Conference,Munich,Germany,October 5-9,2015,Proceedings,Part III 18.Springer International Publishing,2015:234-241.

[13] QIN X,ZHANG Z,HUANG C,et al.U2-Net:Going deeper with nested U-structure for salient object detection[J/OL].Pattern Recognition,2020:107404.http://dx.doi.org/10.1016/j.patcog.2020.107404.

[14] MA N,ZHANG X,LIU M,et al.Activate or not:Learning customized activation[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.2021.8032-8042.

[15] HAN K,WANG Y,TIAN Q,et al.Ghostnet:More features from cheap operations[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.2020:1580-1589.

[16] WANG C Y,MARK LIAO H Y,WU Y H,et al.CSPNet:A new backbone that can enhance learning capability of CNN[C/OL]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW),Seattle,WA,USA.2020.http://dx.doi.org/10.1109/cvprw50498.2020.00203.

[17] DOSOVITSKIY A,BEYER L,KOLESNIKOV A,et al.An image is worth 16x16 words:Transformers for image recognition at scale[J].arXiv preprint arXiv:2010.11929,2020.

[18] HUANG Z,WANG J,FU X,et al.DC-SPP-YOLO:Dense connection and spatial pyramid pooling based YOLO for object detection[J].Information Sciences,2020(522):241-258.

[19] TAN M,PANG R,LE Q V.Efficientdet:Scalable and efficient object detection[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.2020:10781-10790.

[20] KISANTAL M,WOJNA Z,MURAWSKI J,et al.Augmentation for small object detection[C]//CS &IT Conference Proceedings.CS &IT Conference Proceedings,2019,9(17).

[21] LIU H,LIU F,FAN X,et al.Polarized self-attention:Towards high-quality pixel-wise regression[J].arXivpreprint arXiv:2107.00782,2021.

[22] GE P,GUO L,HE D,et al.Light-weighted vehicle detection network based on improved YOLOv3-tiny[J].International Journal of Distributed Sensor Networks,2022,18(3):15501329221080665.

[23] LI C,LI L,JIANG H,et al.YOLOv6:A single-stage object detection framework for industrial applications[J].arXiv preprint arXiv:2209.02976,2022.

[24] GE Z,LIU S,WANG F,et al.YOLOx:Exceeding yolo series in 2021[J].arXiv preprint arXiv:2107.08430,2021.

[25] XIAO L,OUYANG H,FAN C.Otsu’s thresholding method based on plane intercept histogram and geometric analysis[J].The International Arab Journal of Information Technology,2020,17(5):692-701.

[26] LONG J,SHELHAMER E,DARRELL T.Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2015:3431-3440.

[27] CHEN L C,PAPANDREOU G,SCHROFF F,et al.Rethinking atrous convolution for semantic image segmentation[J].arXiv:Computer Vision and Pattern Recognition,arXiv:Computer Vision and Pattern Recognition,2017.

[28] LEE P,UH Y,BYUN H.Background suppression network for weakly-supervised temporal action localization[C]//Proceedings of the AAAI Conference on Artificial Intelligence.2020,34(7):11320-11327.