0 引言

弹载目标跟踪技术是炮弹图像自寻中的一个基础研究课题,其目的是利用视频帧中的初始目标状态信息在后续的视频序列中预测目标的位置。由于图像自寻的弹丸在飞行过程中,弹目距离不断变化,此时获取到的弹载图像中存在大量的背景信息,会对弹载目标跟踪产生强烈干扰。同时弹丸因为旋转、抖动及章动等导致目标进出视场、像素运动模糊和旋转畸变等情况发生,这将导致在对连续弹载图像序列中的目标进行跟踪时,易发生目标丢失和跟踪漂移的情况。因此设计一种高效简洁的克服弹载环境背景干扰以及防止模型漂移的弹载目标跟踪方法至关重要。

受到结构化SVM在目标检测中应用的启发,Hare等[1]首次提出基于结构化SVM的目标跟踪方法Struck,2015年该文的扩展[2]发表在顶级国际期刊模式分析与机器智能上。Struck把目标跟踪看作结构化学习问题,避免了传统判别式跟踪的中间分类环节,显著提高了目标跟踪的性能。为了适应目标的变化同时又不丢失目标的时间上下文信息,Yao等[3]提出一种加权在线结构化SVM跟踪方法,进一步提升了结构化SVM跟踪的性能。为了提高遮挡与形变目标的跟踪性能,Yao等[4]又以在线算法Pegasos为基础,提出一种在线结构化SVM用于目标跟踪。为了解决目标跟踪中存在的模型漂移问题,Bai和Tang等[5]提出一种在线拉普拉斯排序SVM跟踪。同样是为了应对模型漂移问题,Zhang等[6]提出了MEEM跟踪,该方法以在线SVM作为基础跟踪建立专家组跟踪目标,取得了较好的效果。Hong等[7]利用在线SVM指导反向传播特定目标的CNN特征到输入层,进而建立特定目标的显著图跟踪目标,该方法建立的显著图保持了目标的空间结构,增强了目标跟踪的鲁棒性。Ning等[8]基于对偶坐标下降原理提出一种对偶线性结构化SVM目标跟踪方法,该方法在保证了目标跟踪的鲁棒性,同时又提高了目标跟踪的速度。Wang等[9]提出LMCF跟踪,该方法利用相关滤波对基于结构化SVM的目标跟踪进行了加速。Ji等[10]采用了与LMCF跟踪类似的思想来加速基于目标部件的结构化SVM跟踪。Zuo等[11]提出一种基于离散傅里叶变换的交替优化方法求解相关滤波器,并设计了多通道支撑相关滤波器跟踪目标,进一步提升了基于SVM的目标跟踪的性能。Wang等[12]提出一种将SVM目标重检测模块融合的算法,提取目标的多种特征然后将这些特征矢量融合以增强目标的特征表达。取得不错的效果。Qian等[13]将现有运动特征关联方法和信号特征辅助关联方法进行改进融合,提出一种基于历史运动特征约束和SVM频谱分类的被动声呐目标关联跟踪方法,实验结果较优。Zhang等[14]通过视频序列初始图像选择跟踪目标的位置,得到跟踪对象周围的目标和背景的特征向量,利用目标和背景特征向量训练SVM二元分类器,利用分类器对下一个视频图像进行分类,跟踪目标位置。

综上所述,基于结构化SVM的目标跟踪方法具有较优的跟踪性能,受到了广泛的关注。针对弹载目标跟踪中存在的正、负样本不平衡以及模型漂移问题,本文提出一种基于弹载图像的代价敏感与平滑约束结构化SVM模型CS_SSVM(cost-sensitive and smooth-constraints structured SVM object tracking method based on missile-borne images),基于对偶坐标优化原理设计了该模型的求解算法,并利用该算法实现一种多尺度目标跟踪方法Scale-CS_SSVM。利用自建的弹载数据集对提出的目标跟踪方法进行了实验验证,实验结果表明,本文提出的弹载目标跟踪方法与其他方法相比具有较好的性能。

1 本文方法

1.1 弹载图像跟踪面临挑战

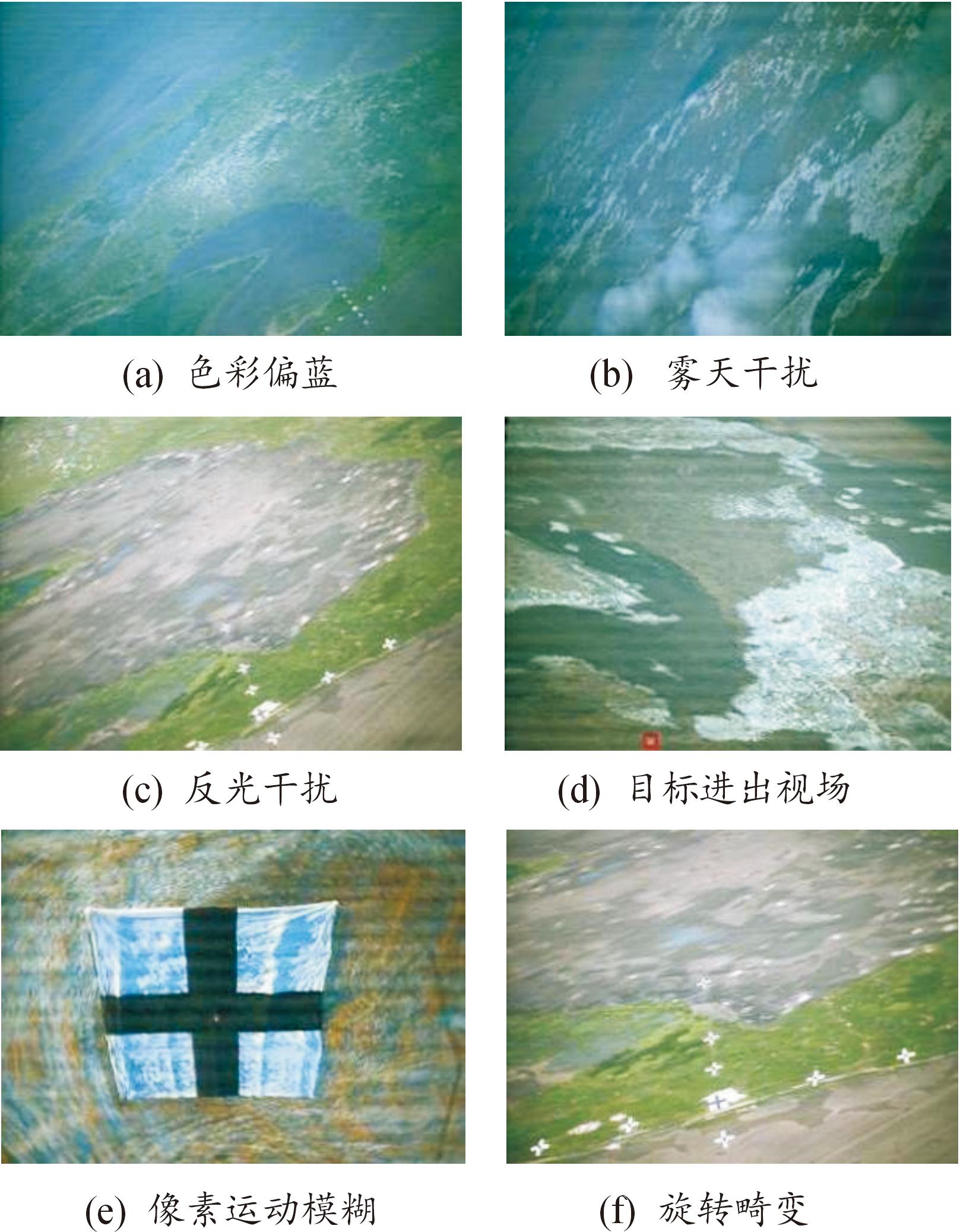

如图1所示,弹载图像面临着各种有挑战性的场景,分别有色彩偏蓝、雾天干扰、反光干扰、目标进出视场、像素运动模糊以及旋转畸变等,这些挑战容易导致当前基于弹载图像的目标跟踪方法跟踪失效。

图1 弹载图像成像面临的挑战

Fig.1 Challenges faced by missile borne-image imaging

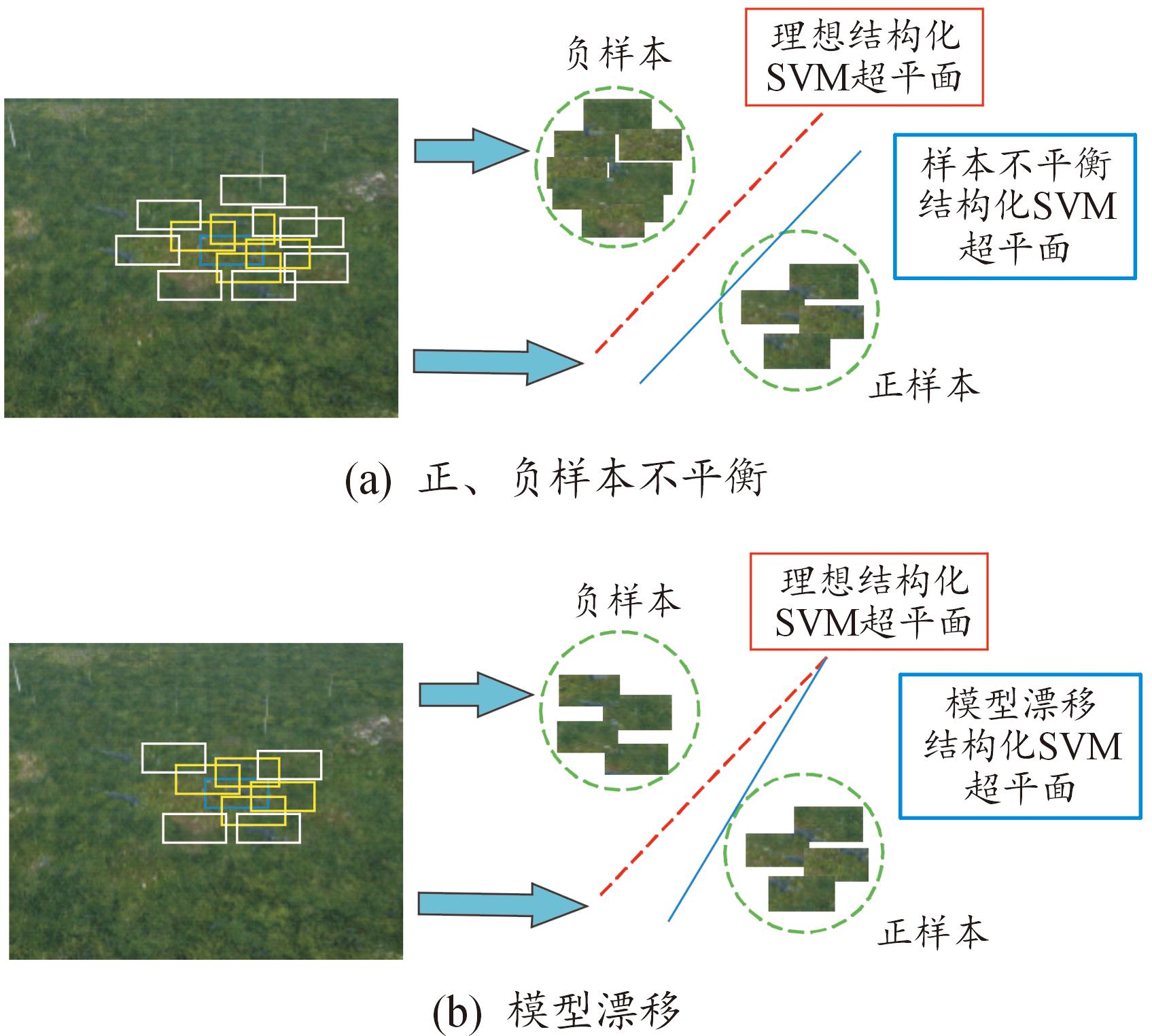

自寻的弹药打击目标时,弹丸在空中运动过程中通过弹载摄像机捕获到目标的连续图像序列,如图2所示,在弹载图像中蓝色框表示火炮目标,白色框与黄色框均为采样所得,其中白色框与目标框中心距离远且重叠阈值较小,认定为负样本,黄色框与目标框中心距离近且重叠阈值较大,认定为正样本。弹载图像中的背景信息占比较多,目标信息在图像中占比较少,在采样得到的样本中,负样本的数量远大于正样本的数量,正、负样本严重不平衡易导致跟踪失败。同时结构化SVM模型中的约束容易导致模型跟踪结果发生漂移。

图2 弹载结构化SVM目标跟踪面临问题

Fig.2 Problems faced in missile-based structured SVM object tracking

由图2可知,当负样本的数量远大于正样本时,即正、负样本不平衡时,SVM分类器的分类结果会受影响,导致分类不准确。代价敏感SVM通过分别给正、负样本赋予不同的惩罚系数以减少正、负样本不平衡对分类所带来的影响。然而所采集到的负样本中的环境背景混杂、与目标颜色相近,而且还存在相似目标以及下雨天雨水的干扰,结构化SVM在训练样本中引入大量的非目标信息,从而引起结构化SVM超平面偏移即模型漂移,进而导致跟踪失效。本文选择利用t时刻超平面法向量wt与t-1时刻超平面法向量wt-1差值的L2范数作为平滑约束,让2个视频帧中的结构化SVM超平面变化的更加平顺,不会出现结构化SVM超平面因为负样本中大量干扰因素而剧烈变化,有效抑制负样本中非目标信息对模型的影响,避免漂移情况发生。

1.2 结构化SVM

受到结构化SVM在目标检测中应用的启发,Hare等[1]提出了基于结构化SVM的目标跟踪Struck。Struck把目标跟踪看作结构化学习问题,避免了传统判别式跟踪的中间分类环节,显著提高了目标跟踪的性能。在利用结构化学习器进行预测时,其目标是预测给定样本x∈Rd的结构化输出y∈Y,其中Y可以是任意结构输出空间。在基于结构化SVM的目标跟踪中,Y是矩形框空间,它的任一元素用(x,y,w,h)表示,其中(x,y)表示矩形框的中心位置,w和h分别表示矩形框的宽和高。假设训练数据为![]() 表示矩形框y在图像x上的特征向量,则可以通过式(1)学习一个参数为w的分类器。

表示矩形框y在图像x上的特征向量,则可以通过式(1)学习一个参数为w的分类器。

![]()

(1)

式(1)中, f(x,y,w)=wΤΦ(x,y),分类器法向量w通过求解如下优化问题得到,如式(2)所示:

(2)

式(2)中: Ψi(y)=Φ(xi,yi)-Φ(xi, y);C是正则化参数;ξi是松弛变量。L(yi, y)是损失函数,表示预测输出矩形框y的结构误差损失。L(yi, y)由样本矩形y和目标矩形yi的重合率定义,如式(3)所示:

L(yi,y)=1-s(yi,y)

(3)

其中:

![]()

(4)

1.3 目标跟踪模型设计

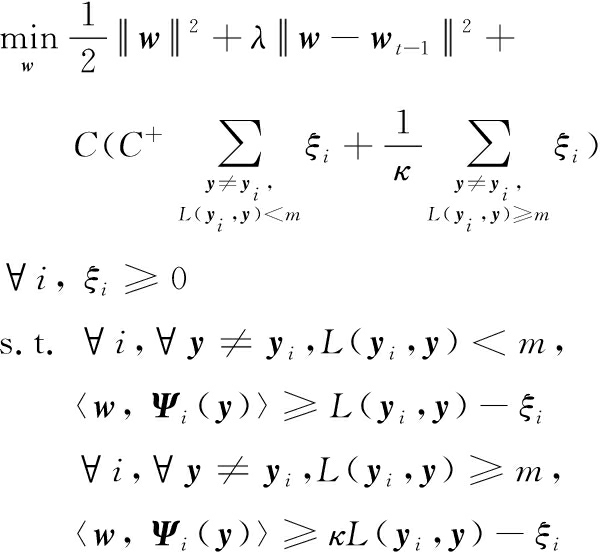

当弹载图像中的训练数据正、负样本不平衡时,结构化SVM分类器对少数类目标的识别率较低,当出现光照变化、目标遮挡时会导致模型漂移,这些问题制约了弹载目标跟踪的性能。为了解决正样本和负样本不平衡以及模型漂移对弹载目标跟踪方法性能的影响,本文将文献[15]以及L2范数约束w超平面的思想引入到文献[1]提出的结构化SVM中,设计一种基于代价敏感与平滑约束的代价敏感结构化SVM模型,如式(5)所示:

(5)

其中:

![]()

(6)

式(5)中:![]() 为正则化参数;m为阈值;b、bgt为预测框和真值框的中心点; ρ(·)为欧几里德距离;c为覆盖这2个位置框的最小包围框的对角线长度。当式(5)中损失函数L(yi,y)的值大于等于阈值m时,训练样本(xi,yi)定义为负样本,否则当L(yi,y)值小于阈值m时,训练样本(xi,yi)定义为正样本。

为正则化参数;m为阈值;b、bgt为预测框和真值框的中心点; ρ(·)为欧几里德距离;c为覆盖这2个位置框的最小包围框的对角线长度。当式(5)中损失函数L(yi,y)的值大于等于阈值m时,训练样本(xi,yi)定义为负样本,否则当L(yi,y)值小于阈值m时,训练样本(xi,yi)定义为正样本。

1.4 算法求解过程

为了求解本文提出的代价敏感与平滑约束结构化支持向量机式(5),使用拉格朗日乘子法可得到其“对偶问题”,为此引入拉格朗日乘子![]() 和

和![]() 满足如下条件,如式(7)所示:

满足如下条件,如式(7)所示:

![]()

(7)

式(5)中的拉格朗日函数如式(8)所示:

![]()

![]()

![]()

![]()

(8)

将拉格朗日函数L(w, ξ, α, β)分别对w和ξi求偏导并令其为0可得式(9):

![]()

(9)

![]()

(10)

![]()

(11)

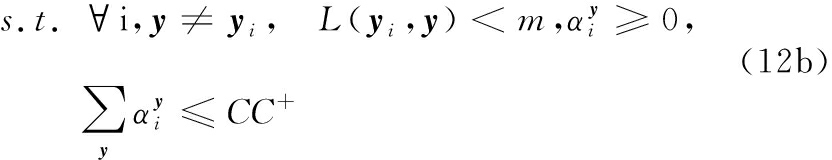

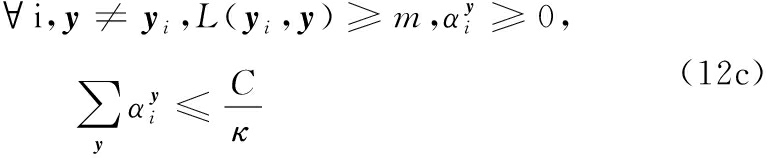

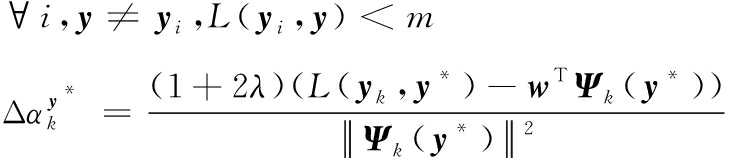

将式(9)、式(11)代入式(8),可以将L(w, ξ, α, β)中的w、 β和ξ消去,得到式(5)的对偶问题,如式(12a)—式(12c)所示。

本文模型采用线性核函数,并基于对偶坐标优化原理[16]设计模型式(12)的求解算法。对偶坐标优化原理是一种用于解决优化问题的算法。它主要用于解决带有约束条件的凸优化问题,其中目标函数可以分解为多个子问题。该算法通过在每次迭代中只更新一个变量,以最小化目标函数,从而实现高效的优化。本文是一个带有多个约束条件典型的凸优化问题,因此在求解本文算法模型时采用对偶坐标优化原理。由文献[16]可知,对偶坐标优化算法每次利用式(13)从训练集中选择一个训练样本k,然后利用式(14)更新其对偶标量![]()

![]()

(13)

![]()

(14)

解决问题的关键是如何求得式(14)中的![]() 为此,首先将式(14)代入式(12a),然后将其转化为关于

为此,首先将式(14)代入式(12a),然后将其转化为关于![]() 的函数,得到式(15)。

的函数,得到式(15)。

![]()

![]()

Δ αky*L(yk,y*)|L(yk,yi) <m-κΔ αky*L(yk,y*)|L(yk,yi)≥m+c

(15)

式(15)中:c是一个与增量![]() 无关的常量。将式(15)对

无关的常量。将式(15)对![]() 求导并令其为0可得式(16)、式(17):

求导并令其为0可得式(16)、式(17):

(16)

(17)

根据约束条件式(12b)可得:当L(yi,y)<m时,![]() 的取值范围为

的取值范围为

![]()

(18)

根据约束条件式(12c)可得:当L(yi,y)≥m时,![]() 的取值范围为

的取值范围为

![]()

(19)

根据式(16)—式(29)可以得到![]() 然后结合式(9)即可得到w的更新公式为

然后结合式(9)即可得到w的更新公式为

![]()

(20)

在基于结构化SVM的目标跟踪中,随着时间的推移,结构化SVM中的支持向量的数量不断增加。为了保证目标跟踪的效率,需要固定支持向量的数目。为此,当结构化SVM中模式数超出预算时,根据式(21)选择一个支持向量删除,本文提出的代价敏感与平滑约束结构化SVM采用这一策略。

![]()

(21)

综上所述,基于弹载图像的代价敏感与平滑约束结构化SVM目标跟踪学习算法如算法1所示。

算法1:基于弹载图像的代价敏感与平滑约束结构化SVM目标跟踪学习算法

输入:t-1时刻代价敏感与平滑约束结构化SVM的参数wt-1和模式集Pt-1,t时刻的训练样本![]()

输出:t时刻代价敏感与平滑约束结构化SVM的参数wt和模式集Pt。

步骤![]()

For j=1:n1

步骤2 计算模式集Pt中的模式数n;

步骤3 令i=n-![]() (j-1)*n/n1)」;

(j-1)*n/n1)」;

步骤4 根据式(13),从模式![]() 中选择样本;

中选择样本;

步骤5 根据式(14),更新![]() 的对偶变量

的对偶变量![]()

步骤6 根据式(20),更新wt-1;

步骤7 如果模式集Pt中的支撑向量数目大于预算数目,根据式(21)更新模式集Pt;

步骤8 计算模式集Pt中的模式数n;

For p=1:n2

令i=n-![]() (p-1)*n/n2)」;

(p-1)*n/n2)」;

步骤9 根据式(13),从模式![]() 中选择样本

中选择样本![]()

步骤10 根据式(14),更新![]() 的对偶变量

的对偶变量![]()

步骤11 根据式(20),更新wt-1;

End For

End For

步骤12 令wt=wt-1。

说明:算法1中n1和n2是外部循环和内循环的迭代次数,本文分别取5和10。

1.5 算法跟踪结果

本文使用网格搜索生成候选样本,搜索区域的大小由跟踪目标的大小自适应确定。样本的大小设定为20×20。在得到代价敏感与平滑约束结构化SVM的超平面w后,利用内积运算计算候选样本的得分,根据最大得分准则式(22)估计目标的状态。

![]()

(22)

对于目标特征,本文选择目标的Lab颜色和局部秩变换(LRT)特征,LRT特征的计算方法同文献[17],这里不再详述。基于上面的分析,本文提出的基于弹载图像的代价敏感与平滑约束结构化SVM目标跟踪方法描述如下:

方法1:基于弹载图像的代价敏感与平滑约束结构化SVM目标跟踪方法

输入:序列图像I={I1,I2,…,IT}和目标状态s1,尺度参数Sp={Sp[1],Sp[2],…,Sp[n]}

输出:每一帧的跟踪结果si(i=1,2,…,T)。

步骤1 根据当前目标状态s1,采样N个训练样本![]()

步骤2 初始w0=0和P0=0;

步骤3 调用算法1初始化t=1时刻的参数w1和模式P1;

For (t=2:T),

For ( k=1:length(Sp))

It,k=Scale(It,Sp[k]);

步骤4 利用滑动窗口在It,k上的搜索区域中采样测试样本![]()

步骤5 利用最大化得分准则估计目标当前状态:

End For

步骤6 根据当前目标状态st,采样N个训练样本![]()

步骤7 调用算法1更新模型的wt;

End For

方法1中It,k=Scale(It,Sp[k])的功能是利用尺度参数Sp[k]对图像It进行缩放,结果赋予It,k。对于单尺度目标跟踪,尺度参数Sp设定为{1},即可完成单尺度目标跟踪。对于多尺度目标跟踪,尺度参数Sp={Sp[1],Sp[2],…,Sp[n]},本文Sp={1,0.995,1.005},即在3种不同尺度图像上分别跟踪目标,以最大得分作为跟踪结果,即可完成多尺度目标跟踪,称为多尺度的代价敏感与平滑约束结构化SVM目标跟踪。

2 仿真实验与结果分析

2.1 实验设置及评价指标

在SYS-7048GR-TR台式机(CPU型号为Intel Xeon(R) ES-2630v4@2.20 GHz×20,内存为64 GB,GPU为RTX2080Ti 11G)上使用Matlab和OpenCV实现了本文提出的跟踪方法,其中Matlab版本为R2017a,OpenCV版本为2.4.8。本文提出的目标跟踪方法中有一些需要设置参数,实验中这些参数固定不变。惩罚系数C的值为100,支持向量的预算设为100,C+的值设为2,κ的值设为0.62,正样本与负样本的阈值m设为0.5,多尺度估计参数设置为Scale={1,0.995,1.005}。

跟踪数据集采用本文自建的弹载图像目标数据集上学习弹载图像目标特征及变化规律,精度指标是指中心定位误差小于20像素的帧数占视频总帧数的百分比。精度中的中心定位误差计算公式为

![]()

(23)

式(23)中: (xa,ya)表示预测目标中心位置;(xb,yb)表示真实的目标中心位置。

成功率指标是计算预测框与真值框之间的重叠度高于给定阈值(通常为0.5)的帧数占视频总帧数的百分比。重叠率计算公式为

![]()

(24)

式(24)中:Ba为预测框;Bb为真值框。

FPS/Params/FLOPS:目标跟踪方法的跟踪速度通常是由速度性能评价指标FPS(frame per second,FPS)表示的。FPS的数值代表跟踪算法每秒跟踪视频中的图片帧数,当FPS越大表示跟踪方法的跟踪速度越快,跟踪速度性能越好。参数量(parameters,Params)用于评价目标跟踪方法中网络与模型的复杂度,是网络与模型中各个权值参数之和,由于参数量较大,一般的单位为MB。FLOPS(floating-point operations per second)表示“每秒所执行的浮点运算次数”,常被用来估算电脑的执行效能,尤其是在使用到大量浮点运算的科学计算领域中,GFLOPS表示每秒10亿次的浮点运算数。

2.2 实验结果及分析

2.2.1 定量分析

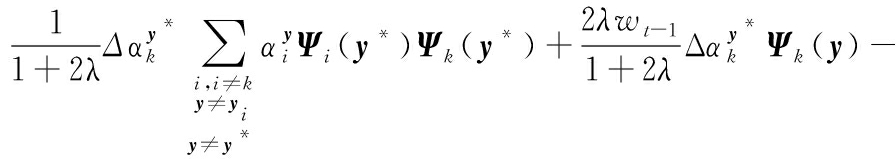

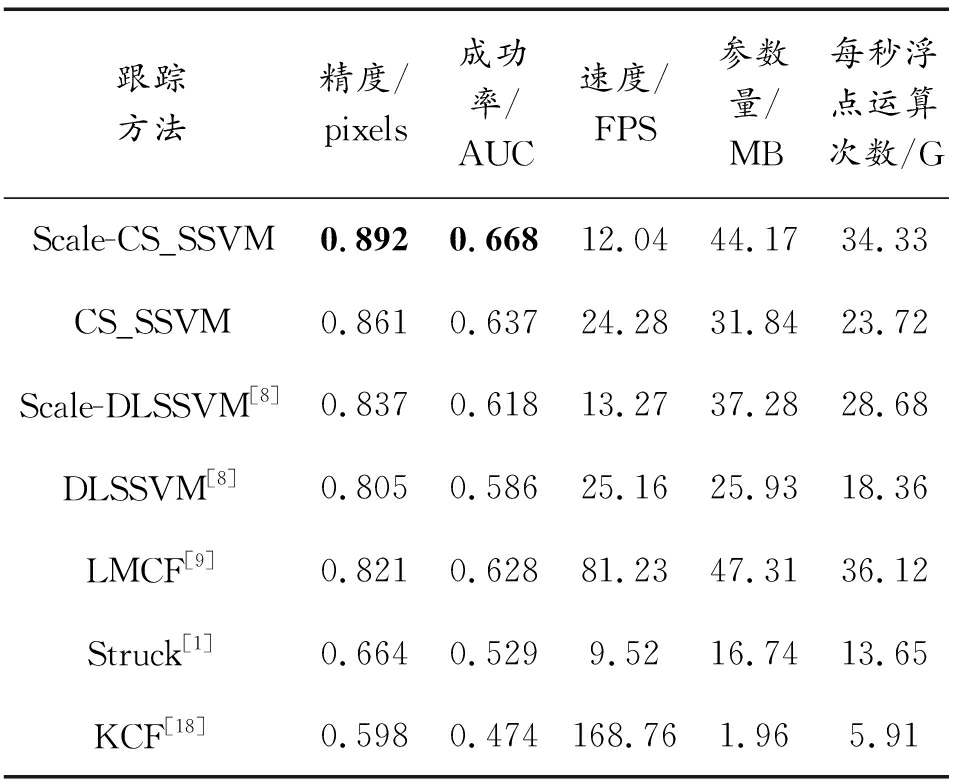

表1给出了本文单尺度方法CS_SSVM及多尺度方法Scale-CS_SSVM、DLSSVM[8]、Scale-DLSSVM[8]、LMCF[9]、Struck[1]和KCF[18]等7种跟踪方法在弹载数据集上的性能指标比较结果。

表1 7种跟踪方法在弹载数据集上的性能与效率指标

Table 1 Performance and efficiency indicators of seven tracking methods on missile borne datasets

跟踪方法精度/pixels成功率/AUC速度/FPS参数量/MB每秒浮点运算次数/GScale-CS_SSVM0.8920.66812.0444.1734.33CS_SSVM0.8610.63724.2831.8423.72Scale-DLSSVM[8]0.8370.61813.2737.2828.68DLSSVM[8]0.8050.58625.1625.9318.36LMCF[9]0.8210.62881.2347.3136.12Struck[1]0.6640.5299.5216.7413.65KCF[18]0.5980.474168.761.965.91

1) 性能分析。从表1可以看出,在精度和成功率2项指标上,本文提出的多尺度方法Scale-CS_SSVM均明显优于其他跟踪方法。在跟踪的精度和成功率上分别比Scale-DLSSVM提高了5.5和5.0个百分点。在性能上有明显提升,跟踪成功率达到66.8%,在跟踪速度上,虽然KCF在跟踪速度达到168.76 FPS,但是相应的跟踪精度和成功率较多尺度方法Scale-CS_SSVM分别低了29.4和19.4个百分点。

2) 效率分析。从表1中可以分析出,KCF算法参数量最小1.96 MB,相应的浮点运算次数最小5.91 G,同时跟踪处理速度最快,但是精度和成功率最差。因为LMCF通过多种方式获取特征,因此LMCF算法参数量和浮点运算次数比其他方法的都高,运算复杂度高。本文多尺度方法Scale-CS_SSVM较之前的多尺度方法Scale-DLSSVM参数量增加6.89 MB,浮点运算次数增加5.65 G,跟踪速度降低1.23 FPS。本文单尺度方法CS_SSVM较于改进之前的单尺度方法DLSSVM参数量增加5.91 MB,浮点运算次数增加5.36 G,跟踪速度降低0.88 FPS,但是跟踪精度和成功率提升明显,整体效率最高。

2.2.2 定性分析

通过定性实验显示本文方法可以有效解决弹载图像跟踪中正、负样本不平衡以及模型漂移的问题。定性跟踪结果如图3所示。Scale-DLSSVM方法会随着目标周围环境背景等大量负样本的干扰,跟踪框会出现漂移现象,最后导致跟踪精度和成功率下降。当采用本文Scale-CS_SSVM方法时,随着弹目距离接近,通过增加代价敏感和平滑约束的方式提高了对目标的识别和定位能力,能够避免跟踪模型因为坦克外形和环境的变化引起模型漂移导致跟踪失效的情况发生。

图3 跟踪结果

Fig.3 Tracking results

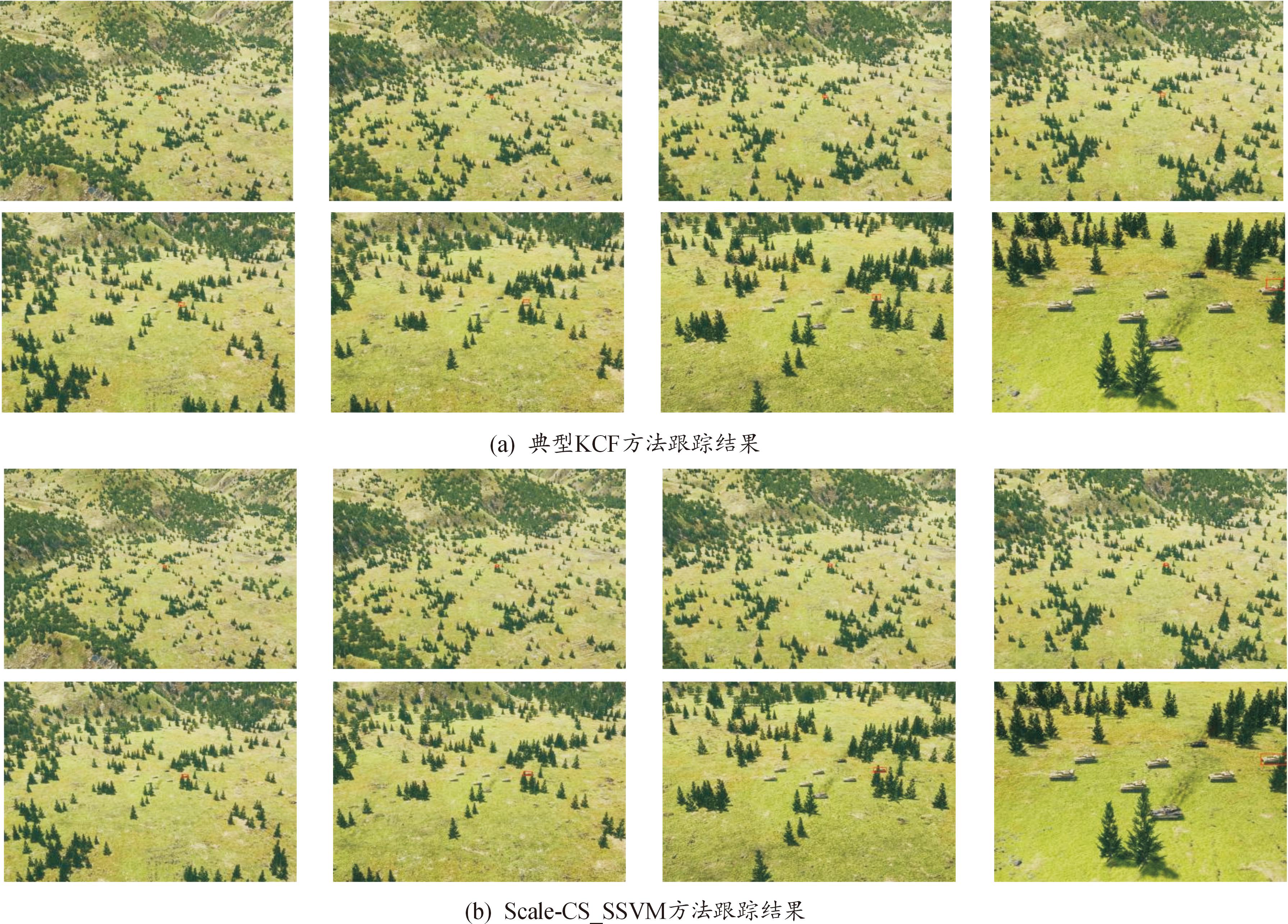

本文方法旨在解决弹载环境下正、负样本不平衡以及模型漂移的问题。弹载环境下,背景信息在采样过程中被大量的引入,过多的背景信息导致结构化SVM模型在跟踪时超平面发生偏移,通过对结构化SVM模型同时施加代价敏感权重和平滑约束,平衡正、负样本所占比例,抑制复杂背景引起模型漂移问题。在复杂弹载环境具有与目标颜色背景相近的复杂地貌中,如图4所示,将本文方法与典型弹载目标跟踪方法KCF相比,由于此弹载视频环境中目标坦克与山林的颜色相近,且目标被背景中的树木有部分的遮挡干扰,本文方法能够有效克服弹载环境背景所带来的干扰以及引起的模型漂移,而典型弹载目标跟踪方法KCF受环境影响,跟踪模型发生漂移,导致跟踪失效。

图4 跟踪结果

Fig.4 Tracking results

3 结论

本文指出自寻的炮弹在跟踪目标的过程中,获取到的弹载目标图像中含有大量背景干扰信息,在基于弹载图像的情况下使用结构化SVM目标跟踪方法进行跟踪采样时会出现正、负样本不平衡以及模型漂移的问题。针对存在的这些问题,本文提出基于弹载图像的代价敏感与平滑约束的结构化SVM的目标跟踪方法。通过弹载数据集对方法进行了实验验证和分析。实验结果表明,本文方法相比于基础方法在跟踪精度和成功率上都有较大提升。本文在特征表达上尚有不足,本文方法所采用的特征为传统的LRT以及颜色特征,并未使用深度神经网络提取深度特征,下一步工作将在传统的弹载目标跟踪方法中添加更具有学习和表达能力的深度特征,以期望能够进一步提升性能。

[1]HARE S,SAFFARI A,TORR P H S.Struck:structured output tracking with kernels[C]//Proceedings of IEEE International Conference on Computer Vision:Barcelona:IEEE Computer Society Press,2011:263-270.

[2]HARE S,SAFFARI A,TORR P H S.Struck:structured output tracking with kernels[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2016,38(10):2096-2109.

[3]YAO R,SHI Q F,SHEN C H,et al.Robust tracking with weighted online structuredlearning[C]//Proceedings of the European conference on Computer Vision.Berlin:Springer,2012,Part III:158-172.

[4]YAO R,SHI Q F,SHEN C H,et al.Part-based visual tracking with online latent structural learning[C]//Proceedings of Computer Vision and Pattern Recognition.Portland,OR:IEEE Computer Society Press,2013,2363-2370.

[5]BAI Y C,TANG M.Robust tracking via weakly supervised ranking SVM[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Providence,RI:IEEE Computer Society Press,2012,1854-1861.

[6]ZHANG J M,MA S G,SCLARFF S.Meem:Robust tracking via multiple experts using entropy minimization[C]//Proceedings of European Conference on Computer Vision.Zurich:IEEE Computer Society Press,2014,188-203.

[7]HONG S,YOU T,KWAK S,et al.Online tracking by learning discriminative saliency map with convolutional neural network[C]//Proceedings of International Conference on Machine Learning.Lille IEEE Computer Society Press,2015,597-606.

[8]NING J F,YANG J M,JIANG S J,et al.Object tracking via dual linear structured SVM and explicit feature map[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas:IEEE Computer Society Press,2016,4266-4274.

[9]WANG M M,LIU Y,HUANG Z Y.Large margin object tracking with circulant feature maps[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Honolulu,HI:IEEE Computer Society Press,2017,4800-4808.

[10]JI Z J,FENG K,QIAN Y H.Part-based visual tracking via structural support correlation filter[J].Computing Research Repository,2018(10):74-82.

[11]ZUO W M,WU X H,LIN L,et al.Learning support correlation filters for visual tracking[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2019,41(5):1158-1172.

[12]王承赟,王思卿,张龙杰,等.融合SVM的多特征DSST目标跟踪算法[J].兵工自动化,2021,40(7):39-45,66.WANG Chengyun,WANG Siqing,ZHANG Longjie,et al.A multi feature dSST target tracking algorithm based on SVM Fusion[J].Ordnance Industry Automation,2021,40(7):39-45,66.

[13]钱宇宁,陈亚伟,李归.基于历史运动特征约束和SVM频谱分类的被动声呐目标关联跟踪方法[J].电子与信息学报,2023,45(8):1-11.QIAN Yuning,CHEN Yawei,LI Gui.Passive sonar target association tracking method based on historical motion feature constraints and SVM spectrum classification[J].Journal of Electronics and Information Technology,2023,45(8):1-11.

[14]ZHANG F.Moving object tracking method based on {SVM} and meanshift tracking algorithm[C]//Proceedings of the International Conference on Deep Learning Technologies,Xi’an,China,2022:84-88.

[15]IRANMEHRA,MASNADI-SHIRAZIH,VASCONCELOSN:Cost-sensitive support vector machines[J].Neurocomputing,2019,34(3): 50-64.

[16] SHEN Kaiming,YU Wei.Downlink cell association optimization for heterogeneous network via dual coordinate descent[C]//Proceedings of the International Conference on Acoustics,Speech and Signal Processing,Vancouver,BC,Canada,May 26-31,2013:4779-4783.

[17]ZABIH R.Non-parametric local transforms for computing visual correspondence[C]//Proceedings of European Conference on Computer Vision,Stockholm,Sweden:IEEE Computer Society Press,1994:151-158.

[18]HENRIQUES J F,CASEIRO R,MARTINS R,et al.High-speed tracking with kernelized correlation filters[J].IEEE Trans.Pattern Anal.Mach.Intell,2015,37(3):583-596.