0 引言

目标跟踪是一个基本的视觉任务,在仅提供任意目标第一帧位置的情况下,推断确定视频序列后续帧中的对应目标位置。目标跟踪在民用安全与军事国防等领域都取得了成功应用,比如视频监控、智慧医疗、人机交互、自动驾驶、精确制导、巡飞弹追踪等方面[1]。在这些应用中,巡飞弹结合了无人机技术与弹药技术,拥有无人机高灵巧型的特点,也具有常规弹药的毁伤能力,因此越来越多国家将其视为现代战争的重要打击手段。本文以巡飞弹作战环境为任务背景,研究基于巡飞弹平台的视觉目标跟踪算法。

目标跟踪算法大致可分为传统方法、基于相关滤波的方法、基于深度学习的方法。深度学习中基于孪生网络的目标跟踪算法在保证实时性的同时,还能实现较高准确度,适合巡飞弹对于作战稳定性和打击精准度的实际需求,因此本文算法是基于深度学习的孪生网络架构算法。

在基于深度学习的系列算法中,SiamRPN[2]的孪生区域候选网络是具有代表性的,它引入的区域候选网络由一个用于前后景估计的分类网络和一个用于回归的锚框微调网络组成。SiamCAR[3]、Ocean[4]等算法将无锚框方法用于目标跟踪中,取代了区域候选的方法。无锚框方法降低了网络的计算量,也提高了回归精度。因此本文算法使用无锚框的方法进行逐像素的端到端回归。

在孪生网络中,分类分支与回归分支在训练时相对独立,这种低相关性损害了跟踪算法的精度。虽然 SiamFC++[5] 等通过引入质量评估分支缓解了低相关性的损害,但质量评估分支与分类分支在训练过程中仍然相互独立,这种低相关性仍然会损害跟踪性能。因此,本算法借鉴了周丽芳等[6]提出的IOU质量评估分支来代替传统的分类分支。在保证跟踪精度的同时,降低了参数量,提高了跟踪速度,更有利于巡飞弹的实时跟踪。

对跟踪器来说,同时学习不变性和等变性至关重要。随着CNN网络的加深,物体会逐渐丢失部分和整体的关系,因此深层网络得到的主要是不变特征,浅层网络得到的主要是等变特征。因此有研究者将特征融合应用在目标跟踪领域,通过特征融合来充分利用神经网络的深浅层特征。SiamRPN++[7] 与SiamCAR简单利用了深浅层特征的融合,忽略了分类与回归的不同任务属性。分类与回归任务对融合特征所涵盖的空间特征与语义特征的要求不同,因此,本文通过调整融合特征中深浅层特征的比例来优化网络结构。

除了深浅层的纵向特征融合方式,Ocean算法中提出了特征合并的方法,可以对同一层特征进行多次卷积膨胀并采用逐点相加的方式进行横向的特征融合。因此,本文将特征合并的方法引入算法框架中,利用特征合并辅助纵向特征融合方式,得到更优的融合特征用于目标跟踪任务。

1 轻量化巡飞弹目标跟踪算法框架

本节详细介绍了基于特征融合的轻量化目标跟踪框架,相关示意图如图1所示。本文以逐像素的无锚框方式解决目标跟踪问题。算法框架由3部分组成:特征提取与特征合并子网络、特征融合模块、IOU与回归子网络。特征提取与特征合并子网络包括模板分支与搜索分支,选取AlexNet作为骨干网络来提取特征,分别对模板图像和搜索区域进行卷积,得到各卷积层对应的特征层。然后通过1×1卷积调整特征层通道数,控制通道数比例,用于后续的特征融合模块。然后进行特征合并,获得有不同感受野的融合特征。特征融合模块将输入的4个不同层的融合特征进行特征拼接,得到最优的融合特征图。将所得的融合特征图输入IOU质量评估分支与回归分支,得到各自对应的质量评估特征图与回归特征图。

图1 基于特征融合的轻量化目标跟踪框架示意图

Fig.1 Diagram of lightweight object tracking framework based on feature fusion

1.1 特征提取与特征合并子网络

1.1.1 特征提取

深层的骨干网络能提取出信息更丰富的特征,但会消耗大量的算力。有些深层的网络结构,比如ResNet[8]、GoogleNet[9]、VGG[10]、Inception[11]、MobileV2[12]等深层网络结构在高配置平台上可以保证跟踪实时性,但在巡飞弹平台上进行实际应用时,由于功耗和体积等因素,硬件平台有时难以支撑计算量复杂的模型。因此,本文框架选用Alexnet[13]这一低参数量的轻量化浅层网络架构,通过优化框架,削弱使用浅层网络所导致的性能下降的不利影响。

利用修改后的Alexnet作为骨干网络进行特征提取。进行特征提取时包括2个分支:模板分支将模板图像Z作为输入,搜索分支将搜索区域X作为输入。本框架应用孪生架构,2个分支共享同一卷积神经网络作为它们的骨干网络,然后输出特征图φ(z)和φ(x)。将φ(z)作为φ(x)的卷积核来执行互相关操作,来融合2个分支的信息,得到响应图R。在后续的子网络中,通过解码响应图R来获得目标的尺度信息和定位信息。响应图R应该包含丰富的信息内容,传统互相关操作只能形成单通道的压缩响应图,缺乏有用特征和重要信息,受SiamRPN++启发,在此使用深度互相关操作来生成多通道响应图:

R=φ(x)★φ(z)

(1)

式(1)中:★代表深度互相关操作,生成的响应图R与φ(x)、φ(z)有相同通道数,包含大量空间信息与语义信息。

1.1.2 特征合并

该步骤利用一个深度互相关操作来融合搜索区域图像和样本图像中提取出的特征,生成一个对应的相似性特征图用于后续的目标定位。先前的工作都在多尺度特征上进行互相关操作,而Ocean的特征合并方法只在一个尺度上进行操作。特征合并方法将单尺度特征通过3个并行的膨胀卷积层,然后分别进行深度互相关,最后采用逐点相加的方法将3个所得特征进行融合,如图2所示。特征合并的过程可被描述为

S=∑abφab(fx)*φab(fz)

(2)

图2 特征合并示意图

Fig.2 diagram of feature combination

式(2)中: fx和fz代表搜索区域图像与样本图像的特征; φab代表单独的膨胀卷积层;*代表互相关操作。膨胀卷积φab被设置为3×3,膨胀步长在X轴方向设置为a,在Y轴方向设置为b。实验中,张志鹏等[4]发现提升膨胀的多样性可提升特征的表征能力,选择了3种不同的膨胀,步长分别设置为(a,b)∈{(1,1),(1,2),(2,1)}。不同膨胀的卷积可获得不同尺度的特征区域,提升最终融合特征的尺度不变性。

1.2 特征融合模块

目标跟踪领域中,很多跟踪框架都利用深浅层特征融合,但用于分类和回归分支的融合特征相同,没有根据任务要求来细化区分融合特征。本文根据回归分支的特点,构建适合回归分支的融合特征。因为IOU质量评估分支对于融合特征的信息要求与回归分支类似,所以使用相同的融合特征用于IOU质量评估分支。

特征融合的方法分为早融合与晚融合,使用早融合的有FCN[14]、Inside-Outside Net[15]、HyperNet[16]等,使用晚融合的有FPN[17]、DenseNet[18]等。早融合中的基本融合方法有逐点相加和拼接[19],晚融合中包含各种复杂的特征融合方式。逐点相加属于拼接的特殊形式,其他的特殊融合方式相较于拼接更为复杂。

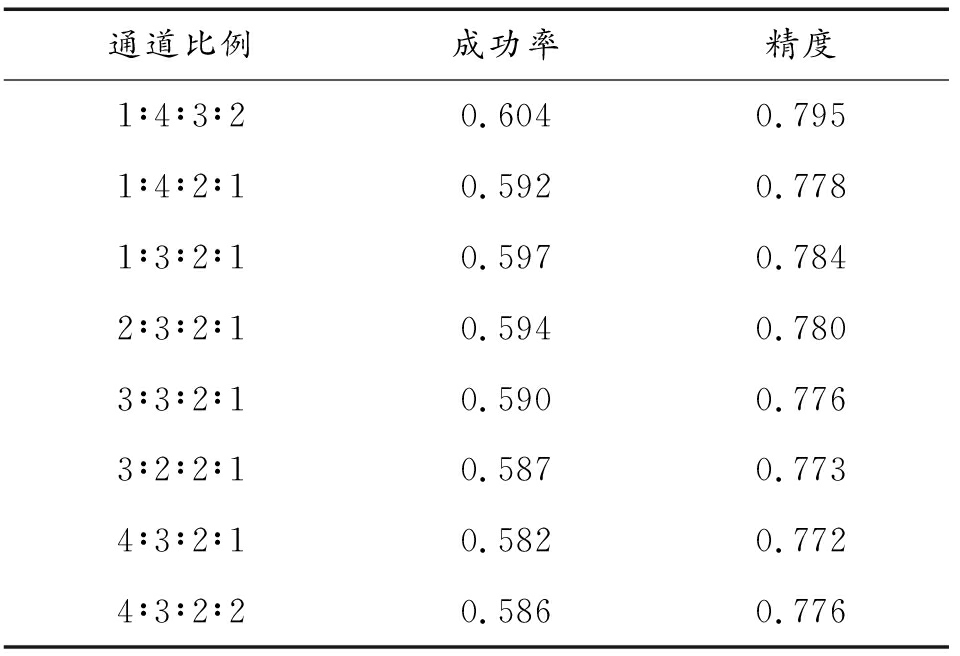

选用AlexNet网络结构的后4个卷积层所对应的特征图来进行深浅层融合。如图1所示,搜索分支对应F1(x)、F2(x)、F3(x)、F4(x),模板分支对应F1(z)、F2(z)、F3(z)、F4(z)。本文通过控制不同特征层的通道比例来间接控制深浅层特征图的信息含量。回归分支需要更多的空间特征,浅层特征包含更多的空间特征,所以对应的融合特征应该包含较多浅层特征。因此,用于2分支的4个特征图的通道比例应从多到少,但第一层特征图所处网络位置太浅,含噪音太多,不能在融合特征中占据太大比例,否则会影响最终结果。选取了8组参数,将所得结果进行比较,最终选取1∶4∶3∶2作为通道数比例的参数。此操作通过特征合并之前的1×1卷积操作来调整通道数。将经过特征提取与特征合并子网络所得的F1、F2、F3、F4输入特征融合模块,通过特征拼接方法进行融合,得到最终的融合特征图。

1.3 IOU与回归分支子网络

IOU与回归子网络包括IOU质量评估分支和回归分支,一起作用完成目标边界框的位置预测,进行目标跟踪。

每个在融合特征图FIOU与Freg上的位置点(i, j)都可以映射回输入的搜索区域上,标记为(x,y)。本文框架采用无锚框的方法,在每个位置精准地回归目标边界框。通过全卷积操作以端到端的方式进行相关的训练,避免了调参过程,减少了人为干预。

跟踪任务被分为2个子任务:每个位置的IOU质量评估任务和计算目标边界框的回归任务。将特征融合所得F输入IOU质量评估分支,得到质量评估特征图![]() 将特征融合所得F输入回归分支,得到用于目标定位的回归特征图

将特征融合所得F输入回归分支,得到用于目标定位的回归特征图![]() 上每个点(i, j)都包括一个数值,代表搜索图像区域上对应位置的IOU质量评估分数。类似地,

上每个点(i, j)都包括一个数值,代表搜索图像区域上对应位置的IOU质量评估分数。类似地,![]() 上的每个点(i, j)都包括一个四维向量:(l,t,r,b),代表搜索图像区域上对应位置到边界框4个边的距离。

上的每个点(i, j)都包括一个四维向量:(l,t,r,b),代表搜索图像区域上对应位置到边界框4个边的距离。

为了保证算法性能,需选择与各分支适配的损失函数。对于IOU质量评估分支,本文选择QFL损失函数[20],对于回归分支,本文选择DFL损失函数与IOU损失函数。

1) IOU质量评估分支损失函数。采用Li Xiang等[20]提出的QFL损失函数来训练IOU质量评估分支,具体的函数表达式如式(3)所示:

QFL(σ)=-|y-σ|β((1-y)log(1-σ)+ylog(σ))

(3)

式(3)中: y为质量评估分支标签; σ为质量评估分支预测结果; β为控制比例常数。

2) 回归分支损失函数。回归分支一般采用IOU损失函数,受Li Xiang等所提GFL启发,本文引入DFL损失函数来优化IOU损失函数。

Li Xiang等提出直接学习没有引入其他先验条件的基本一般分布P(x),来替代狄拉克分布[21]和高斯分布[22]。给定标签y的范围,最小值是y0,最大值为yn(y0≤y≤yn, n∈N+),可以从模型中得到估计值y*(y*也满足y0≤y*≤yn):

![]()

(4)

为了与卷积神经网络相对应,Li Xiang等人引入间隔,将连续区域分为散点表征,用间隔Δ将范围(y0,yn)转换成一个集合{y0,y1,…,yn-1,yn},Δ= yi+1-yi,∀i∈[0,n-1]。离散分布性质![]() 则估计回归值y*可表示为

则估计回归值y*可表示为

![]()

(5)

边界框学习仅适用于正样本,无类不平衡危险,故可以简单地将QFL交叉熵部分应用到DFL定义中:

DFL(Si,Si+1)=-(yi+1-y)log(Si)+

(y-yi)log(Si+1)

(6)

式(6)中:![]()

回归分支中采用的IOU损失函数表达式为

![]()

(7)

式(7)中:Intersection(A,B) 是预测框A与目标真实框B的交集,Union(A,B) 是预测框A与目标真实框B的并集。由上述各分支的损失函数得到最终的总损失函数。分支结构的总损失函数为QFL损失函数、DFL损失函数、IOU损失函数的权重和,公式如下:

![]()

(8)

式(8)中:LQ对应QFL损失函数;LD对应DFL损失函数;LB对应IOU损失函数;Npos表示正样本数量;λ0取为2,λ1取为1/4,λ0和λ1用来平衡LB和LD的权重。![]() 是指示函数,若

是指示函数,若![]() 则为1,否则为0。训练过程中,通过上述总损失函数来优化网络框架参数,得到高性能跟踪器。

则为1,否则为0。训练过程中,通过上述总损失函数来优化网络框架参数,得到高性能跟踪器。

2 实验

2.1 实验细节

本实验使用Ubuntu 20.04系统,CPU型号为i7-10700,GPU为2张RTX2080Ti,深度学习框架为Pytorch 1.12.1,Python版本为3.9。将修改后的AlexNet网络结构在ImageNet数据集上进行预训练,然后在ImageNetVID、ImageNetDET、COCO、GOT-10k上进行30轮的迭代训练。将批量大小设置为32,模板图像大小设置为127×127,搜索图像大小设置为255×255。选用随机梯度下降的方法来优化模型,初始学习率设置为0.001。前10轮,在训练IOU质量评估分支与回归分支的时候,特征提取与特征合并子网络的参数被冻结。10轮之后,解冻Alexnet的后4个卷积层加入训练。整个训练过程大约是24 h。在测试期间,使用离线的跟踪策略,仅提供模板分支上初始帧的目标位置。在跟踪过程中,特征提取与特征合并子网络的模板分支被预先计算且固定。当前帧的搜索区域图像被当作搜索分支的输入。训练所得网络框架在OTB-100[23]、UAV123、GOT-10K[24]3个数据集上进行测试。

2.2 OTB100上的实验数据

OTB数据集是目标跟踪领域中比较经典的测试集,使用精度和成功率这2个评价指标来测试本文提出的框架。本文与SiamRPN、DaSiamRPN[25]、SiamCAR、SiamFC[26]、SiamFC++、SiamRPN++、SiamDW[27]、SiamBAN[28]等8个先进的跟踪器做了对比。如图3所示,本文提出的框架的成功率得分为0.676,排名第5,精度为0.897,排名第4,成功率与精度均比同样使用AlexNet作为特征提取网络的SiamRPN要高5个百分点左右,比使用ResNet50深层网络结构作为特征提取网络的SiamFC++、SiamRPN++、SiamCAR等算法的性能相差不超过3个百分点,证明了本文所提框架,在大幅轻量化的同时保证了相对良好的性能。

图3 在OTB-100上不同跟踪器的实验结果

Fig.3 Experimental results of different trackers on the OTB-100 dataset

2.3 GOT-10K上的实验数据

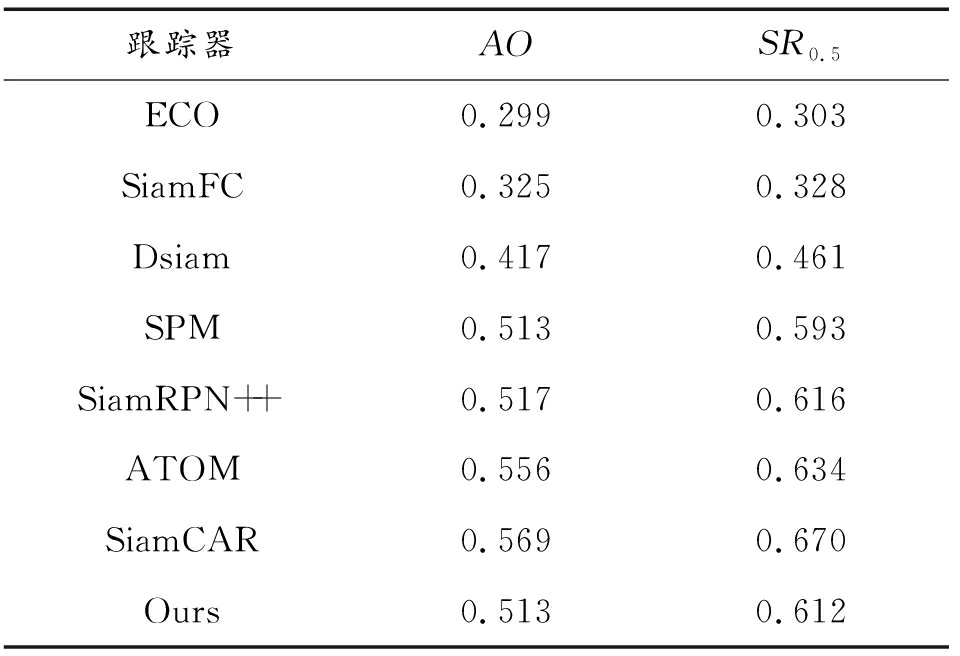

GOT-10K是大型目标跟踪数据集,覆盖560类常见移动目标,包含10 000多个视频序列。训练过程都由官方提供的数据集进行,保证了测试的公平性。数据集提供的评价指标包括平均重叠率(AO)、成功率(SR)。AO表示估计边界框和真实框之间的平均重叠率,SR0.5表示重叠率超过0.5的成功跟踪帧的比例。在GOT-10K上进行测试,与ECO[29]、SiamFC、Dsiam、SPM[30]、SiamRPN++、ATOM[31]、SiamCAR、DiMP[32]等9个跟踪器的结果进行比较。如表1所示,本文跟踪器在AO、SR0.5上的分数表现良好,仅比SiamRPN++低不到1个百分点,但跟踪速度是160 fps,而SiamRPN++只有35 fps。证明了本文在使用轻量化网络结构的同时,一定程度上保证了性能,符合巡飞弹平台的特殊要求。因为跟踪器使用相同的训练集和测试集,所以跟踪结果比其他基准上的结果更具说服力。

表1 在GOT-10K上不同跟踪器的实验结果

Table 1 Experimental results of different trackers on the GOT-10K dataset

跟踪器AOSR0.5ECO0.2990.303SiamFC0.3250.328Dsiam0.4170.461SPM0.5130.593SiamRPN++0.5170.616ATOM0.5560.634SiamCAR0.5690.670Ours0.5130.612

2.4 UAV123上的实验数据

UAV123数据集是从低航空视角捕获的视频数据,它包括123个视频序列,有超过11万帧的图片,适合无人机任务类型的数据测试,与巡飞弹平台的作战环境相似,更能说明本算法的有效性。数据集中主要面对的挑战有:快速移动、大尺度变化、大光照变化、遮挡等,有较强的挑战性。评估指标是一次性评估的精确度和成功率。将本文框架在UAV123上进行测试,并与SiamAttn[33]、SiamCAR、CGACD[34]、SiamRPN++、SiamBAN、SiamTPN[35]、SiamRPN、SiamDW这8个跟踪器进行比较。UAV123上不同跟踪器的实验结果如图4所示。

图4 UAV123上不同跟踪器的实验结果

Fig.4 Experimental results of different trackers on the UAV123 dataset

本文算法在2个指标中均排名第四,比同为AlexNet框架的SiamRPN的指标分数均高了2.3个百分点,表明了本文提出的特征融合方法是有效的。仅比排名前3的跟踪器性能低不到2个百分点,且前3名跟踪器所用框架均为深层网络,计算量大幅超过Alexnet浅层网络,不利于巡飞弹的硬件平台进行实时跟踪。由数据可知,本算法在巡飞弹平台上可以兼顾性能与实时跟踪速度,有一定的优越性。

在此以UAV123数据集为基础进行了消融实验。消融实验是:通过改变特征融合时的4个特征图通道比例数来选取一组合适的参数。总共选取了8组参数:1∶4∶3∶2;1∶4∶2∶1;1∶3∶2∶1;2∶3∶2∶1;3∶3∶2∶1;3∶2∶2∶1;4∶3∶2∶1;4∶3∶2∶2。如表2所示,第1组参数所得结果优于其他组参数,所以本文选择第1组参数来作为特征融合时的通道比例。

表2 不同通道比例的实验结果

Table 2 Experimental results of different channel ratios

通道比例成功率精度1∶4∶3∶20.6040.7951∶4∶2∶10.5920.7781∶3∶2∶10.5970.7842∶3∶2∶10.5940.7803∶3∶2∶10.5900.7763∶2∶2∶10.5870.7734∶3∶2∶10.5820.7724∶3∶2∶20.5860.776

3 结论

本文算法以160 fps的帧率在OTB-100、GOT-10K、UAV123三个数据集上取得了较先进的性能,可在巡飞弹平台上以实时帧率进行目标跟踪。框架结构简单,可加入其他模块来进一步提升跟踪性能,主要贡献有:

1) 提出一种新的特征融合方法,充分地利用了深浅层特征所涵盖的空间特征与语义特征。同时引入特征合并的方式,在每层进行横向的特征融合,对提出的纵向特征融合方式进一步加强。

2) 根据巡飞弹的硬件限制与任务需求,借鉴了IOU质量评估分支,取代了分类分支,保证精度的同时,降低了参数量,提升了跟踪速度。

3) 提出一个基于特征融合的无锚框全卷积孪生网络框架。本框架相对简单且性能较高,有较好的跟踪实时性。

[1]周千里,张文靖,赵路平,等.面向个体人员特征的跨模态目标跟踪方法[J].北京航空航天大学学报,2020,46(9):1635-1642.ZHOU Qianli,ZHANG Wenjing ZHAO Luping,et al.Cross-modal object tracking algorithm based on pedestrian attribute[J].Journal of Beijing University of Aeronautics and Astronautics,2020,46(9):1635-1642.

[2]LI B,YAN J J,WU W,et al.High performance visual tracking with siamese region proposal network[C]//CVPR,2018:8971-8980.

[3]GUO D,WAN J,CUI Y,et al.SiamCAR:siamese fully convolutional classification and regression for visual tracking[C]//CVPR,2020:6268-6276.

[4]ZHANG Z P,PENG H W,FU J L,et al.Ocean:object-aware anchor-free tracking[C]//ECCV,2020:771-787.

[5]XU Y D,WANG Z Y,LI Z X,et al.SiamFC++:towards robust and accurate visual tracking with target estimation guidelines[C]//Proceedings of the AAAI Conference on Artificial Intelligence,2020:12549-12556.

[6]周丽芳,刘金兰,李伟生,等.基于IoU约束的孪生网络目标跟踪方法[J/OL].北京航空航天大学学报.2022,48(8):1390-1398.ZHOU Lifang,LIU Jinlan,LI Weisheng,et al.Siamese network object tracking method based on iou constraint[J/OL].Journal of Beijing University of Aeronautics and Astronautics,2022,48(8):1390-1398.

[7]LI B,WU W,WANG Q,et al.SiamRPN++:evolution of siamese visual tracking with very deep networks[C]//CVPR,2019:4282-4291.

[8]ZHANG Chuancong,LI Fanming,RAO Junmin.Infrared small target detection based on feature saliency fusion[J].Semiconductor Optoelectronics,2022,43(4):828-834.

[9]YOO H J.Deep convolution neural networks in computer vision:a review[J].IEIE Transactions on Smart Processing &Computing,2015,4(1):35-43.

[10]SIMONYAN K,ZISSERAMN A.Very deep convolutional networks for large-scale image recognition[C]//Proceedings of the 3rd International Conference on Learning Representations,2015:1-14.

[11]SZEGEDY C,LIU W,JIA Y,et al.Going deeper with convolutions[C]//CVPR,2015:1-9.

[12]SANDLER,MARK,HOWARD,et al.MobileNetV2:inverted residuals and linear bottlenecks[C].CVPR,2018:4510-4520.

[13]CUONG D D,HUA X H,MORERE O,et al.Maritime vessel images classification using deep convolutional neural networks[C]//ACM International Conference Proceeding Series,2015:276-281.

[14]EVAN S,JONATHAN L,TREVOR D.Fully convolutional networks for semantic segmentation[J].IEEE transactions on pattern analysis and machine intelligence,2017,39(4):640-651.

[15]BELL S,ZITNICK C,BALA K,et al.Inside-outside net:detecting objects in context with skip pooling and recurrent neural networks[C]//CVPR,2016,2874-2833.

[16]CARLOS N,VICTOR G F.HyperNet:A conditional k-anonymous and censorship resistant decentralized hypermedia architecture[J].Expert Systems With Applications,2022,208:200-208.

[17]GUAN B,YAO J K,ZHANG G S,et al.Thigh fracture detection using deep learning method based on new dilated convolutional feature pyramid network[J].Pattern Recognition Letters,2019,125(C):521-526.

[18]SEBASTIAN O,et al.Image magnification regression using densenet for exploiting histopathology open access content[M].Springer International Publishing,2018:148-156.

[19]GUO Q,FENG W,ZHOU C,et al.Learning dynamic siamese network for visual object tracking[C]//Proceedings of the IEEE International Conference on Computer Vision(ICCV),2017:1781-1789.

[20]LI X,WANG W H,WU L J,et al.Generalized focal loss:learning qualified and distributed bounding boxes for dense object detection[C]//34th International Conference on Neural Information Processing Systems,2020:21002-21012.

[21]CAI Z W,VASCONCELOS N.Cascade R-CNN:delving into high quality object detection[C]//CVPR,2018:6154-6162.

[22]CHOI J,CHUN D Y,KIM H,et al.Gaussian YOLOv3:An accurate and fast object detector using localization uncertainty for autonomous driving[C]//ICCV,2019:502-511.

[23]WU Y,LIM J,YANG M H.Online object tracking:A benchmark[C]//CVPR,2013:2411-2418.

[24]HUANG L H,XIN Z,HUANG K Q,et al.GOT-10K:A large high-diversity benchmark for generic object tracking in the wild[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2021,43(5):1562-1577.

[25]ZHU Z,WANG Q, LI B.Distractor-aware siamese networks for visual object tracking[M].Springer International Publishing,2018:103-119.

[26]BERRTINETOO L,VALMADRE J,HENRIQUES J F,et al.Fully convolutional siamese networks for object tracking[C]//European Conference on Computer Vision(ECCV),2016:850-865.

[27]ZHANG Z P,PENG H W,WANG Q.Deeper and wider siamese networks for real-time visual tracking[C]//CVPR,2019,4586-4595.

[28]CHEN Z,ZHONG B,LI G,et al.Siamese box adaptive network for visual tracking[C]//CVPR,2020:6667-6676.

[29]DANELLJAN M,BHAT G,KHAN F S,et al.ECO:Efficient convolution operators for tracking[C]//CVPR,2017:6931-6939.

[30]LAZEBNIK S,SCHMID C,PONCE J.Beyond bags of features:Spatial pyramid matching for recognizing natural scene categories[C]//CVPR,2006,2:2169-2178.

[31]DANELLIAN M,BHAT G,KHAN F C,et al.ATOM:Accurate tracking by overlap maximization[C]//CVPR,2019,4655-4664.

[32]BHAT G,DANELLIAN M,GOOL L,et al.Learning discriminative model prediction for tracking[C]//ICCV,2018,6181-6190.

[33]YU Y,XIONG Y,HUANG W,et al.Deformable siamese attention networks for visual object tracking[C]//CVPR,2020:6727-6736.

[34]DU F,LIU P,ZHAO W,et al.Correlation-guided attention for corner detection based visual tracking[C]//CVPR,2020:6835-6844.

[35]XING D T,EVANGELIOU N,TSOUKALAS A,et al.Siamese transformer pyramid networks for real-time uav tracking[C]//WACV,2022:1898-1907.